Долгосрочное среднее значение случайной величины

В теории вероятностей, ожидаемое случайной величины  , обозначенное

, обозначенное  или

или ![E [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/e455a34363c03fc5df8208d8b81fa29e3cdd524e) , является обобщением средневзвешенного значения и интуитивно является арифметическим означает из большогоколичества независимых реализаций из

, является обобщением средневзвешенного значения и интуитивно является арифметическим означает из большогоколичества независимых реализаций из  . Ожидаемое значение также известно как ожидание, математическое ожидание, среднее, среднее или первый момент . Ожидаемая стоимость - понятие в , финансах и многих других предметах.

. Ожидаемое значение также известно как ожидание, математическое ожидание, среднее, среднее или первый момент . Ожидаемая стоимость - понятие в , финансах и многих других предметах.

По определению, ожидаемому значению постоянной альтернативы  равно

равно  . Ожидаемое значение случайной величины

. Ожидаемое значение случайной величины  с равновероятным результатами

с равновероятным результатами  определяется как среднее арифметическое терминов

определяется как среднее арифметическое терминов  Если некоторые из вероятностей

Если некоторые из вероятностей  индивидуального результата

индивидуального результата  не равны, тогда ожидаемое значениеопределяется как среднее взвешенное значение

не равны, тогда ожидаемое значениеопределяется как среднее взвешенное значение  s, то есть сумма

s, то есть сумма  продуктов

продуктов  . Ожидаемое значение общей случайной величины включает интегрирование в смысле Лебега.

. Ожидаемое значение общей случайной величины включает интегрирование в смысле Лебега.

Содержание

- 1 История

- 2 Обозначения

- 3 Определение

- 3.1 Конечный случай

- 3.2 Счетно бесконечный случай

- 3.3 Абсолютно непрерывный случай

- 3.4 Общий случай

- 4 Основные

- 5 Использование и приложение

- 5.1 Обмен пределы и ожидание

- 5.2 Неравенства

- 5.3 Ожидаемые значения общих распределений

- 6 Связь с характеристической функцией

- 7 См. также

- 8 Ссылки

- 9 Литература

История

Идея математического ожидания возникла в середине 17 из исследования так называемой проблемы очков, которая стремится справедливо разделить ставкимежду двумя игроками, которые заканчивают свою игру до того, как она закончится должным образом. Эта проблема обсуждалась веками, и за эти годы было предложено множество противоречивых предложений и решений, когда она была поставлена Блезом Паскалем французским писателем и математиком-любителем Шевалье де Мере в 1654. Мере утверждал, что эту проблему невозможно решить, насколько ошибочной была математика, когда дело доходило до ее применения в реальном мире. Паскаль,будучи математиком, был спровоцирован и полон решимости решить проблему раз и навсегда.

Он начал обсуждать проблему в уже известной серии писем Пьеру де Ферма. Вскоре они независимо друг от друга придумали решение. Они решили проблему вычислительными методами, потому что их вычисления были основаны на одном и том же фундаментальном принципе. Принцип состоит в том, что стоимость будущей прибыли должна быть прямо пропорциональна шансам на ее получение. Этот принцип казался имобоим естественным. Они были очень довольны тем фактом, что они были, по сути, такое же решение, и это, в свою очередь, сделало их абсолютно решенными в том, что они решили проблему окончательно; однако они не опубликовали свои выводы. Они об этом сообщили лишь небольшому кругу общих научных друзей в Париже.

Три года спустя, в 1657 году, голландский математик Христиан Гюйгенс, только что посетивший Париж, опубликовал трактат (см. Гюйгенс (1657)) «De ratiociniis inludo ale »по теории вероятностей. В этой книге он рассмотрел проблему точек и представил решение, основанное на том же принципе, что и решения Паскаля и Ферма. Гюйгенс также расширил концепцию ожидания, добавив правила расчета ожидания в более сложных ситуациях, чем исходная задача (например, для трех или более игроков). В этом смысле эту книгу можно рассматривать как первую успешную попытку заложить основы теории вероятностей.

В предисловии к своей книге Гюйгенс написал:

Следуеттакже сказать, что в некотором времени некоторые из лучших математиков Франции занимались этим исчисления, так что никто не должен приписывать мне честь первого изобретения. Это не принадлежит мне. Но эти учащиеся, участвуют в опросе друг друга испытание, вызывают друг свои методы для решения вопросов. Поэтому я должен был изучить этот вопрос, начав с элементов, и по этой причине я не могу утверждать, что я даже начал с того же принципа. В конце концов, я обнаружил, что мои ответы во многихслучаях отличаются от их.

— Эдвардс (2002)

Таким образом, Гюйгенс узнал о Проблеме де Мере в 1655 году во время своего визита во Францию; позже, в 1656 г. из его переписки с Каркави, он узнал, что его метод по сути такой же, как и у Паскаля; так что еще до того, как его книга поступила в печать в 1657 году, он знал о приоритете Паскаля в этом вопросе.

Этимология

Ни Паскаль, ни Гюйгенс не использовали термин «ожидание» в его современном смысле. В частности,Гюйгенс пишет:

Что любой шанс или ожидание выиграть какую-либо вещь стоит ровно такую сумму, которую вы бы получили при тех же шансах и ожиданиях при честном слове.... Если я ожидаю a или b и имею равные шансы получить их, мое ожидание стоит (a + b) / 2.

Более чем сто лет спустя, в 1814 году, Пьер-Симон Лаплас опубликовал свой трактат «Аналитическая теория вероятностей», в которой понятие ожидаемой стоимости было определено явно:

… это преимущество в теориислучайности является произведением, на рассчитывают, на вероятность ее достижения; это частичная сумма, которая должна быть получена, когда мы не желаем рисковать событием, предполагаемая, что деление пропорционально вероятности. Это разделение является единственно справедливым, когда устранены все странные обстоятельства; потому что равная степень вероятности равное право на получение ожидаемой суммы. Мы будем называть это преимуществом математической надеждой.

Обозначения

Использование буквы  для обозначения ожидаемого значения восходит к W. А. Уитворт в 1901 году. С тех пор стал символным популярным среди английских писателей. На немецком языке

для обозначения ожидаемого значения восходит к W. А. Уитворт в 1901 году. С тех пор стал символным популярным среди английских писателей. На немецком языке  означает «Erwartungswert», на испанском - «Esperanza matemática», а на французском - «Espérance mathématique». 273>

означает «Erwartungswert», на испанском - «Esperanza matemática», а на французском - «Espérance mathématique». 273>

Другое популярное обозначение -  ,тогда как

,тогда как  обычно используется в физике, а

обычно используется в физике, а  в русскоязычной литературе.

в русскоязычной литературе.

Определение

Конечный регистр

Пусть  случайная величина с конечным числом конечных результатов

случайная величина с конечным числом конечных результатов  встречается с вероятностями

встречается с вероятностями  соответственно. ожидание для

соответственно. ожидание для  означает как

означает как

![{\ displaystyle \ operatorname {E} [X] = \ sum _ {i = 1} ^ {k} x_ {i} \, p_{i} = x_ {1} p_ {1} + x_ {2} p_ {2} + \ cdots + x_ {k} p_ { k}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/519542ccdb827d224e730020a1f0c0ce675297d3)

Форма всех вероятностей  равна 1 (

равна 1 ( ), ожидаемое значение - это взвешенное количество значений

), ожидаемое значение - это взвешенное количество значений  , причем значения

, причем значения  являются весами.

являются весами.

Если все исходы  равновероятны (то есть

равновероятны (то есть  ), тогда средневзвешенное значение превращается в простое среднее. С другой стороны, если исходы

), тогда средневзвешенное значение превращается в простое среднее. С другой стороны, если исходы  не равновероятны, тогда простое среднее значение необходимо заменить средневзвешенным, что учитывает тот факт, что некоторые результаты более вероятны, чем другие.

не равновероятны, тогда простое среднее значение необходимо заменить средневзвешенным, что учитывает тот факт, что некоторые результаты более вероятны, чем другие.

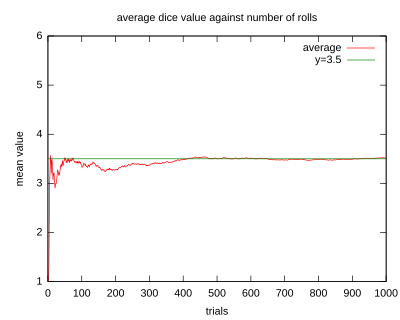

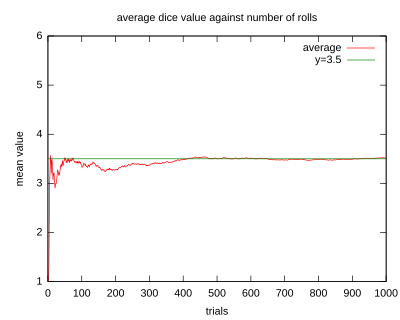

Иллюстрация сходимости средних значений бросков

кубика к ожидаемому значению 3,5 по мере увеличения количества бросков (испытаний).

Примеры

- Пусть

представит результат броска честного шестигранного кубика . Более конкретно,

представит результат броска честного шестигранного кубика . Более конкретно,  будет содержать области, отображаемых на верхней поверхности кубика после подбрасывания. Возможные значения для

будет содержать области, отображаемых на верхней поверхности кубика после подбрасывания. Возможные значения для  : 1, 2, 3, 4, 5 и 6, все из равновероятны с вероятностью 1/6. Математическое ожидание

: 1, 2, 3, 4, 5 и 6, все из равновероятны с вероятностью 1/6. Математическое ожидание  is

is

![{\ displaystyle \ operatorname {E} [X] = 1 \ cdot {\ frac {1} {6}} + 2 \ cdot {\ frac {1} {6}} + 3 \ cdot {\ frac {1} {6}} + 4 \ cdot {\ frac {1} {6}} + 5 \ cdot {\ frac {1} {6}} + 6 \ cdot {\ frac {1} {6}} = 3.5.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d535e1c37fd63db36fd0878e39b43ea7fa513ea4)

- Если бросить кубик

раз и вычислить среднее (среднее арифметическое ) результатов, то как

раз и вычислить среднее (среднее арифметическое ) результатов, то как  растет, среднее почти наверняка сходится к ожидаемому значению, факт, известный как строгий закон большие числа.

растет, среднее почти наверняка сходится к ожидаемому значению, факт, известный как строгий закон большие числа.

- Игра в рулетку состоит из маленького шарика и колеса с 38пронумерованными лузами по краю. Когда колесо вращается, шарик хаотично раскачивается, пока не в одном из карманов. Предположим, что случайная величина

представляет (денежный) результат ставки в 1 доллар на одно число ("прямая" ставка). Если ставка выигрывает (что происходит с вероятностью 1/38 в американской рулетке), выплата составляет 35 долларов; в противном случае игрок теряет ставку. Ожидаемая прибыль от таких ставок составит

представляет (денежный) результат ставки в 1 доллар на одно число ("прямая" ставка). Если ставка выигрывает (что происходит с вероятностью 1/38 в американской рулетке), выплата составляет 35 долларов; в противном случае игрок теряет ставку. Ожидаемая прибыль от таких ставок составит

![{\ displaystyle \ operatorname {E} [\, {\ text {прирост от}} \ $ 1 {\ text {bet}} \,] = - \ $ 1 \ cdot {\ frac {37}{38}} + \ $ 35 \ cdot {\ frac {1} {38}} = - \ $ {\ frac {1} {19}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/efa6df424d69a14b24a7b598b5e0f1e6e426bff1)

- То есть ставка в 1 доллар проигрывает

, поэтому его ожидаемое значение составляет

, поэтому его ожидаемое значение составляет

Счетно-бесконечныйслучай

Интуитивно, ожидание случайной величины, принимающей значения в счетном наборе результатов, определяется аналогично как взвешенная сумма итоговых значений, где соответствуют вероятности реализации этой ценности. Однако проблемы сходимости, связанные с бесконечной суммой, требуют более тщательного определения. Строгое определение сначала определяет математическое ожидание неотрицательной случайной величины, а затем адаптирует его к общим случайным величинам.

Пусть  будет неотрицательной случайной величиной со счетным набором результатов

будет неотрицательной случайной величиной со счетным набором результатов  встречающиеся с вероятностями

встречающиеся с вероятностями  соответственно. Аналогично дискретному случаю, ожидаемое значение

соответственно. Аналогично дискретному случаю, ожидаемое значение  затем определяется как ряд

затем определяется как ряд

![{\ displaystyle \ operatorname {E} [X] = \ sum _ {i = 1} ^ {\ infty} x_ {i} \, p_ {i}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2509d047fc89077d41febe60520c076d55386608)

Обратите внимание, что, поскольку  , бесконечная сумма четко определена и не зависит от порядка, в котором она вычисляется. В крайнем случае, здесь математическое ожидание может быть равно бесконечности.

, бесконечная сумма четко определена и не зависит от порядка, в котором она вычисляется. В крайнем случае, здесь математическое ожидание может быть равно бесконечности.

Для общей (не обязательно неотрицательной) случайной величины  со счетным числом текущих результатов установки

со счетным числом текущих результатов установки  и

и  . По определению

. По определению

![{\ displ aystyle \ имя оператора {E} [X] = \ имя оператора {E} [X ^ {+}] - \ имя оператора {E} [X ^ {-}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d54be7ea6dcbc06bf807cc33a18128131487a841)

Как и в случае неотрицательных случайных величин, ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) снова может быть конечным или бесконечным.Третий вариант здесь заключается в том, что

снова может быть конечным или бесконечным.Третий вариант здесь заключается в том, что ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) больше не гарантирует правильного определения. Последнее происходит всякий раз, когда

больше не гарантирует правильного определения. Последнее происходит всякий раз, когда ![{\ displaystyle \ operatorname {E} [X ^ {+}] =\ operatorname {E} [X ^ {-}] = \ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/39208448351df3073fb3667060ff9e29ed6156cc) .

.

Примеры

- Предположим, что

и

и  для

для  , где

, где  (с

(с  (натуральный логарифм ) - это масштабный коэффициент, при котором сумма вероятностей равна 1. Тогда, используя прямое определение для неотрицательных случайных величин, мы имеем

(натуральный логарифм ) - это масштабный коэффициент, при котором сумма вероятностей равна 1. Тогда, используя прямое определение для неотрицательных случайных величин, мы имеем

![{\ displaystyle \ operatorname {E} [X] = \ sum _ {i} x_ {i} p_ {i} = 1 \ left ({\ frac {k} {2}} \ right) +2 \ left ({\ frac {k} {8}} \ right) +3 \ left ({\ frac {k}{24}} \ right) + \ dots = {\ frac {k} {2}} + {\ frac {k} {4}} + {\ frac {k} {8}} + \ dots = k.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/080fb218bb6f48d69e19c8694dae679684ca1c15)

- Пример, когда ожидание бесконечно, возникает в контексте Ул. Петербургский парадокс. Пусть

и

и  для

для  . Еще раз, как случайная величина неотрицательна, расчет ожидаемого значения дает

. Еще раз, как случайная величина неотрицательна, расчет ожидаемого значения дает

![{\ displaystyle \ operatorname { E} [X] = \ sum _ {i = 1} ^ {\ infty} x_ {i} \, p_ {i} = 2 \ cdot {\ frac {1} {2}} + 4 \ cdot {\ frac {1} {4}} + 8 \ cdot {\ frac {1} {8}} + 16 \ cdot {\ frac{1} {16}} + \ cdots = 1 + 1 + 1 + 1 + \ cdots \, = \ infty.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7a04de85e01c5cc27e3e1635493583dd39c3fd38)

- В качестве примера, гдематематическое ожидание не определено четко, предположим, что случайная величина

принимает значения

принимает значения  с вероятностями

с вероятностями  ,..., где

,..., где  - нормализующая константа,которая гарантирует, что сумма вероятностей равна единице.

- нормализующая константа,которая гарантирует, что сумма вероятностей равна единице.

- Следовательно, следует, что

принимает значение

принимает значение  с вероятностью

с вероятностью  для

для  и принимает значение

и принимает значение  с оставшейся вероятностью. Точно так же

с оставшейся вероятностью. Точно так же  принимает значение

принимает значение  с вероятностью

с вероятностью  для

для  и принимает значение

и принимает значение  с оставшейся вероятностью. Используя определение неотрицательных случайных величин, можно показать, что и

с оставшейся вероятностью. Используя определение неотрицательных случайных величин, можно показать, что и ![{\ displaystyle \ operatorname {E} [X ^ {+}] = \ infty }](https://wikimedia.org/api/rest_v1/media/math/render/svg/349709705912ec5400d727e0047361874e8af27e) и

и ![{\ displaystyle \ operatorname {E} [X ^ {-}] = \ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4ac976e9034564f71b3627c8063ee2a0d3fbaff3) (см. Гармонический ряд ). Следовательно, ожидание

(см. Гармонический ряд ). Следовательно, ожидание  не является четко определенным.

не является четко определенным.

Абсолютно непрерывный регистр

Если  - случайная величина с функция плотности вероятности из

- случайная величина с функция плотности вероятности из  , тогда ожидаемое значение определяется как Интеграл Лебега

, тогда ожидаемое значение определяется как Интеграл Лебега

![{\ displaystyle \ operatorname {E} [X] = \ int _ {\ mathbb {R}} xf (x) \, dx,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b6b4021050b825064c6e43aefc7694fb6307bc30)

, где значения на сторонах четко или не согласовы одновременно.

Пример. Случайная величина с распределением Коши имеет значение функции плотности, но ожидаемое значение не определено, так как распределение большие «хвосты».

Общий случай

Как правило, если  является случайной величиной, определенно в вероятностном пространстве

является случайной величиной, определенно в вероятностном пространстве  , затем ожидаемое значение

, затем ожидаемое значение  , обозначается

, обозначается ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) , определяется как интеграл Лебега

, определяется как интеграл Лебега

![{\ displaystyle \ operatorname {E} [X] = \ int _{\ Omega} X (\ omega) \, d \ operatorname {P} (\ omega).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f2c4265bd78bfc615c6da1f1fae310d462793187)

Для многомерных случайных величин их ожидаемое значение равно определяется для каждого компонента. То есть

![{\ displaystyle \operatorname {E} [(X_ {1}, \ ldots, X_ {n})] = (\ oper atorname {E} [X_ {1}], \ l dots, \ operatorname {E} [X_ {n}])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/82529dea1fae623cf096f6e7955332fa73bf791a)

и для случайной матрицы  с элементами

с элементами  ,

, ![{\ displaystyle (\ operatorname {E} [X]) _ {ij} = \ operatorname {E} [X_ {ij}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5581856278a0f539aaa981d81fce64e5a35fff7a)

Основные свойства

Основные свойства ниже (и их названия жирным шрифтом) повторяют илисразу следуют из интеграла Лебега. Обратите внимание, что буквы «а.с.» обозначают «почти наверняка » - центральное свойство интеграла Лебега. По сути, говорят, что неравенство типа  почти верно, когда вероятностная мера приписывает нулевую массу дополнительному событию

почти верно, когда вероятностная мера приписывает нулевую массу дополнительному событию  .

.

- Для общей случайной величина

определите, как и раньше,

определите, как и раньше,  и

и  , обратите внимание, что

, обратите внимание, что  , причем как

, причем как  , так и

, так и  неотрицательно, тогда:

неотрицательно, тогда:

![{\ displaystyle \ operatorname {E} [X] = {\ begin { case} \ operat orname {E} [X ^ {+}] - \ operatorname {E} [X ^ {-}] {\ text {if}} \ operatorname {E} [X ^ {+}] <\ infty {\ text {and}} \ operatorname {E} [X ^ {- }] <\ infty; \\\ infty {\ text {if}} \ operatorname {E} [X ^ {+}] = \ infty {\ text {and}} \ operatorname {E} [X ^ {-}] <\ infty; \\ - \ infty {\ text {if}} \ operatorname {E} [X ^ {+}] <\ infty {\ text {and}} \ operatorname {E} [X ^ {-}]= \ infty; \\ {\ text {undefined}} {\ text {if}} \ operatorname {E} [X ^ { +}] = \ infty {\ text {and}} \operatorname {E} [X ^ {-}] = \ i nfty. \ end {case}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c80257845a8fa7e82404f267002d9714dec21cd0)

- Пусть

обозначает индикаторную функцию для события

обозначает индикаторную функцию для события  , тогда

, тогда ![{\ Displaystyle \ OperatorName {E} [{\ mathbf {1}} _ {A}] = 1 \ cdot \ OperatorName {P} (A) +0 \ cdot \ operatorn ame {P} (\ Omega \ setm inus A) = \ operatorname {P} (A).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/49c23205ce0226e3a5e807040eea3ef1663e8542)

- Формулы в терминах CDF: Если

является кумулятивным функцией распределения вероятностной меры

является кумулятивным функцией распределения вероятностной меры  и

и  - случайная величина, тогда

- случайная величина, тогда

![{\ displaystyle \ operatorname {E} [X] = \ int _ {\ overline {\ mathbb{R}}} x \, dF (x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8e2749d3c6bcc1ae1ec924cd1e0406f34a3c11e9)

- , где взятых на себя совместных решений взятых на себя взят в смысле Lebesgue-Stieltjes. Здесь

![{\ displaystyle {\ overline {\ mathbb {R}}} = [- \ infty, + \ infty]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92df65c7a6de4a17db586e79121da6e9de7aaf17) - расширенное вещественное числостроки.

- расширенное вещественное числостроки.

- Кроме того,

![{\ displaystyle \ displaystyle \ operatorname {E} [X] = \ int \ limits _ {0} ^ {\ infty} (1-F (x)) \, dx- \ int \ limits _ {- \ infty} ^ {0} F (x) \, dx,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e17ad7f7a7f00bc58379675c943ad21ee18120e8)

- с интегралами, взятыми в смысле Лебега.

- Доказательство второй формулы следует.

| Доказательство. |

Для произвольного

Последнее равенство выполняется, потому что  где где  означает, что означает, что  и, следовательно, и, следовательно,  И наоборот, если И наоборот, если  где где  , затем , затем  и и

Подынтегральное выражение вприведенном вышевыражении для  неотрицательно, поэтому применяется теорема Тонелли, и порядок интегрирования может быть изменен без изменения результата. Имеем неотрицательно, поэтому применяется теорема Тонелли, и порядок интегрирования может быть изменен без изменения результата. Имеем

Рассуждая, как указано выше,

и

Напоминая, что  завершаетдоказательство. завершаетдоказательство. |

- Неотрицательность: Если

(as), то

(as), то ![{\ displaystyle \ Operatorname {E} [X] \ geq 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc359a5fbc4d9b691dceba58a5fd3cc7120cda15) .

. - Линейность ожидания: Оператор ожидаемого значения (или оператор ожидания )

![\ operatorname {E} [\ cdot]](https://wikimedia.org/api/rest_v1/media/math/render/svg/0a71518eb57ffaf54c0c31bf94de5ac9d7ab11a1) является линейным в том смысле, что для любых случайных величин

является линейным в том смысле, что для любых случайных величин  и

и  и константа

и константа  ,

,

![{\ displaystyle {\ begin {align} \ operatorname {E} [X + Y] = \ operatorname {E} [X] + \ operatorname {E} [Y], \\\ operatorname {E} [aX] = a \ operatorname {E} [X], \ end {align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3d3a0fa4f32e29c4cc4fd567a63afc384a7e3b91)

- , если правая часть четко определена. Это означает, что ожидаемое значение суммы любого конечного числа случайных величин является суммой ожидаемых значений отдельных случайных величин, а ожидаемое значениелинейномасштабируется с мультипликативной константой.

- Монотонность: Если

(as), и оба

(as), и оба ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) и

и ![{\ displaystyle \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/639e8577c6faffc0471c7e123ead30970034e6d5) существуют, тогда

существуют, тогда ![{\ displaystyle \ operatorname {E} [X] \ leq \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bcc409f2b956425dc9dacce39207930f60057d55) .

.

- Доказательство следует из линейности и свойства неотрицательности для

, поскольку

, поскольку  (as).

(as).

- Отсутствие мультипликативности: В общем, ожидаемое значение не является мультипликативным, т. Е.

![{\ displaystyle \ operatorname {E} [XY]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/612af0bbf256874e0b0551305574be507f9ff805) не обязательно равно

не обязательно равно ![{\ displaystyle \ operatorname {E} [X] \ cdot \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c52e5f76c5aad37aeeaf32d355681263e92aad24) . Если

. Если  и

и  являются независимыми, то можнопоказать,что

являются независимыми, то можнопоказать,что ![{\ displaystyle \ operatorname {E} [XY] = \ имя оператора {E} [X] \ имя оператора {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5cfc97e307911d3230962dd68be6a5c3dcaed71a) . Если случайные величины зависимы от, то обычно

. Если случайные величины зависимы от, то обычно ![{\ displaystyle \ operatorname {E} [XY] \ neq \ operatorname {E} [X] \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/088991fa5ad13b9421b1b14ed2b582fde070e4c1) , хотя в особых случаях зависимости равенство может выполняться.

, хотя в особых случаях зависимости равенство может выполняться. - Закон бессознательного статистика : Ожидаемое значение измеримой функции

,

,  , учитывая, что

, учитывая, что  имеет функцию плотности вероятности

имеет функцию плотности вероятности  , дается внутренним произведением из

, дается внутренним произведением из  и

и  :

:

![{\ displaystyle\ operatorname {E} [g (X)] = \ int _ {\ mathbb {R}} g (x) f (x) \, dx.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a417b7efdd5329bcd40b2efd4b8ed5bd3b031e52)

- Эта формула также верна в многомерном случае, когда

- это функция нескольких случайных величин, а

- это функция нескольких случайных величин, а  - их плотность соединения.

- их плотность соединения.

- Не -вырожденность: Если

![{\ displaystyle \ operatorname {E} [| X |] = 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ab8a77f734e7d3405900d794b5a323e2a6c58974) , затем

, затем  (as).

(as). - Для случайной величины

с четко определенным математическим ожиданием:

с четко определенным математическим ожиданием: ![{\ displ aystyle | \ operatorname {E} [X] | \ leq \ operatorname {E} | X |}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d950496113ee61bc1f496eecbadcf6bcc85e8d62) .

. - Следующие утверждения относительно случайной величины

являются эквивалент:

являются эквивалент: ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) существует и конечен.

существует и конечен.- Оба

![{\ displaystyle \ operatorname {E} [X ^ {+}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/21874fb6790ea26596fc561d88b159841c285fd3) и

и ![{\ displaystyle \ operatorname {E} [X ^ {-}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b27d36ddc1f0ffeb56f0f0e0dbc1aaa8ece17214) конечны.

конечны. ![{\ displaystyle \ имя оператора {E} [| X |]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a3590a8ce161c1bf1b1bc8ef9fe99407406f2400) конечно.

конечно.

- Поуказанным вышепричинам выражения "

является интегрируемым "и" ожидаемое значение

является интегрируемым "и" ожидаемое значение  конечно "взаимозаменяемо используются в этой статье.

конечно "взаимозаменяемо используются в этой статье.

- Если

![{\ displaystyle \ operatorname {E} [X] <+ \ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e04b1762cff984a0f687d746b5dc182a56244dfe) , затем

, затем  (as). Аналогичным образом, если

(as). Аналогичным образом, если ![{\displaystyle \operatorname {E} [X]>- \ infty}]( https://wikimedia.org/api/rest_v1/media/math/render/svg/92deed236efc7deaf9c34e1a3c7c346cce28279b ) , затем

, затем  (as).

(as). - Если

и

и  , затем

, затем

- Если

(as), то

(as), то ![{\ displaystyle \ operatorname {E} [X] = \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/206f1357b15162a6f9b14f8057fe8b75a6dc82e1) . Другими словами, если X и Y - случайные величины, которые принимают разные значения с вероятностью ноль, то ожидание X будет равно ожиданию Y.

. Другими словами, если X и Y - случайные величины, которые принимают разные значения с вероятностью ноль, то ожидание X будет равно ожиданию Y. - Если

(as) для некоторой константы

(as) для некоторой константы ![{\displaystyle c \ in [- \ infty, + \ infty]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/efc16e7f0da8125427c46522d4e0fa5449dc7131) , тогда

, тогда ![{\ displaystyle \ operatorname {E} [X] = c}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8c081385ba053a066911729481c89ad435cc8c6a) . В частности, для случайной величины

. В частности, для случайной величины  с четкоопределенным ожиданием

с четкоопределенным ожиданием ![{\ displaystyle \ operatorname {E} [\ operatorname {E} [X]] = \ operatorname {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7ff311903fa69e69841abfef5c018d9c43145dac) . Хорошо определенное ожидание подразумевает, что существует одно число или, скорее, одна константа, определяющая ожидаемое значение. Из этого следует, что математическое ожидание этой константы - это просто исходное ожидаемое значение.

. Хорошо определенное ожидание подразумевает, что существует одно число или, скорее, одна константа, определяющая ожидаемое значение. Из этого следует, что математическое ожидание этой константы - это просто исходное ожидаемое значение. - Для неотрицательной целочисленной случайной величины

![{\displaystyle \operatorname {E} [X]=\sum _{n=0}^{\infty }\operatorname {P} (X>n).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4386ec8a6164af8d3041d07ae990592d84657dd2)

| Доказательство. |

Если - P (X>n) ≥ P (X = + ∞)>0, {\ displaystyle \ operatorname {P} (X>n) \ geq \ operatorname {P} (X = + \ infty)>0,}

, поэтому ряд справа расходится к + ∞, {\ displaystyle + \ infty,} и равенство выполняется. и равенство выполняется.

Если P (X = + ∞) знак равно 0, {\ displaystyle \ operatorname {P} (X = + \ infty) = 0,} , затем , затем - ∑ n = 0 ∞ P (X>n) = ∑ n = 0 ∞ ∑ j = n + 1 ∞ P ( X = j). {\displaystyle \sum _{n=0}^{\infty }\operatorname {P} (X>n)=\sum _{n= 0}^{\infty }\sum _{j=n+1}^{\infty }\operatorname {P} (X=j).}

Define the infinite upper-triangular matrix - M = [ P ( X = 1) P ( X = 2) P ( X = 3) ⋯ P ( X = n) ⋯ P ( X = 2) P ( X = 3) ⋯ P ( X = n) ⋯ P ( X = 3) ⋯ P ( X = n) ⋯ ⋱ ⋮ P ( X = n) ⋯ ⋱ ]. {\displaystyle M={\begin{bmatrix}\operatorname {P} (X=1)\operatorname {P} (X=2)\operatorname {P} (X=3)\cdots \operatorname {P} (X=n)\cdots \\\operatorname {P} (X=2)\operatorname {P} (X=3)\cdots \operatorname {P} (X=n)\cdots \\\operatorname {P} (X=3)\cdots \operatorname {P} (X=n)\cdots \\\ddots \vdots \\\operatorname {P} (X=n)\cdots \\\ddots \end{bmatrix}}.}

The double series ∑ i = 1 ∞ ∑ j = i ∞ P ( X = j) {\displaystyle \textstyle \sum _{i=1}^{\infty }\sum _{j=i}^{\infty }\operatorname {P} (X=j)} is the sum of M {\displaystyle M} is the sum of M {\displaystyle M} 's elements if summation is done row by row. Since every summand is non-negative, the series either converges absolutely or diverges to + ∞. {\displaystyle +\infty.} 's elements if summation is done row by row. Since every summand is non-negative, the series either converges absolutely or diverges to + ∞. {\displaystyle +\infty.} In both cases, changing summation order does not affect the sum. Changing summation order, from row-by-row to column-by-column, gives us In both cases, changing summation order does not affect the sum. Changing summation order, from row-by-row to column-by-column, gives us - ∑ n = 0 ∞ ∑ j = n + 1 ∞ P ( X = j) = ∑ j = 1 ∞ ∑ n = 0 j − 1 P ( X = j) = ∑ j = 1 ∞ j P ( X = j) = ∑ j = 0∞ j P (X = j) = E [X]. {\ displaystyle {\ begin {align} \ sum _ {n = 0} ^ {\ infty} \ sum _ {j = n + 1} ^ {\ infty} \ operatorname {P} (X = j) = \ sum _ {j = 1} ^ {\ infty} \ sum _ {n = 0} ^ {j-1} \ operatorname {P} (X = j) \\ = \ sum _ {j = 1} ^ { \ infty} j \ OperatorName {P} (X = j) \\ = \ sum _ {j = 0} ^ {\ infty} j \ operatorname {P} (X = j) \\ = \ operatorname {E } [X]. \ End {align}}}

![{\ displaystyle {\ begin { выровнено} \ sum _ {n = 0} ^ {\ infty} \ sum_ {j = n + 1} ^ {\ infty} \ operatorname {P} (X = j) = \ sum _ {j = 1} ^ {\ infty} \ sum _ {n = 0}^ {j-1} \ operatorname {P} (X = j) \\ = \ sum _ {j = 1} ^ {\ infty} j \ operatorname { P} (X = j) \\ = \ sum _ {j = 0} ^ {\ infty} j \ operatorname {P} (X = j) \\ = \ operatorname {E} [X]. \ End {выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a30f0ae60992ffd04733080ac8363616732de4f9)

|

Использование и приложения

Ожидание случайной переменной играет важную роль вразличных контекстах. Например, в теории принятия решений, Часто предполагается, что агент, делающий оптимальный выбор в контексте неполной информации, максимизирует ожидаемое значение своей функции полезности. Для другого примера, в statistics, где ищут оценки для неизвестных параметров на основе доступных данных, оценка сама по себе является случайной величиной. В таких условиях желательным критерием «хорошей» оценки является то, что она несмещена ;то есть ожидаемое значение оценки равно истинному значению базовый параметр.

Можно построить ожидаемое значение, равное вероятности события, взяв ожидание индикаторной функции, которое равно единице, если событие произошло, и нулю в противном случае. Это отношение можно использовать для перевода свойств ожидаемых значений в свойства вероятностей, например с использованием закона больших чисел для обоснования оценки вероятностей по частотам.

Ожидаемыезначения степеней X называются несмещенным способом и имеет свойство минимизировать сумму квадратов остатков (сумма квадратов разностей между наблюдениями и оценкой ). Закон больших чисел демонстрирует (при довольно мягких условиях), что по мере увеличения размера выборки , дисперсия эта оценка становится меньше.

Это свойство часто используется в самых разных приложениях, включая общие задачи статистической оценки и машинного обучения, для оценки (вероятностных) интересующих величин с помощью методы Монте-Карло, поскольку большинство представляющих интерес величин можно записать в терминах математического ожидания, например п (X ∈ A) = E [1 A] {\ displaystyle \ operatorname {P} ({X \ in {\ mathcal {A}}}) = \ operatorname {E} [{\ mathbf { 1}} _ {\ mathcal {A}}]}![{\displaystyle \ operatorname {P} ({X \ in {\ mathcal {A}}}) = \ operatorname {E} [{\ math bf {1}} _ {\ mathcal {A}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bc2d627e0e24ccb93ccedb966935f49319f4fd25) , где 1 A {\ displaystyle {\ mathbf {1}} _ {\ mathcal {A}}}

, где 1 A {\ displaystyle {\ mathbf {1}} _ {\ mathcal {A}}} - индикаторная набор функцияфункция A {\ displaystyle {\ mathcal {A}}}

- индикаторная набор функцияфункция A {\ displaystyle {\ mathcal {A}}} .

.

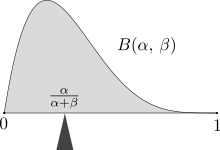

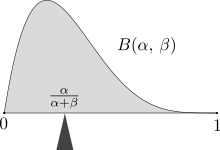

Масса распределения вероятностей сбалансированной на ожидаемом значении, здесь распределение с ожидаемым значением α / (α + β).

В классической механике, центр масс является концепцией, аналогичной математическому ожиданию. Например, предположим, что X - дискретная случайная величина со значениями x i и гарантирует вероятности p i. Теперь рассмотрим невесомый стержень,на котором размещены грузы вточках x i вдоль стержня и имеющий массу p i (сумма которых равна единице). Точка балансировки стержня - E [X].

Ожидаемые значения информативных вычислений дисперсии с помощью формулы для дисперсии

- Var (X) = E [X 2] - (E [X]) 2. {\ displaystyle \ operatorname {Var} (X) = \ operatorname {E} [X ^ {2}] - (\ operatorname {E} [X]) ^ {2}.}

![\ operatorname {Var} (X) = \ operatorname {E} [X ^ {2}] - (\ operatorname {E} [X]) ^ {2}.](https://wikimedia.org/api/rest_v1/media/math/render/svg/3704ee667091917e2e34f5b6e28e8d49df4b9650)

Очень важное применение математическое ожидание находится в области квантовой механики. Среднеезначение квантово-механического оператора A ^ {\ displaystyle {\ hat {A}}} , работающего с квантовым состоянием вектором | ψ⟩ {\ Displaystyle | \ psi \ rangle}

, работающего с квантовым состоянием вектором | ψ⟩ {\ Displaystyle | \ psi \ rangle} записывается как ⟨A ^⟩ = ⟨ψ | А | ψ⟩ {\ Displaystyle \ langle {\ hat {A}} \ rangle = \ langle \ psi | А | \ psi \ rangle}

записывается как ⟨A ^⟩ = ⟨ψ | А | ψ⟩ {\ Displaystyle \ langle {\ hat {A}} \ rangle = \ langle \ psi | А | \ psi \ rangle} . неопределенность в A ^ {\ displaystyle {\ hat {A}}}

. неопределенность в A ^ {\ displaystyle {\ hat {A}}} может быть рассчитана по формуле (Δ A) 2 =⟨A ^ 2⟩ - ⟨A ^⟩ 2 {\ displaystyle (\Delta A) ^ {2} = \ langle {\ hat {A}} ^ {2} \ rangle - \ langle {\ hat {A}} \ rangle ^ {2}}

может быть рассчитана по формуле (Δ A) 2 =⟨A ^ 2⟩ - ⟨A ^⟩ 2 {\ displaystyle (\Delta A) ^ {2} = \ langle {\ hat {A}} ^ {2} \ rangle - \ langle {\ hat {A}} \ rangle ^ {2}} .

.

Перестановка пределов и ожиданий

Как правило, E [X n] → E [X] {\ displaystyle \ operatorname {E} [X_ {n}] \ to \ operatorname { E} [X]}![{\ displaystyle \ operatorname {E} [X_ {n}] \ to \ operatorname {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2ac6f8237847b46129e5a1206c32caaf6535e2e9) несмотря на X n → X {\ displaystyle X_ {n} \ to X}

несмотря на X n → X {\ displaystyle X_ {n} \ to X} точечно. Таким образом, нельзя поменять местами пределы и ожидания без дополнительных условий на случайные величины. Чтобы убедиться вэтом, пусть U {\ displaystyle U}

точечно. Таким образом, нельзя поменять местами пределы и ожидания без дополнительных условий на случайные величины. Чтобы убедиться вэтом, пусть U {\ displaystyle U} будет случайной величиной, равномерно распределенной на [0, 1] {\ displaystyle [0,1]}

будет случайной величиной, равномерно распределенной на [0, 1] {\ displaystyle [0,1]}![[0,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d) . Для n ≥ 1, {\ displaystyle n \ geq 1,}

. Для n ≥ 1, {\ displaystyle n \ geq 1,} определить последовательность случайных величин

определить последовательность случайных величин

- X n = n ⋅ 1 {U ∈ [0, 1 n]}, {\ displaystyle X_ {n} = n \ cdot \ mathbf {1} \ left \ {U \ in \ left [0, {\ tfrac {1} {n}} \ right] \ right \},}

![{\ displaystyle X_ {n} = n \ cdot \ mathbf {1} \ left\ {U \ in \ left [0, {\ tfrac {1} {n}} \ right] \ right \},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/899224f356c72db5209c007f275d566baf77db5b)

с 1 {A} {\ displaystyle {\ mathbf {1}} \ {A \}} является индикаторнойфункцией событий A {\ displaystyle A}

является индикаторнойфункцией событий A {\ displaystyle A} . Отсюда следует, что X n → 0 {\ displaystyle X_ {n} \ to 0}

. Отсюда следует, что X n → 0 {\ displaystyle X_ {n} \ to 0} (a.s). Но E [X n] = N n P ⋅ (U ∈ [0, 1 n]) = N ⋅ 1 n = 1 {\ Displaystyle \ OperatorName {E} [X_ {n}] = n \ cdot \ operatorname {P} \ left (U \ in \ left [0, {\ tfrac {1} {n}} \ right] \ right) = n \ cdot {\ tfrac {1} {n}} = 1}

(a.s). Но E [X n] = N n P ⋅ (U ∈ [0, 1 n]) = N ⋅ 1 n = 1 {\ Displaystyle \ OperatorName {E} [X_ {n}] = n \ cdot \ operatorname {P} \ left (U \ in \ left [0, {\ tfrac {1} {n}} \ right] \ right) = n \ cdot {\ tfrac {1} {n}} = 1}![{\ displaystyle \ operatorname {E} [X_ {n}] = n \ cdot \ operatorname {P} \ left (U \ in \ left [0, {\ tfrac {1} {n}} \ right] \ right) = n \ cdot {\ tfrac {1} {n}} = 1}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6d8f4a245decdf6546dae0ca3b3cb7c7a81236d8) для каждого n {\ displaystyle n}

для каждого n {\ displaystyle n} . Следовательно, lim n → ∞ E [X n] = 1 ≠ 0 = E [lim n → ∞ X n]. {\displaystyle \ lim _ {n \ to \ infty} \ operat orname {E} [X_ {n}] = 1 \ neq 0 = \ operatorname {E} \ left [\ lim _ {n \ to \ infty} X_ { n} \ right].}

. Следовательно, lim n → ∞ E [X n] = 1 ≠ 0 = E [lim n → ∞ X n]. {\displaystyle \ lim _ {n \ to \ infty} \ operat orname {E} [X_ {n}] = 1 \ neq 0 = \ operatorname {E} \ left [\ lim _ {n \ to \ infty} X_ { n} \ right].}![{\ displaystyle \ lim _ {n \ to \ infty } \ operatorname {E} [X_ {n}] = 1\ neq 0 = \ operatorname {E} \ left [\ lim _ {n \ to \ infty} X_ {n} \ right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/17501d2c79213ad8b6b10ff2aa6b90cb3d4b5b7a)

Аналогично для общей последовательности случайных величин {Y n: n ≥ 0} {\ displaystyle \ {Y_ {n}: n \ geq 0 \}} , оператор ожидаемого значения не является σ {\ displaystyle \ sigma}

, оператор ожидаемого значения не является σ {\ displaystyle \ sigma} -additive, т.е.

-additive, т.е.

- E [∑ n = 0 ∞ Y n] ≠ ∑ n = 0 ∞ E [Да нет]. {\ displaystyle \ operatorname {E} \ left [\ sum _ {n = 0} ^ {\infty} Y_ {n} \ right] \ neq \ sum _ {n = 0} ^{\ infty} \ operatorname {E } [Y_ {n}].}

![{\displaystyle \ operatorname {E} \ left [\ sum _ {n = 0} ^ {\ infty} Y_ {n} \ right] \ neq \ sum _ {n = 0} ^ {\ infty} \ operatorname {E} [Y_ {n}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b866cf6a1cae9adf1d0fee60b0c0fe0633c6b9f1)

Пример легко получить, задав Y 0 = X 1 {\ displaystyle Y_ {0} = X_ {1}} и YN знак равно Икс N + 1 - Икс N {\ Displaystyle Y_ {n} = X_ {n + 1} -X_ {n}}

и YN знак равно Икс N + 1 - Икс N {\ Displaystyle Y_ {n} = X_ {n + 1} -X_ {n}} для n ≥ 1 {\ Displaystyle п \ geq 1}

для n ≥ 1 {\ Displaystyle п \ geq 1} , где X n {\ displaystyle X_ {n}}

, где X n {\ displaystyle X_ {n}} как в предыдущем примере.

как в предыдущем примере.

Ряд результатов сходимости задают точные условия, которые позволяют менять пределы иожидания, как указано ниже.

- Теорема омонотонной сходимости : Пусть {X n: n ≥ 0} {\ displaystyle \ {X_ {n}: n \ geq 0 \}}

будет последовательностью случайных переменные, с 0 ≤ Икс N ≤ Икс n + 1 {\ displaystyle 0 \ leq X_ {n} \ leq X_ {n + 1}}

будет последовательностью случайных переменные, с 0 ≤ Икс N ≤ Икс n + 1 {\ displaystyle 0 \ leq X_ {n} \ leq X_ {n + 1}} (as) для каждого n ≥ 0 {\ displaystyle n \ geq 0}

(as) для каждого n ≥ 0 {\ displaystyle n \ geq 0} . Кроме того, пусть X n → X {\ displaystyle X_ {n} \ to X}

. Кроме того, пусть X n → X {\ displaystyle X_ {n} \ to X} поточечно. Тогда теорема о монотонной сходимости утверждает, что lim nE [X n] = E [X]. {\ displaystyle \ lim _{n} \ operatorname {E} [X_ {n}] = \ operatorname {E} [X].}

поточечно. Тогда теорема о монотонной сходимости утверждает, что lim nE [X n] = E [X]. {\ displaystyle \ lim _{n} \ operatorname {E} [X_ {n}] = \ operatorname {E} [X].}![{\ displaystyle \ lim _ {n} \ operatorname {E} [X_ {n}] = \ имя оператора {E} [X].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2b73765da42e85ed02b14edbdb043d4439a7d811)

- Используя теорему о монотонной сходимости, можно показать, что математическое ожидание действительно удовлетворяет счетной адитивности для неотрицательные случайные величины. В частности, пусть {X i} i = 0 ∞ {\ displaystyle \ {X_ {i} \} _ {i = 0} ^ {\ infty}}

быть неотрицательными случайными величинами. Из теоремы о монотонной сходимости следует, что

быть неотрицательными случайными величинами. Из теоремы о монотонной сходимости следует, что - E [∑i = 0 ∞ X i] = ∑ i = 0 ∞ E [X i]. {\ displ aystyle \ operatorname {E} \ left [\ sum _ {i = 0} ^ {\ infty} X_ {i} \ right] = \ sum _ {i = 0} ^ {\ infty} \ operatorname {E} [X_ {i}].}

![{\ displaystyle \ operatorname {E} \ left [\ sum _ {i = 0} ^ {\ infty} X_ {i} \ right] = \ sum _ {i = 0} ^ {\ infty} \ operatorname {E} [X_ {i}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aaf71dd77b7a0d0e91daeb404051d791320a19f2)

- Лемма Фату : Пусть {X n ≥ 0: n ≥ 0} {\ displaystyle \ {X_ {n} \ geq 0: n \ geq 0 \} }

- последовательность неотрицательных случайных величин. Лемма Фату утверждает, что

- последовательность неотрицательных случайных величин. Лемма Фату утверждает, что

- E [lim inf n X n] ≤ lim inf n E [X n]. {\ displaystyle \ operatorname {E} [\ liminf _ {n} X_ {n}] \ leq \ liminf_ {n} \ operatorname {E} [X_ {n}].}

![{\ displaystyle \operatorname {E} [\ liminf _ {n} X_ {n}] \ leq \ liminf _ {n} \ operatorname {E} [X_{n}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/057772ee68f6360861362f952828d9777135c25f)

- Следствие. Пусть Икс N ≥ 0 {\ Displaystyle X_ {n} \ geq 0}

с E [X n] ≤ C {\ displaystyle \ operatorname {E} [X_ {n}] \ leq C}

с E [X n] ≤ C {\ displaystyle \ operatorname {E} [X_ {n}] \ leq C}![{\ displaystyle \ operatorname {E} [X_ {n}] \ leq C}](https://wikimedia.org/api/rest_v1/media/math/render/svg/339f966e30b892a25b0670b8fc07c651a69f87ea) для всех n ≥ 0 {\ displaystyle n \ geq 0}

для всех n ≥ 0 {\ displaystyle n \ geq 0} . Если X n → X {\ displaystyle X_ {n} \ to X}

. Если X n → X {\ displaystyle X_ {n} \ to X} (as), то E [X] ≤ C. {\ displaystyle \ operatorname {E} [ X] \ leq C.}

(as), то E [X] ≤ C. {\ displaystyle \ operatorname {E} [ X] \ leq C.}![{\ displaystyle \operatorname {E} [X] \ leq C.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/41f7fe3f4be094774d092c875c87774a60101495)

- Доказательство заключается в том, что X = lim inf n X n {\ displaystyle \ textstyle X= \ liminf _ {n} X_ {n}}

(as) иприменяя лемму Фату.

(as) иприменяя лемму Фату.

- Теорема о доминирующей сходимости : Пусть {X n: n ≥ 0} {\ displaystyle \ {X_ {n}: n \ geq 0 \}}

- последовательность случайных величин. Если X n → X {\ displaystyle X_ {n} \ to X}

- последовательность случайных величин. Если X n → X {\ displaystyle X_ {n} \ to X} точечно (а.с.), | X n | ≤ Y ≤ + ∞ {\ Displaystyle | X_ {n} | \ leq Y \ leq + \ infty}

точечно (а.с.), | X n | ≤ Y ≤ + ∞ {\ Displaystyle | X_ {n} | \ leq Y \ leq + \ infty} (a.s.) и E [Y] < ∞ {\displaystyle \operatorname {E} [Y]<\infty }

(a.s.) и E [Y] < ∞ {\displaystyle \operatorname {E} [Y]<\infty }![{\ displaystyle\ operatorname {E} [Y] <\ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1d673ec21dbeafe0aa85b387902be8f1e99c71ab) . Тогда, согласно теореме о доминирующей сходимости,

. Тогда, согласно теореме о доминирующей сходимости, - E | X | ≤ E [Y] < ∞ {\displaystyle \operatorname {E} |X|\leq \operatorname {E} [Y]<\infty }

![{\ displaystyle \ имя оператора {E} | X | \ Leq \ OperatorName {E} [Y] <\ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/76bf5ca01b19d23933c539e345beae216814a896) ;

; - lim n E [X n] = E [X] {\ displaystyle\ lim _ {n} \ operatorname {E} [X_ {n}] = \ operatorname {E} [ X]}

![{\ displaystyle \ lim _ {n} \ operatorname {E} [X_ {n}] = \ operatorname {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f107d786930dfedd1b297798933642ded4fadc31)

- lim n E | X n - X | = 0. {\ displaystyle \ lim _ {n} \ operatorname {E} | X_ {n} -X | = 0.}

- Равномерная интегрируемость : в некоторых случаях равенство lim n E [Икс N] знак равно Е [lim n Икс N] {\ displaystyle \ displaystyle \ lim _ {n} \ OperatorName {E} [X_ {n}] = \ operatorname {E} [\ lim _ {n} X_ {n}]}

![{\ displaystyle \ displaystyle \ lim _ {n} \ operatorname {E} [X_ {n}] = \ operatorname {E} [\ lim _ {n} X_ {n}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/49b910be9482f360448e16c89ac52046dab69f9d) выполняется, когда последовательность {Xn} {\ displaystyle \ {X_ {n} \}}

выполняется, когда последовательность {Xn} {\ displaystyle \ {X_ {n} \}} равномерно интегрируема.

равномерно интегрируема.

Неравенства

Существует ряд неравенств, связанных с ожидаемыми значениями функций случайных величин. Следующий список включает некоторые из самых простых.

- Неравенство Маркова : для неотрицательной случайной величины X {\ displaystyle X}

и a>0 {\ displaystyle a>0}

и a>0 {\ displaystyle a>0} ,неравенство Маркова P утверждает, что

,неравенство Маркова P утверждает, что

- (Икс ≥ a) ≤ E [X] a. {\ Displaystyle \ operatorname {P} (X \ geq a) \ leq {\ frac {\ operatorname {E} [X]} {a}}.}

![{\ displaystyle \ operat orname { P} (X \ geq a) \ leq {\ frac {\ operatorname {E} [X]} {a}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d33c3c6fa0ecb7b99a4245dc1f55668bc50fd8cc)

- Неравенство Биенайме-Чебышева : пусть X {\ displaystyle X}

будет произвольной случайной величиной с конечным ожидаемым размером E [X] {\ displaystyle \ operatorname {E} [X]}

будет произвольной случайной величиной с конечным ожидаемым размером E [X] {\ displaystyle \ operatorname {E} [X]}![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) и конечная дисперсия Var [X] ≠ 0 {\ displaystyl e \ operatorname {Var} [X] \ neq 0}

и конечная дисперсия Var [X] ≠ 0 {\ displaystyl e \ operatorname {Var} [X] \ neq 0}![{\ displaystyle\ operatorname {Var} [X] \ neq 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8daf591feb95c7381b749d79ad0a8efb40205e53) . НеравенствоБьенайме-Чебышева гласит, что для любого действительного числа k>0 {\ displaystyle k>0}

. НеравенствоБьенайме-Чебышева гласит, что для любого действительного числа k>0 {\ displaystyle k>0} ,

,

- P (| X - E [X] | ≥ К Вар [X]) ≤ 1 К 2. {\ Displaystyle \ OperatorName {P} {\ Bigl (} {\ Bigl |} X- \ OperatorName {E} [X] {\ Bigr |} \ geq k { \ sqrt {\ operat orname {Var} [X]}} {\ Bigr)} \ leq {\ frac {1} {k ^ {2}}}.}

![{\ displaystyle \ operatorname {P} {\ Bigl (} {\ Bigl |} X- \ operatorname {E} [X] {\ Bigr |} \ geq k {\ sqrt {\ operatorname {Var} [X]}} {\ Bigr)} \ leq {\ frac {1} {k ^ {2}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1eae646393be5630426222c88d9594be5f140d5a)

- Неравенство Дженсена : пусть f : R → R {\ displaystyle f: {\ mathbb {R}} \ to {\ mathbb {R}}}

быть Borel выпуклой функцией и X {\ displaystyle X}

быть Borel выпуклой функцией и X {\ displaystyle X} случайная величина такая, что E | X | < ∞ {\displaystyle \operatorname {E} |X|<\infty }

случайная величина такая, что E | X | < ∞ {\displaystyle \operatorname {E} |X|<\infty } . Тогда

. Тогда

- f (E (X)) ≤ E (f (X)). {\ displaystyle f (\ operatorname {E} (X)) \ leq \ operatorname {E} (f (X)).}

- (Обратите внимание, что правая часть определенаправильно, даже если X {\ displaystyle X}

не являетсяконечным. На самом деле, как отмечалось выше, конечность E | X | {\ displaystyle \ operatorname {E} | X |}

не являетсяконечным. На самом деле, как отмечалось выше, конечность E | X | {\ displaystyle \ operatorname {E} | X |} означает, что X {\ displaystyle X}

означает, что X {\ displaystyle X} конечно как; таким, f (X) {\ displaystyle f (X)}

конечно как; таким, f (X) {\ displaystyle f (X)} образом определяется как).

образом определяется как).

- Неравенство Ляпунова: Пусть 0 < s < t {\displaystyle 0

. Неравенство Ляпунова утверждает, что

. Неравенство Ляпунова утверждает, что

- (E | X | s) 1 / s ≤ (E | X | t) 1 / t. {\ displaystyle \ left (\ operatorname{E} | X | ^ {s} \ right) ^ {1 / s} \ leq \ left (\ operatorname {E} | X| ^ {t} \ right) ^ {1 / t}.}

- Доказательство. Применение неравенства Дженсена к | X | с {\ displaystyle | X | ^ {s}}

и g (x) = | х | т / с {\ Displaystyle г (х) = | х | ^ {т / с}}

и g (x) = | х | т / с {\ Displaystyle г (х) = | х | ^ {т / с}} , получаем | E | X s | | т / с ≤ E | X s | t / s = E | X | т {\ displaystyle {\ Bigl |} \ operatorname {E} | X ^ {s} | {\ Bigr |} ^ {t / s} \ leq \ operatorname {E} | X ^ {s} | ^ {t / s}= \ operatorname {E} | X | ^ {t}}

, получаем | E | X s | | т / с ≤ E | X s | t / s = E | X | т {\ displaystyle {\ Bigl |} \ operatorname {E} | X ^ {s} | {\ Bigr |} ^ {t / s} \ leq \ operatorname {E} | X ^ {s} | ^ {t / s}= \ operatorname {E} | X | ^ {t}} . Получение корня tth {\displaystyle t ^ {th}}

. Получение корня tth {\displaystyle t ^ {th}} из каждой стороны завершает доказательство.

из каждой стороны завершает доказательство.

- Неравенство Коши - Буняковского - Шварца : неравенство Коши - Буняковского - Шварца утверждает, что

- (E [XY]) 2 ≤ E [X 2] ⋅ E [Y 2]. {\ displaystyle (\ operatorname {E} [XY]) ^ {2} \ leq \ operatorname {E} [X ^ {2}] \ cdot \ operatorname {E} [Y ^ {2}].}

![{\ displaystyle (\ operatorname {E} [XY]) ^ {2} \ leq \ operatorname {E} [X ^ {2}] \ cdot \ operatorname {E} [Y ^ {2}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e270eda0d23ede2b9693a7d0b0d29d014b52bdc0)

- Неравенство Гёльдера : пусть p {\ displaystyle p}

и q {\ displaystyle q}

и q {\ displaystyle q} удовлетворяют 1 ≤ p ≤ ∞ {\ displ aystyle 1 \ leq p \ leq \ infty}

удовлетворяют 1 ≤ p ≤ ∞ {\ displ aystyle 1 \ leq p \ leq \ infty} , 1 ≤ q ≤ ∞ {\ displaystyle 1 \ leq q \ leq \ infty}

, 1 ≤ q ≤ ∞ {\ displaystyle 1 \ leq q \ leq \ infty} и 1 / p + 1 / q = 1 {\ Стиль отображения 1 / p + 1 / q = 1}

и 1 / p + 1 / q = 1 {\ Стиль отображения 1 / p + 1 / q = 1} . Неравенство Гёльдера утверждает, что

. Неравенство Гёльдера утверждает, что

- E | X Y | ≤ (E | X | p) 1 / p (E | Y | q) 1 / q. {\ displaystyle \ operatorname {E} | XY | \ leq (\ operatorname {E} | X | ^ {p}) ^ {1 / p} (\ operatorname {E} | Y | ^ {q}) ^ {1 / q}.}

- неравенство Минковского : пусть p {\ displaystyle p}

будетположительным вещественным лицом, удовлетворяющим 1 ≤ p ≤ ∞ {\ displaystyle 1 \ leq р \ leq \ infty}

будетположительным вещественным лицом, удовлетворяющим 1 ≤ p ≤ ∞ {\ displaystyle 1 \ leq р \ leq \ infty} . Пусть, кроме того, E | X | p < ∞ {\displaystyle \operatorname {E} |X|^{p}<\infty }

. Пусть, кроме того, E | X | p < ∞ {\displaystyle \operatorname {E} |X|^{p}<\infty } и E | Y | р < ∞ {\displaystyle \operatorname {E} |Y|^{p}<\infty }

и E | Y | р < ∞ {\displaystyle \operatorname {E} |Y|^{p}<\infty } . Тогда согласно неравенству Минковского E | X + Y | р < ∞ {\displaystyle \operatorname {E} |X+Y|^{p}<\infty }

. Тогда согласно неравенству Минковского E | X + Y | р < ∞ {\displaystyle \operatorname {E} |X+Y|^{p}<\infty } и

и

- (E | X + Y | p) 1 / p ≤ (E | X | p) 1 / p + (E | Y | p) 1 / p. {\ Displaystyle {\ Bigl (} \ OperatorName {E} | X + Y | ^ {p} {\ Bigr)} ^ {1/ p} \ leq {\ Bigl (} \ operatorname {E} | X | ^ { p} {\ Bigr)} ^ {1 / p} + {\Bigl (} \ operatorname {E} | Y | ^ {p} {\ Bigr)} ^ {1 / p}.}

Ожидаемые общие значения распределения

| Распределение | Обозначение | Среднее E (X) |

|---|

| Бернулли | X ∼ b (1, p) {\ displaystyle X \ sim ~ b (1, p)} | p {\ displaystyle p} |

| Биномиальное | X ∼ B (n, p) {\ displaystyle X \ sim B (n, p)} | np {\ displaystyle np} |

| Пуассон | Икс ∼ п о (λ) {\ displaystyle X \ simPo (\ lambda)} | λ {\ displaystyle \ lambda} |

| геометрический | X ∼ Geometric (p) {\ displaystyle X \ sim Geometric (p)} | 1 / p {\ displaystyle 1 / p} |

| Uniform | X ∼ U (a, b) {\ displaystyle X \ sim U (a, b)} | (a + b) / 2 {\ displaystyle (a + b) / 2} |

| Exponential | X ∼ exp (λ) {\ displaystyle X \ sim \ exp (\ lambda)} | 1 / λ {\ displaystyle 1 / \ lambda} |

| нормальный | X ∼ N (μ, σ 2) {\ displaystyle X \ sim N (\ mu, \ sigma ^ {2})} | μ {\ displayst yle \ mu} |

| Стандартный d Нормальный | Икс ∼ N (0, 1) { \ Displaystyle X\ sim N (0,1)} | 0 {\ displaystyle 0} |

| Парето | X ∼ P ar (α) {\ displaystyle X \ sim Par (\ alpha)} | α / (α + 1) {\ displaystyle \ alpha / (\ alpha +1)} если α>1 {\ displaystyle \ alpha>1} если α>1 {\ displaystyle \ alpha>1} |

| Коши | X ∼ C (x 0, γ) {\displaystyle X \ sim Cauchy (x_ {0}, \ gamma)} | undefined |

Связь схарактеристической функцией

Функция плотности вероятности f X {\ displaystyle f_ {X}} скалярной случайной величины X {\ displaystyle X}

скалярной случайной величины X {\ displaystyle X} связано с его характерной функцией φ X {\ displaystyle \ varphi _ {X}}

связано с его характерной функцией φ X {\ displaystyle \ varphi _ {X}} по формуле обращения:

по формуле обращения:

- f X (x) = 1 2 π ∫ R e - itx φ X (t) dt. {\ displaystyle f_ {X} (x) = {\ frac {1} {2 \ pi}} \ int _ {\ mathbb {R}} e ^ {- itx}\ varphi _ {X} (t) \, dt.}

Для ожидаемого значения g (X) {\ displ aystyle g (X)} (где g: R → R {\ displaystyle g: {\ mathbb {R }} \ to {\ mathbb {R}}}

(где g: R → R {\ displaystyle g: {\ mathbb {R }} \ to {\ mathbb {R}}} - это функция Бореля ), мы можем использовать эту формулу обращения, чтобы получить

- это функция Бореля ), мы можем использовать эту формулу обращения, чтобы получить

- E [g (X)] = 1 2 π R g (x) [∫ R e - itx φ X (t) dt] dx. {\ displaystyle \ operatorname {E} [g (X)] = {\ frac {1} {2 \ pi}} \ int _ {\ mathbb {R}} g (x) \ left [\ int _ {\ mathbb {R}} e ^ {- itx} \ varphi _ {X} (t)\, dt \ right] \, dx.}

![{\ displaystyle \ operatorname {E} [g (X)] = {\ frac {1} {2 \ pi}} \ int _ {\ mathbb {R }} g (x) \ left [\ int _ {\ mathbb {R}} e ^ {- itx} \ varphi _ {X} (t) \, dt \ right] \, dx.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/135fbb1b442ae5cf9d76032b94b1a996367b8cd8)

Если E [g (X)] {\ displaystyle \ operat orname {E} [g (X)]}![{\ displaystyle \ operatorname {E} [g (X)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/eb4b4bbeb1430cfba120570df9f18fb09480a7f3) конечно, изменяя порядок интегрирования, получаем, в соответствии с теоремой Фубини - Тонелли,

конечно, изменяя порядок интегрирования, получаем, в соответствии с теоремой Фубини - Тонелли,

- E [g (X)] = 1 2 π ∫ RG (T) φ Икс (t) dt, {\ Displaystyle \ OperatorName {E} [g (X)] = {\ frac {1} {2 \ pi}} \ int _ {\ mathbb {R}} G ( t) \ varphi _ {X} (t) \, dt,}

![{\ displaystyle \ operatorname {E} [g (X)] = {\ frac {1} {2 \ pi} } \ int _ {\ mathbb {R}} G (t) \ varphi _ {X} (t) \, dt,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f0d10e08cda1c47d94fc86ba0d45fd4ca51e6670)

где

- G (t) = ∫ R g (x) e - itxdx {\ displaystyle G (t) = \ int _ {\ mathbb {R}} g (x) e ^ {- itx} \, dx}

-преобразование Фурье для g (x). {\ displaystyle g (x).} Выражение для E [g (X)] {\ displaystyle \ operatorname {E} [g (X)]}

Выражение для E [g (X)] {\ displaystyle \ operatorname {E} [g (X)]}![{\ displaystyle \ operatorname {E} [g (X)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/eb4b4bbeb1430cfba120570df9f18fb09480a7f3) также непосредственно следует из теоремы Планшереля.

также непосредственно следует из теоремы Планшереля.

См. также

- Центр масс

- Центральная тенденция

- Неравенство Чебышева (неравенство по параметрам местоположения и масштаба)

- Условное ожидание

- Ожидание (общее термин)

- Ожидаемое значение (квантовая механика)

- Закон общего ожидания -ожидаемое значение условного ожидаемого значения X при заданном Y такое же, какожидаемое значение X.

- Момент (математика)

- Нелинейное ожидание (обобщение ожидаемого значения)

- Уравнение Вальда - уравнение для вычислений ожидаемого значения случайного числа случайных величин

Ссылки

Литература

![E [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/e455a34363c03fc5df8208d8b81fa29e3cdd524e)

![{\ displaystyle \ operatorname {E} [X] = \ sum _ {i = 1} ^ {k} x_ {i} \, p_{i} = x_ {1} p_ {1} + x_ {2} p_ {2} + \ cdots + x_ {k} p_ { k}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/519542ccdb827d224e730020a1f0c0ce675297d3)

Иллюстрация сходимости средних значений бросков кубика к ожидаемому значению 3,5 по мере увеличения количества бросков (испытаний).

Иллюстрация сходимости средних значений бросков кубика к ожидаемому значению 3,5 по мере увеличения количества бросков (испытаний).  представит результат броска честного шестигранного кубика . Более конкретно,

представит результат броска честного шестигранного кубика . Более конкретно,  будет содержать области, отображаемых на верхней поверхности кубика после подбрасывания. Возможные значения для

будет содержать области, отображаемых на верхней поверхности кубика после подбрасывания. Возможные значения для  : 1, 2, 3, 4, 5 и 6, все из равновероятны с вероятностью 1/6. Математическое ожидание

: 1, 2, 3, 4, 5 и 6, все из равновероятны с вероятностью 1/6. Математическое ожидание  is

is![{\ displaystyle \ operatorname {E} [X] = 1 \ cdot {\ frac {1} {6}} + 2 \ cdot {\ frac {1} {6}} + 3 \ cdot {\ frac {1} {6}} + 4 \ cdot {\ frac {1} {6}} + 5 \ cdot {\ frac {1} {6}} + 6 \ cdot {\ frac {1} {6}} = 3.5.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d535e1c37fd63db36fd0878e39b43ea7fa513ea4)

раз и вычислить среднее (среднее арифметическое ) результатов, то как

раз и вычислить среднее (среднее арифметическое ) результатов, то как  растет, среднее почти наверняка сходится к ожидаемому значению, факт, известный как строгий закон большие числа.

растет, среднее почти наверняка сходится к ожидаемому значению, факт, известный как строгий закон большие числа. представляет (денежный) результат ставки в 1 доллар на одно число ("прямая" ставка). Если ставка выигрывает (что происходит с вероятностью 1/38 в американской рулетке), выплата составляет 35 долларов; в противном случае игрок теряет ставку. Ожидаемая прибыль от таких ставок составит

представляет (денежный) результат ставки в 1 доллар на одно число ("прямая" ставка). Если ставка выигрывает (что происходит с вероятностью 1/38 в американской рулетке), выплата составляет 35 долларов; в противном случае игрок теряет ставку. Ожидаемая прибыль от таких ставок составит![{\ displaystyle \ operatorname {E} [\, {\ text {прирост от}} \ $ 1 {\ text {bet}} \,] = - \ $ 1 \ cdot {\ frac {37}{38}} + \ $ 35 \ cdot {\ frac {1} {38}} = - \ $ {\ frac {1} {19}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/efa6df424d69a14b24a7b598b5e0f1e6e426bff1)

, поэтому его ожидаемое значение составляет

, поэтому его ожидаемое значение составляет

![{\ displaystyle \ operatorname {E} [X] = \ sum _ {i = 1} ^ {\ infty} x_ {i} \, p_ {i}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2509d047fc89077d41febe60520c076d55386608)

![{\ displ aystyle \ имя оператора {E} [X] = \ имя оператора {E} [X ^ {+}] - \ имя оператора {E} [X ^ {-}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d54be7ea6dcbc06bf807cc33a18128131487a841)

![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{\ displaystyle \ operatorname {E} [X ^ {+}] =\ operatorname {E} [X ^ {-}] = \ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/39208448351df3073fb3667060ff9e29ed6156cc)

и

и  для

для  , где

, где  (с

(с  (натуральный логарифм ) - это масштабный коэффициент, при котором сумма вероятностей равна 1. Тогда, используя прямое определение для неотрицательных случайных величин, мы имеем

(натуральный логарифм ) - это масштабный коэффициент, при котором сумма вероятностей равна 1. Тогда, используя прямое определение для неотрицательных случайных величин, мы имеем![{\ displaystyle \ operatorname {E} [X] = \ sum _ {i} x_ {i} p_ {i} = 1 \ left ({\ frac {k} {2}} \ right) +2 \ left ({\ frac {k} {8}} \ right) +3 \ left ({\ frac {k}{24}} \ right) + \ dots = {\ frac {k} {2}} + {\ frac {k} {4}} + {\ frac {k} {8}} + \ dots = k.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/080fb218bb6f48d69e19c8694dae679684ca1c15)

и

и  для

для  . Еще раз, как случайная величина неотрицательна, расчет ожидаемого значения дает

. Еще раз, как случайная величина неотрицательна, расчет ожидаемого значения дает![{\ displaystyle \ operatorname { E} [X] = \ sum _ {i = 1} ^ {\ infty} x_ {i} \, p_ {i} = 2 \ cdot {\ frac {1} {2}} + 4 \ cdot {\ frac {1} {4}} + 8 \ cdot {\ frac {1} {8}} + 16 \ cdot {\ frac{1} {16}} + \ cdots = 1 + 1 + 1 + 1 + \ cdots \, = \ infty.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7a04de85e01c5cc27e3e1635493583dd39c3fd38)

принимает значения

принимает значения  с вероятностями

с вероятностями  ,..., где

,..., где  - нормализующая константа,которая гарантирует, что сумма вероятностей равна единице.

- нормализующая константа,которая гарантирует, что сумма вероятностей равна единице. принимает значение

принимает значение  с вероятностью

с вероятностью  для

для  и принимает значение

и принимает значение  с оставшейся вероятностью. Точно так же

с оставшейся вероятностью. Точно так же  принимает значение

принимает значение  с вероятностью

с вероятностью  для

для  и принимает значение

и принимает значение  с оставшейся вероятностью. Используя определение неотрицательных случайных величин, можно показать, что и

с оставшейся вероятностью. Используя определение неотрицательных случайных величин, можно показать, что и ![{\ displaystyle \ operatorname {E} [X ^ {+}] = \ infty }](https://wikimedia.org/api/rest_v1/media/math/render/svg/349709705912ec5400d727e0047361874e8af27e) и

и ![{\ displaystyle \ operatorname {E} [X ^ {-}] = \ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4ac976e9034564f71b3627c8063ee2a0d3fbaff3) (см. Гармонический ряд ). Следовательно, ожидание

(см. Гармонический ряд ). Следовательно, ожидание  не является четко определенным.

не является четко определенным.

![{\ displaystyle \ operatorname {E} [X] = \ int _ {\ mathbb {R}} xf (x) \, dx,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b6b4021050b825064c6e43aefc7694fb6307bc30)

![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{\ displaystyle \ operatorname {E} [X] = \ int _{\ Omega} X (\ omega) \, d \ operatorname {P} (\ omega).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f2c4265bd78bfc615c6da1f1fae310d462793187)

![{\ displaystyle \operatorname {E} [(X_ {1}, \ ldots, X_ {n})] = (\ oper atorname {E} [X_ {1}], \ l dots, \ operatorname {E} [X_ {n}])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/82529dea1fae623cf096f6e7955332fa73bf791a)

определите, как и раньше,

определите, как и раньше,  и

и  , обратите внимание, что

, обратите внимание, что  , причем как

, причем как  , так и

, так и  неотрицательно, тогда:

неотрицательно, тогда:![{\ displaystyle \ operatorname {E} [X] = {\ begin { case} \ operat orname {E} [X ^ {+}] - \ operatorname {E} [X ^ {-}] {\ text {if}} \ operatorname {E} [X ^ {+}] <\ infty {\ text {and}} \ operatorname {E} [X ^ {- }] <\ infty; \\\ infty {\ text {if}} \ operatorname {E} [X ^ {+}] = \ infty {\ text {and}} \ operatorname {E} [X ^ {-}] <\ infty; \\ - \ infty {\ text {if}} \ operatorname {E} [X ^ {+}] <\ infty {\ text {and}} \ operatorname {E} [X ^ {-}]= \ infty; \\ {\ text {undefined}} {\ text {if}} \ operatorname {E} [X ^ { +}] = \ infty {\ text {and}} \operatorname {E} [X ^ {-}] = \ i nfty. \ end {case}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c80257845a8fa7e82404f267002d9714dec21cd0)

обозначает индикаторную функцию для события

обозначает индикаторную функцию для события  , тогда

, тогда ![{\ Displaystyle \ OperatorName {E} [{\ mathbf {1}} _ {A}] = 1 \ cdot \ OperatorName {P} (A) +0 \ cdot \ operatorn ame {P} (\ Omega \ setm inus A) = \ operatorname {P} (A).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/49c23205ce0226e3a5e807040eea3ef1663e8542)

является кумулятивным функцией распределения вероятностной меры

является кумулятивным функцией распределения вероятностной меры  и

и  - случайная величина, тогда

- случайная величина, тогда![{\ displaystyle \ operatorname {E} [X] = \ int _ {\ overline {\ mathbb{R}}} x \, dF (x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8e2749d3c6bcc1ae1ec924cd1e0406f34a3c11e9)

![{\ displaystyle {\ overline {\ mathbb {R}}} = [- \ infty, + \ infty]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92df65c7a6de4a17db586e79121da6e9de7aaf17) - расширенное вещественное числостроки.

- расширенное вещественное числостроки.![{\ displaystyle \ displaystyle \ operatorname {E} [X] = \ int \ limits _ {0} ^ {\ infty} (1-F (x)) \, dx- \ int \ limits _ {- \ infty} ^ {0} F (x) \, dx,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e17ad7f7a7f00bc58379675c943ad21ee18120e8)

(as), то

(as), то ![{\ displaystyle \ Operatorname {E} [X] \ geq 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc359a5fbc4d9b691dceba58a5fd3cc7120cda15) .

.![\ operatorname {E} [\ cdot]](https://wikimedia.org/api/rest_v1/media/math/render/svg/0a71518eb57ffaf54c0c31bf94de5ac9d7ab11a1) является линейным в том смысле, что для любых случайных величин

является линейным в том смысле, что для любых случайных величин  и

и  и константа

и константа  ,

,![{\ displaystyle {\ begin {align} \ operatorname {E} [X + Y] = \ operatorname {E} [X] + \ operatorname {E} [Y], \\\ operatorname {E} [aX] = a \ operatorname {E} [X], \ end {align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3d3a0fa4f32e29c4cc4fd567a63afc384a7e3b91)

(as), и оба

(as), и оба ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) и

и ![{\ displaystyle \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/639e8577c6faffc0471c7e123ead30970034e6d5) существуют, тогда

существуют, тогда ![{\ displaystyle \ operatorname {E} [X] \ leq \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bcc409f2b956425dc9dacce39207930f60057d55) .

. , поскольку

, поскольку  (as).

(as).![{\ displaystyle \ operatorname {E} [XY]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/612af0bbf256874e0b0551305574be507f9ff805) не обязательно равно

не обязательно равно ![{\ displaystyle \ operatorname {E} [X] \ cdot \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c52e5f76c5aad37aeeaf32d355681263e92aad24) . Если

. Если  и

и  являются независимыми, то можнопоказать,что

являются независимыми, то можнопоказать,что ![{\ displaystyle \ operatorname {E} [XY] = \ имя оператора {E} [X] \ имя оператора {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5cfc97e307911d3230962dd68be6a5c3dcaed71a) . Если случайные величины зависимы от, то обычно

. Если случайные величины зависимы от, то обычно ![{\ displaystyle \ operatorname {E} [XY] \ neq \ operatorname {E} [X] \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/088991fa5ad13b9421b1b14ed2b582fde070e4c1) , хотя в особых случаях зависимости равенство может выполняться.

, хотя в особых случаях зависимости равенство может выполняться. ,

,  , учитывая, что

, учитывая, что  имеет функцию плотности вероятности

имеет функцию плотности вероятности  , дается внутренним произведением из

, дается внутренним произведением из  и

и  :

:![{\ displaystyle\ operatorname {E} [g (X)] = \ int _ {\ mathbb {R}} g (x) f (x) \, dx.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a417b7efdd5329bcd40b2efd4b8ed5bd3b031e52)

- это функция нескольких случайных величин, а

- это функция нескольких случайных величин, а  - их плотность соединения.

- их плотность соединения.![{\ displaystyle \ operatorname {E} [| X |] = 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ab8a77f734e7d3405900d794b5a323e2a6c58974) , затем

, затем  (as).

(as). с четко определенным математическим ожиданием:

с четко определенным математическим ожиданием: ![{\ displ aystyle | \ operatorname {E} [X] | \ leq \ operatorname {E} | X |}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d950496113ee61bc1f496eecbadcf6bcc85e8d62) .

. являются эквивалент:

являются эквивалент: ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) существует и конечен.

существует и конечен.![{\ displaystyle \ operatorname {E} [X ^ {+}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/21874fb6790ea26596fc561d88b159841c285fd3) и

и ![{\ displaystyle \ operatorname {E} [X ^ {-}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b27d36ddc1f0ffeb56f0f0e0dbc1aaa8ece17214) конечны.

конечны.![{\ displaystyle \ имя оператора {E} [| X |]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a3590a8ce161c1bf1b1bc8ef9fe99407406f2400) конечно.

конечно. является интегрируемым "и" ожидаемое значение

является интегрируемым "и" ожидаемое значение  конечно "взаимозаменяемо используются в этой статье.

конечно "взаимозаменяемо используются в этой статье.![{\ displaystyle \ operatorname {E} [X] <+ \ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e04b1762cff984a0f687d746b5dc182a56244dfe) , затем

, затем  (as). Аналогичным образом, если

(as). Аналогичным образом, если ![{\displaystyle \operatorname {E} [X]>- \ infty}]( https://wikimedia.org/api/rest_v1/media/math/render/svg/92deed236efc7deaf9c34e1a3c7c346cce28279b ) , затем

, затем  (as).

(as). и

и  , затем

, затем

(as), то

(as), то ![{\ displaystyle \ operatorname {E} [X] = \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/206f1357b15162a6f9b14f8057fe8b75a6dc82e1) . Другими словами, если X и Y - случайные величины, которые принимают разные значения с вероятностью ноль, то ожидание X будет равно ожиданию Y.

. Другими словами, если X и Y - случайные величины, которые принимают разные значения с вероятностью ноль, то ожидание X будет равно ожиданию Y. (as) для некоторой константы

(as) для некоторой константы ![{\displaystyle c \ in [- \ infty, + \ infty]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/efc16e7f0da8125427c46522d4e0fa5449dc7131) , тогда

, тогда ![{\ displaystyle \ operatorname {E} [X] = c}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8c081385ba053a066911729481c89ad435cc8c6a) . В частности, для случайной величины

. В частности, для случайной величины  с четкоопределенным ожиданием

с четкоопределенным ожиданием ![{\ displaystyle \ operatorname {E} [\ operatorname {E} [X]] = \ operatorname {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7ff311903fa69e69841abfef5c018d9c43145dac) . Хорошо определенное ожидание подразумевает, что существует одно число или, скорее, одна константа, определяющая ожидаемое значение. Из этого следует, что математическое ожидание этой константы - это просто исходное ожидаемое значение.

. Хорошо определенное ожидание подразумевает, что существует одно число или, скорее, одна константа, определяющая ожидаемое значение. Из этого следует, что математическое ожидание этой константы - это просто исходное ожидаемое значение.

![{\displaystyle \operatorname {E} [X]=\sum _{n=0}^{\infty }\operatorname {P} (X>n).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4386ec8a6164af8d3041d07ae990592d84657dd2)

![{\displaystyle \ operatorname {P} ({X \ in {\ mathcal {A}}}) = \ operatorname {E} [{\ math bf {1}} _ {\ mathcal {A}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bc2d627e0e24ccb93ccedb966935f49319f4fd25)

Масса распределения вероятностей сбалансированной на ожидаемом значении, здесь распределение с ожидаемым значением α / (α + β).

Масса распределения вероятностей сбалансированной на ожидаемом значении, здесь распределение с ожидаемым значением α / (α + β). ![\ operatorname {Var} (X) = \ operatorname {E} [X ^ {2}] - (\ operatorname {E} [X]) ^ {2}.](https://wikimedia.org/api/rest_v1/media/math/render/svg/3704ee667091917e2e34f5b6e28e8d49df4b9650)

![{\ displaystyle \ operatorname {E} [X_ {n}] \ to \ operatorname {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2ac6f8237847b46129e5a1206c32caaf6535e2e9)

![[0,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)

![{\ displaystyle X_ {n} = n \ cdot \ mathbf {1} \ left\ {U \ in \ left [0, {\ tfrac {1} {n}} \ right] \ right \},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/899224f356c72db5209c007f275d566baf77db5b)

![{\ displaystyle \ operatorname {E} [X_ {n}] = n \ cdot \ operatorname {P} \ left (U \ in \ left [0, {\ tfrac {1} {n}} \ right] \ right) = n \ cdot {\ tfrac {1} {n}} = 1}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6d8f4a245decdf6546dae0ca3b3cb7c7a81236d8)

![{\displaystyle \ operatorname {E} \ left [\ sum _ {n = 0} ^ {\ infty} Y_ {n} \ right] \ neq \ sum _ {n = 0} ^ {\ infty} \ operatorname {E} [Y_ {n}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b866cf6a1cae9adf1d0fee60b0c0fe0633c6b9f1)

будет последовательностью случайных переменные, с

будет последовательностью случайных переменные, с  (as) для каждого

(as) для каждого  . Кроме того, пусть

. Кроме того, пусть  поточечно. Тогда теорема о монотонной сходимости утверждает, что

поточечно. Тогда теорема о монотонной сходимости утверждает, что ![{\ displaystyle \ lim _ {n} \ operatorname {E} [X_ {n}] = \ имя оператора {E} [X].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2b73765da42e85ed02b14edbdb043d4439a7d811)

быть неотрицательными случайными величинами. Из теоремы о монотонной сходимости следует, что

быть неотрицательными случайными величинами. Из теоремы о монотонной сходимости следует, что ![{\ displaystyle \ operatorname {E} \ left [\ sum _ {i = 0} ^ {\ infty} X_ {i} \ right] = \ sum _ {i = 0} ^ {\ infty} \ operatorname {E} [X_ {i}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aaf71dd77b7a0d0e91daeb404051d791320a19f2)

- последовательность неотрицательных случайных величин. Лемма Фату утверждает, что

- последовательность неотрицательных случайных величин. Лемма Фату утверждает, что![{\ displaystyle \operatorname {E} [\ liminf _ {n} X_ {n}] \ leq \ liminf _ {n} \ operatorname {E} [X_{n}].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/057772ee68f6360861362f952828d9777135c25f)

с

с ![{\ displaystyle \ operatorname {E} [X_ {n}] \ leq C}](https://wikimedia.org/api/rest_v1/media/math/render/svg/339f966e30b892a25b0670b8fc07c651a69f87ea) для всех

для всех  . Если

. Если  (as), то