В теории вероятностей, условное ожидание, условное ожидаемое значение, или условное среднее случайной величины - это ее ожидаемое значение - значение, которое оно будет принимать «в среднем» за произвольно большое количество вхождений - при условии, что известен определенный набор «условий». Если случайная величина может принимать только конечное число значений, «условия» таковы, что переменная может принимать только подмножество этих значений. Более формально, в случае, когда случайная величина определена в дискретном вероятностном пространстве, «условия» представляют собой раздел этого вероятностного пространства.

Для нескольких случайных величин, если одна случайная переменная означает независимую от всех остальных - как по отдельности, так и вместе - означает, что каждое условное ожидание равно (безусловному) ожидаемому значению случайной величины. Это всегда верно, если переменные независимы, но средняя независимость - более слабое условие.

В зависимости от характера обусловливания условное ожидание может быть либо самой случайной величиной, либо фиксированным значением. С двумя случайными величинами, если математическое ожидание случайной величины  выражается условным для другой случайной величины

выражается условным для другой случайной величины  ( без указания конкретного значения

( без указания конкретного значения  ), тогда ожидание

), тогда ожидание  условно на

условно на  , обозначаемый

, обозначаемый  , является функцией случайной величины

, является функцией случайной величины  и, следовательно, сам является случайной величиной. В качестве альтернативы, если ожидание

и, следовательно, сам является случайной величиной. В качестве альтернативы, если ожидание  выражается условным при возникновении конкретного значения

выражается условным при возникновении конкретного значения  , обозначенного

, обозначенного  , тогда условное ожидание

, тогда условное ожидание  равно фиксированное значение.

равно фиксированное значение.

Содержание

- 1 Примеры

- 1.1 Пример 1: Прокатка в штампе

- 1.2 Пример 2: Данные об осадках

- 2 История

- 3 Классическое определение

- 3.1 Условное ожидание относительно события

- 3.2 Условное ожидание относительно случайной величины

- 4 Формальное определение

- 4.1 Условное ожидание относительно суб-σ-алгебры

- 4.2 Условное ожидание относительно случайной величины

- 4.3 Обсуждение

- 5 Условие как факторизация

- 6 Вычисление

- 7 Основные свойства

- 8 См. Также

- 9 Примечания

- 10 Ссылки

- 11 Внешние ссылки

Примеры

Пример 1: Бросок кубика

Рассмотрим бросок честного кубика и пусть A = 1, если число четное (например, 2, 4 или 6) и A = 0 в противном случае. Кроме того, пусть B = 1, если число простое (например, 2, 3 или 5), и B = 0 в противном случае.

Безусловное ожидание A равно ![{\displaystyle E[A]=(0+1+0+1+0+1)/6=1/2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d2c73844540e147c26fa0cfcbd5f92569f6faf17) , но ожидание A при условии B = 1 (т. Е. При условии, что результат броска кубика равен 2, 3 или 5) составляет

, но ожидание A при условии B = 1 (т. Е. При условии, что результат броска кубика равен 2, 3 или 5) составляет ![{\displaystyle E[A\mid B=1]=(1+0+0)/3=1/3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/21ef0566c23330afef05e69c89009445fe57a460) , а ожидание A при условии B = 0 (т. Е. При условии, что результат броска кубика равен 1, 4 или 6) равен

, а ожидание A при условии B = 0 (т. Е. При условии, что результат броска кубика равен 1, 4 или 6) равен ![{\displaystyle E[A\mid B=0]=(0+1+1)/3=2/3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f73f8df8def617b9f47ab90e4e59a7c7a58245a5) . Точно так же математическое ожидание B при A = 1 равно

. Точно так же математическое ожидание B при A = 1 равно ![{\displaystyle E[B\mid A=1]=(1+0+0)/3=1/3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/569f78f7977e9a08d9b9fb327fc2f68f85cbdc01) , а ожидание B при условии A = 0 равно

, а ожидание B при условии A = 0 равно ![{\displaystyle E[B\mid A=0]=(0+1+1)/3=2/3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9795f0937cca5706a601bc0989b543763c788787) .

.

Пример 2: данные об осадках

Предположим, мы иметь ежедневные данные об осадках (мм осадков каждый день), собранные метеостанцией каждый день десятилетнего (3652 дня) периода с 1 января 1990 г. по 31 декабря 1999 г. Безусловное ожидание количества осадков в течение неопределенного дня - среднее количество осадков за эти 3652 дня. Условное ожидание количества осадков для неустановленного иначе дня, который, как известно, должен быть (условным) в марте, представляет собой среднее количество осадков за все 310 дней десятилетнего периода, который выпадает в марте. А условное ожидание количества осадков в дни, датированные 2 марта, - это среднее количество осадков, выпавших за десять дней с этой конкретной датой.

История

Родственная концепция условной вероятности восходит, по крайней мере, к Лапласу, который рассчитывал условные распределения. Это Андрей Колмогоров в 1933 году формализовал его с помощью теоремы Радона – Никодима. В работах Пола Халмоса и Джозефа Л. Дуба с 1953 года условное ожидание было обобщено до его современного определения с использованием суб-σ-алгебр.

Классического определения

Условное ожидание относительно события

В классической теории вероятностей условное ожидание  задано событие

задано событие  (которое может быть событием

(которое может быть событием  для случайной переменной

для случайной переменной  ) - это среднее значение

) - это среднее значение  по всем результатам в

по всем результатам в  , то есть

, то есть

где  - мощность из

- мощность из  .

.

Сумма выше может быть сгруппирована по различным значениям  , чтобы получить сумму в диапазоне

, чтобы получить сумму в диапазоне  из

из

В современной теории вероятностей, когда  является событием со строго положительной вероятностью, это Можно дать аналогичную формулу. Это особенно верно для дискретной случайной величины

является событием со строго положительной вероятностью, это Можно дать аналогичную формулу. Это особенно верно для дискретной случайной величины  и для

и для  в диапазон

в диапазон  , если событие

, если событие  равно

равно  . Пусть

. Пусть  будет вероятностным пространством,

будет вероятностным пространством,  - случайная величина в этом вероятностном пространстве, а

- случайная величина в этом вероятностном пространстве, а  событие со строго положительной вероятностью

событие со строго положительной вероятностью  . Затем условное ожидание

. Затем условное ожидание  с учетом события

с учетом события  равно

равно

где  - это диапазон

- это диапазон  и

и  - это мера вероятности определена для каждого набора

- это мера вероятности определена для каждого набора  , как

, как  , условная вероятность

, условная вероятность  при

при  .

.

Когда  (что обычно бывает, если

(что обычно бывает, если  - это непрерывная случайная величина, а

- это непрерывная случайная величина, а  - событие

- событие  ), парадокс Бореля – Колмогорова демонстрирует неоднозначность попытки определить условную вероятность, зная о событии

), парадокс Бореля – Колмогорова демонстрирует неоднозначность попытки определить условную вероятность, зная о событии  . Приведенная выше формула показывает, что эта проблема переходит в условное ожидание. Таким образом, вместо этого определяется только условное ожидание относительно σ-алгебры или случайной величины.

. Приведенная выше формула показывает, что эта проблема переходит в условное ожидание. Таким образом, вместо этого определяется только условное ожидание относительно σ-алгебры или случайной величины.

Условное ожидание относительно случайной величины

Если Y - дискретная случайная величина в том же вероятностном пространстве  с диапазоном

с диапазоном  , тогда условное ожидание X относительно Y это функция

, тогда условное ожидание X относительно Y это функция  переменной

переменной  , определенном как

, определенном как

Существует близкая функция из  до

до  определяется как

определяется как

Эта функция, которая является отличается от предыдущего, является условным математическим ожиданием X относительно σ-алгебры, порожденной Y. Они связаны соотношением

где  означает композиция функций.

означает композиция функций.

Как упоминалось выше, если Y является непрерывной случайной величиной, невозможно определить  этим методом. Как объясняется в парадоксе Бореля – Колмогорова, мы должны указать, какая ограничивающая процедура дает множество Y = y. Если пространство событий

этим методом. Как объясняется в парадоксе Бореля – Колмогорова, мы должны указать, какая ограничивающая процедура дает множество Y = y. Если пространство событий  имеет функцию расстояния, то одна процедура для этого следующая: определить набор

имеет функцию расстояния, то одна процедура для этого следующая: определить набор  , предположим, что каждый

, предположим, что каждый  является P-измеримым и что

является P-измеримым и что  для всех

для всех  , затем условное ожидание относительно

, затем условное ожидание относительно  четко определен. Возьмем предел как

четко определен. Возьмем предел как  стремится к 0 и определим

стремится к 0 и определим

Замена этого ограничивающего процесса на Производная Радона – Никодима дает аналогичное определение, которое работает в более общем смысле.

Формальное определение

Условное ожидание относительно под-σ-алгебры

Условное ожидание относительно σ-алгебры: в этом примере вероятностное пространство

- интервал [0,1] с

мерой Лебега. Мы определяем следующие σ-алгебры:

;

- σ-алгебра, порожденная интервалами с концами 0, ¼, ½, ¾, 1; и

- σ-алгебра, генерируемая интервалами с конечными точками 0, ½, 1. Здесь условное ожидание фактически является средним по минимальные множества σ-алгебры.

Рассмотрим следующее:

является вероятностным пространством.

является вероятностным пространством. является случайной величиной на этом вероятностном пространстве с конечным математическим ожиданием.

является случайной величиной на этом вероятностном пространстве с конечным математическим ожиданием. является под- σ -алгебра из

является под- σ -алгебра из  .

.

Поскольку  является вложенным

является вложенным  -алгебра

-алгебра  , функция

, функция  обычно не

обычно не  -измеримо, поэтому существование интегралов вида

-измеримо, поэтому существование интегралов вида  , где

, где  и

и  является ограничением

является ограничением  до

до  , не может быть заявлено в общем. Однако локальные средние значения

, не может быть заявлено в общем. Однако локальные средние значения  можно восстановить в

можно восстановить в  с помощью условного ожидания. A условное ожидание X с учетом

с помощью условного ожидания. A условное ожидание X с учетом  , обозначается как

, обозначается как  , является любой

, является любой  -измеримой функцией

-измеримой функцией  , который удовлетворяет:

, который удовлетворяет:

для каждого  .

.

Существование  можно установить, отметив, что

можно установить, отметив, что  для

для  является конечной мерой на

является конечной мерой на  , которая абсолютно непрерывна с соответствующими от t до

, которая абсолютно непрерывна с соответствующими от t до  . Если

. Если  - это естественная инъекция из

- это естественная инъекция из  в

в  , тогда

, тогда  - это ограничение

- это ограничение  до

до  и

и  - ограничение

- ограничение  на

на  . Кроме того,

. Кроме того,  абсолютно непрерывно относительно

абсолютно непрерывно относительно  , потому что условие

, потому что условие

означает

Таким образом,

где производные - это производные Радона – Никодима мер.

Условное ожидание по отношению к случайной величине

В дополнение к вышесказанному рассмотрим

- A измеримое пространство

и

и - случайная величина

.

.

Пусть  быть

быть  -измеримой функцией такой что для каждой

-измеримой функцией такой что для каждой  -измеримой функции

-измеримой функции  ,

,

Тогда измеримая функция  , обозначается как

, обозначается как  , является условное ожидание из X задано

, является условное ожидание из X задано  .

.

Это определение эквивалентно определению условного ожидания относительно под-  -поле

-поле  (см. выше), определенное прообразом Σ по Y. Если мы определим

(см. выше), определенное прообразом Σ по Y. Если мы определим

, затем

.

.

Обсуждение

- Это не конструкция живое определение; нам просто дано необходимое свойство, которому должно удовлетворять условное ожидание.

- Определение

может напоминать определение

может напоминать определение  для события

для события  но это очень разные объекты. Первая - это

но это очень разные объекты. Первая - это  -измеримая функция

-измеримая функция  , а последний является элементом

, а последний является элементом  и

и  для

для  .

. - Существование функции условного ожидания может быть доказано с помощью теоремы Радона – Никодима. Достаточным условием является наличие (безусловного) ожидаемого значения для X.

- Можно показать, что уникальность почти наверняка : то есть версии одного и того же условного ожидания будут отличаться только на набор нулевой вероятности.

- σ-алгебра

управляет "степенью детализации" кондиционирования. Условное ожидание

управляет "степенью детализации" кондиционирования. Условное ожидание  над более тонкой (большей) σ-алгеброй

над более тонкой (большей) σ-алгеброй  сохраняет информацию о вероятностях более крупного класса событий. Условное ожидание по более грубой (меньшей) σ-алгебре усредняет по большему количеству событий.

сохраняет информацию о вероятностях более крупного класса событий. Условное ожидание по более грубой (меньшей) σ-алгебре усредняет по большему количеству событий.

Условие как факторизация

В приведенном выше определении условного ожидания учитывается тот факт, что  - реальный случайный элемент не имеет значения. Пусть

- реальный случайный элемент не имеет значения. Пусть  - измеримое пространство, где

- измеримое пространство, где  - σ -алгебра по

- σ -алгебра по  . A

. A  -значный случайный элемент представляет собой измеримую функцию

-значный случайный элемент представляет собой измеримую функцию  , т.е.

, т.е.  для всех

для всех  . Распределение

. Распределение  является мерой вероятности

является мерой вероятности  определяется как метод продвижения вперед

определяется как метод продвижения вперед  , то есть такой, что

, то есть такой, что  .

.

Теорема . Если  является интегрируемой случайной величиной, то существует уникальный интегрируемый случайный элемент

является интегрируемой случайной величиной, то существует уникальный интегрируемый случайный элемент  , определяется

, определяется  почти наверняка, так что

почти наверняка, так что

для всех  .

.

Контрольный эскиз . Пусть  таково, что

таково, что  . Тогда

. Тогда  является мерой со знаком, которая абсолютно непрерывна по отношению к

является мерой со знаком, которая абсолютно непрерывна по отношению к  . Действительно,

. Действительно,  означает именно то, что

означает именно то, что  , и поскольку интеграл интегрируемой функции на множестве вероятности 0 равен 0, это доказывает абсолютную непрерывность. Теорема Радона – Никодима затем доказывает существование плотности

, и поскольку интеграл интегрируемой функции на множестве вероятности 0 равен 0, это доказывает абсолютную непрерывность. Теорема Радона – Никодима затем доказывает существование плотности  относительно

относительно  . Эта плотность равна

. Эта плотность равна  .

.

по сравнению с условным ожиданием относительно суб- σ-алгебры, выполняется

Мы можем дополнительно интерпретировать это равенство, рассмотрев абстрактную формулу замены переменных для преобразования интеграла в правой части в интеграл по Ω:

Уравнение означает, что интегралы от  и композиции

и композиции  над множествами формы

над множествами формы  для

для  идентичны.

идентичны.

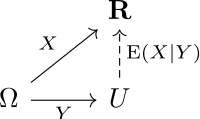

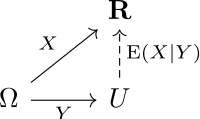

Это уравнение можно интерпретировать как указание на то, что следующая диаграмма в среднем коммутативна.

Вычисление

Когда X и Y оба являются дискретными случайными величинами, то условное ожидание X с учетом события Y = y можно рассматривать как функцию y для y в диапазоне элемента Y:

где  - это диапазон X.

- это диапазон X.

Если X - непрерывная случайная величина, в то время как Y остается дискретной переменной, условное ожидание равно

с  (где f X, Y (x, y) дает t he плотность соединения X и Y), являющаяся условной плотностью X при Y = y.

(где f X, Y (x, y) дает t he плотность соединения X и Y), являющаяся условной плотностью X при Y = y.

Если и X, и Y являются непрерывными случайными величинами, то условное ожидание будет

где  (где f Y (y) дает плотность Y).

(где f Y (y) дает плотность Y).

Основные свойства

Все следующие формулы следует понимать почти наверняка. Σ-алгебра  может быть заменена случайной величиной

может быть заменена случайной величиной  .

.

- Выделение независимых факторов:

- Если

является независимым от

является независимым от  , затем

, затем  .

.

Доказательство

Пусть  . Тогда

. Тогда  не зависит от

не зависит от  , поэтому мы получаем, что

, поэтому мы получаем, что

Таким образом, определению условного ожидания удовлетворяет постоянная случайная величина  , как требуется.

, как требуется.

- Если

не зависит от

не зависит от  , тогда

, тогда  . Обратите внимание, что это не обязательно так, если

. Обратите внимание, что это не обязательно так, если  не зависит только от

не зависит только от  и из

и из  .

. - Если

независимы,

независимы,  независимы,

независимы,  не зависят от

не зависят от  и

и  не зависит от

не зависит от  , тогда

, тогда  .

.

- Стабильность:

- Если

равно

равно  - измеримо, то

- измеримо, то  .

. - Если Z - случайная величина, то

. В простейшей форме это говорит:

. В простейшей форме это говорит:  .

.

- Извлечение известных факторов:

- Если

равно

равно  -measurable, то

-measurable, то  .

. - Если Z является случайным переменной, тогда

.

.

- Закон общего ожидания :

.

. - Свойство башни:

- Для суб-σ-алгебр

у нас есть

у нас есть  .

. - Особый случай - когда Z является

-измеримая случайная величина. Тогда

-измеримая случайная величина. Тогда  и, следовательно,

и, следовательно,  .

. - Doob martingale свойство: указанное выше с

(что равно

(что равно  -измеримый), а также используя

-измеримый), а также используя  , дает

, дает  .

.

- Для случайных величин

мы имеем

мы имеем  .

. - Для случайных величин

мы имеем

мы имеем  .

.

- Линейность: мы имеем

и

и  для

для  .

. - Положительность: если

, то

, то  .

. - Монотонность: если

, затем

, затем  .

. - Монотонная сходимость : Если

тогда

тогда  .

. - Преобладающая конвергенция : Если

и

и  с

с  , затем

, затем  .

. - Лемма Фату : Если

then

then  .

. - Jensen's inequality : If

is a convex function, then

is a convex function, then  .

. - Conditional var iance : Using the conditional expectation we can define, by analogy with the definition of the variance as the mean square deviation from the average, the conditional variance

- Definition:

- Algebraic formula for the variance:

- Law of total variance :

.

.

- Martingale convergence : For a random variable

, that has finite expectation, we have

, that has finite expectation, we have  , if either

, if either  is an increasing series of sub-σ-algebras and

is an increasing series of sub-σ-algebras and  or if

or if  is a decreasing series of sub-σ-algebras and

is a decreasing series of sub-σ-algebras and  .

. - Conditional expectation as

-projection: If

-projection: If  are in the Hilbert space of square-integrable real random variables (real rand om variables with finite second moment) then

are in the Hilbert space of square-integrable real random variables (real rand om variables with finite second moment) then - for

-measurable

-measurable  , we have

, we have  , i.e. the conditional expectation

, i.e. the conditional expectation  is in the sense of the L(P) scalar product the orthogonal projection from

is in the sense of the L(P) scalar product the orthogonal projection from  to the linear subspace of

to the linear subspace of  -measurable functions. (This allows to define and prove the existence of the conditional expectation based on the Hilbert projection theorem.)

-measurable functions. (This allows to define and prove the existence of the conditional expectation based on the Hilbert projection theorem.) - the mapping

is self-adjoint :

is self-adjoint :

- Conditioning is a contractive projection of L spaces

. I.e.,

. I.e.,  for any p ≥ 1.

for any p ≥ 1. - Doob's conditional independence property: If

are conditionally independent given

are conditionally independent given  , then

, then  (equivalently,

(equivalently,  ).

).

See also

Probability laws

Notes

References

External links

![{\displaystyle E[A]=(0+1+0+1+0+1)/6=1/2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d2c73844540e147c26fa0cfcbd5f92569f6faf17)

![{\displaystyle E[A\mid B=1]=(1+0+0)/3=1/3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/21ef0566c23330afef05e69c89009445fe57a460)

![{\displaystyle E[A\mid B=0]=(0+1+1)/3=2/3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f73f8df8def617b9f47ab90e4e59a7c7a58245a5)

![{\displaystyle E[B\mid A=1]=(1+0+0)/3=1/3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/569f78f7977e9a08d9b9fb327fc2f68f85cbdc01)

![{\displaystyle E[B\mid A=0]=(0+1+1)/3=2/3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9795f0937cca5706a601bc0989b543763c788787)

. Затем условное ожидание

Условное ожидание относительно σ-алгебры: в этом примере вероятностное пространство

Условное ожидание относительно σ-алгебры: в этом примере вероятностное пространство  - интервал [0,1] с мерой Лебега. Мы определяем следующие σ-алгебры:

- интервал [0,1] с мерой Лебега. Мы определяем следующие σ-алгебры:  ;

;  - σ-алгебра, порожденная интервалами с концами 0, ¼, ½, ¾, 1; и

- σ-алгебра, порожденная интервалами с концами 0, ¼, ½, ¾, 1; и  - σ-алгебра, генерируемая интервалами с конечными точками 0, ½, 1. Здесь условное ожидание фактически является средним по минимальные множества σ-алгебры.

- σ-алгебра, генерируемая интервалами с конечными точками 0, ½, 1. Здесь условное ожидание фактически является средним по минимальные множества σ-алгебры.  является вероятностным пространством.

является вероятностным пространством. является случайной величиной на этом вероятностном пространстве с конечным математическим ожиданием.

является случайной величиной на этом вероятностном пространстве с конечным математическим ожиданием. является под- σ -алгебра из

является под- σ -алгебра из  .

.

и

и .

.

.

. может напоминать определение

может напоминать определение  для события

для события  но это очень разные объекты. Первая - это

но это очень разные объекты. Первая - это  -измеримая функция

-измеримая функция  , а последний является элементом

, а последний является элементом  и

и  для

для  .

. управляет "степенью детализации" кондиционирования. Условное ожидание

управляет "степенью детализации" кондиционирования. Условное ожидание  над более тонкой (большей) σ-алгеброй

над более тонкой (большей) σ-алгеброй  сохраняет информацию о вероятностях более крупного класса событий. Условное ожидание по более грубой (меньшей) σ-алгебре усредняет по большему количеству событий.

сохраняет информацию о вероятностях более крупного класса событий. Условное ожидание по более грубой (меньшей) σ-алгебре усредняет по большему количеству событий.

является независимым от

является независимым от  , затем

, затем  .

.

не зависит от

не зависит от  , тогда

, тогда  . Обратите внимание, что это не обязательно так, если

. Обратите внимание, что это не обязательно так, если  не зависит только от

не зависит только от  и из

и из  .

. независимы,

независимы,  независимы,

независимы,  не зависят от

не зависят от  и

и  не зависит от

не зависит от  , тогда

, тогда  .

. равно

равно  - измеримо, то

- измеримо, то  .

. . В простейшей форме это говорит:

. В простейшей форме это говорит:  .

. равно

равно  -measurable, то

-measurable, то  .

. .

. .

. у нас есть

у нас есть  .

.  -измеримая случайная величина. Тогда

-измеримая случайная величина. Тогда  и, следовательно,

и, следовательно,  .

. (что равно

(что равно  -измеримый), а также используя

-измеримый), а также используя  , дает

, дает  .

. мы имеем

мы имеем  .

. мы имеем

мы имеем  .

. и

и  для

для  .

. , то

, то  .

. , затем

, затем  .

. тогда

тогда  .

. и

и  с

с  , затем

, затем  .

. then

then  .

. is a convex function, then

is a convex function, then  .

.

.

. , that has finite expectation, we have

, that has finite expectation, we have  , if either

, if either  is an increasing series of sub-σ-algebras and

is an increasing series of sub-σ-algebras and  or if

or if  is a decreasing series of sub-σ-algebras and

is a decreasing series of sub-σ-algebras and  .

. -projection: If

-projection: If  are in the Hilbert space of square-integrable real random variables (real rand om variables with finite second moment) then

are in the Hilbert space of square-integrable real random variables (real rand om variables with finite second moment) then  -measurable

-measurable  , we have

, we have  , i.e. the conditional expectation

, i.e. the conditional expectation  is in the sense of the L(P) scalar product the orthogonal projection from

is in the sense of the L(P) scalar product the orthogonal projection from  to the linear subspace of

to the linear subspace of  -measurable functions. (This allows to define and prove the existence of the conditional expectation based on the Hilbert projection theorem.)

-measurable functions. (This allows to define and prove the existence of the conditional expectation based on the Hilbert projection theorem.) is self-adjoint :

is self-adjoint :

. I.e.,

. I.e.,  for any p ≥ 1.

for any p ≥ 1. are conditionally independent given

are conditionally independent given  , then

, then  (equivalently,

(equivalently,  ).

).