An Intel 80486DX2 ЦП, как видно сверху

An Intel 80486DX2 ЦП, как видно сверху  Нижняя сторона Intel 80486DX2, показывая его контакты

Нижняя сторона Intel 80486DX2, показывая его контакты A центрального процессора (ЦП ), также называемого центральный процессор, основной процессор или просто процессор - это электронная схема в компьютере, которая выполняет инструкции, составляющие компьютерную программу. ЦП выполняет базовые арифметические, логические, управляющие и операции ввода / вывода (I / O), указанные в инструкциях программы. В компьютерной индустрии термин «центральный процессор» использовался еще в 1955 году. Традиционно термин «ЦП» относится к процессору, а точнее к его процессору и блоку управления ( CU), что позволяет отличать эти основные элементы компьютера от внешних компонентов, таких как основная память и I/O схемы.

Форма, дизайн, и реализация процессоров изменилась на протяжении их истории, но их основная работа осталась почти неизменной. Основные компоненты ЦП включают в себя арифметико-логический блок (ALU), который выполняет арифметические и логические операции, регистры процессора, которые предоставляют операнды для ALU и хранит результаты операций ALU, а также блок управления, который организует выборку (из памяти) и выполнение инструкций, управляя согласованными операциями ALU, регистров и других компонентов.

Большинство современных ЦП - это микропроцессоры, где ЦП находится на единой металл-оксид-полупроводник (MOS) интегральная схема (IC) чип. ИС, содержащая ЦП, может также содержать память, периферийные интерфейсы и другие компоненты компьютера; такие интегрированные устройства по-разному называются микроконтроллерами или системами на микросхеме (SoC). В некоторых компьютерах используется многоядерный процессор, который представляет собой одну микросхему или «разъем », содержащий два или более ЦП, называемых «ядрами».

Процессоры массива или векторные процессоры имеют несколько процессоров, которые работают параллельно, при этом ни один из модулей не считается центральным. Виртуальные ЦП представляют собой абстракцию динамических агрегированных вычислительных ресурсов.

EDVAC, один из первых компьютеров с сохраненными программами

EDVAC, один из первых компьютеров с сохраненными программами Ранние компьютеры, такие как ENIAC, приходилось физически перестраивать для выполнения различных задач, что привело к машины, которые будут называться "компьютерами с фиксированной программой" ". Поскольку термин «ЦП» обычно определяется как устройство для выполнения программного обеспечения (компьютерной программы), самые ранние устройства, которые по праву можно было бы назвать ЦП, появились с появлением компьютера с хранимой программой.

Идея ЭВМ с хранимой программой уже присутствовала в конструкции Дж. Преспер Эккерт и Джон Уильям Мочли ENIAC, но изначально был опущен, чтобы его можно было закончить раньше. 30 июня 1945 г., до того, как был создан ENIAC, математик Джон фон Нейман распространил статью под названием Первый проект отчета по EDVAC. Это была схема компьютера с хранимой программой, который в конечном итоге должен был быть завершен в августе 1949 года. EDVAC был разработан для выполнения определенного количества инструкций (или операций) различных типов. Примечательно, что программы, написанные для EDVAC, должны были храниться в высокоскоростной компьютерной памяти, а не определяться физической разводкой компьютера. Это позволило преодолеть серьезное ограничение ENIAC, которое требовало значительных затрат времени и усилий для перенастройки компьютера для выполнения новой задачи. Благодаря проекту фон Неймана программу, которую запускал EDVAC, можно было изменить, просто изменив содержимое памяти. EDVAC, однако, не был первым компьютером с хранимой программой; Manchester Baby, небольшой экспериментальный компьютер с хранимой программой, запустил свою первую программу 21 июня 1948 года, а Manchester Mark 1 запустил свою первую программу в ночь с 16 на 17. Июнь 1949 года.

Ранние процессоры были нестандартными конструкциями, которые использовались как часть более крупного и иногда отличительного компьютера. Однако этот метод разработки пользовательских процессоров для конкретного приложения в значительной степени уступил место разработке многоцелевых процессоров, производимых в больших количествах. Эта стандартизация началась в эпоху дискретных транзисторов мэйнфреймов и миникомпьютеров и быстро ускорилась с популяризацией интегральной схемы (IC).. ИС позволяет проектировать и производить все более сложные процессоры с допусками порядка нанометров. Как миниатюризация, так и стандартизация ЦП увеличили присутствие цифровых устройств в современной жизни далеко за пределы ограниченного применения специализированных вычислительных машин. Современные микропроцессоры появляются в электронных устройствах, начиная от автомобилей и заканчивая мобильными телефонами, а иногда даже в игрушках.

Хотя фон Нейману чаще всего приписывают дизайн компьютера с хранимой программой из-за его дизайна EDVAC и дизайна. стала известна как архитектура фон Неймана, другие до него, такие как Конрад Цузе, предлагали и реализовывали аналогичные идеи. Так называемая гарвардская архитектура Harvard Mark I, которая была завершена до EDVAC, также использовала дизайн сохраненной программы с использованием перфоленты, а не электронной объем памяти. Ключевое различие между архитектурами фон Неймана и Гарварда состоит в том, что последняя разделяет хранение и обработку инструкций и данных ЦП, в то время как первая использует одно и то же пространство памяти для обоих. Большинство современных ЦП в основном построены по фон Нейману, но ЦП с архитектурой Гарварда также встречаются, особенно во встроенных приложениях; например, микроконтроллеры Atmel AVR представляют собой процессоры с архитектурой Гарварда.

Реле и электронные лампы (термоэлектронные лампы) обычно использовались в качестве переключающих элементов; Для полезного компьютера требуются тысячи или десятки тысяч коммутационных устройств. Общая скорость системы зависит от скорости переключателей. Ламповые компьютеры, такие как EDVAC, имели тенденцию к сбоям в среднем восемь часов, тогда как релейные компьютеры, такие как (медленнее, но раньше) Harvard Mark I выходили из строя очень редко. В конце концов, ламповые ЦП стали доминирующими, потому что значительные преимущества в скорости обычно перевешивали проблемы с надежностью. Большинство этих ранних синхронных процессоров работали на низких тактовых тактовых частотах по сравнению с современными микроэлектронными конструкциями. Частоты тактового сигнала в диапазоне от 100 кГц до 4 МГц были очень распространены в то время, что в значительной степени ограничивалось скоростью коммутирующих устройств, на которых они были построены.

IBM PowerPC Процессор 604e

IBM PowerPC Процессор 604e Сложность конструкции процессоров возрастала, поскольку различные технологии способствовали созданию более компактных и надежных электронных устройств. Первое такое улучшение произошло с появлением транзистора . Транзисторные процессоры в 1950-х и 1960-х годах больше не нужно было строить из громоздких, ненадежных и хрупких переключающих элементов, таких как электронные лампы и реле. Благодаря этому усовершенствованию более сложные и надежные процессоры были построены на одной или нескольких печатных платах, содержащих дискретные (отдельные) компоненты.

В 1964 году IBM представила свою компьютерную архитектуру IBM System / 360, которая использовалась в серии компьютеров, способных запускать одни и те же программы с разной скоростью и производительностью. Это было важно в то время, когда большинство электронных компьютеров были несовместимы друг с другом, даже если они были произведены одним и тем же производителем. Чтобы облегчить это улучшение, IBM использовала концепцию микропрограммы (часто называемой «микрокодом»), которая до сих пор широко используется в современных процессорах. Архитектура System / 360 была настолько популярна, что десятилетиями доминировала на рынке мэйнфреймов и оставила наследие, которое до сих пор продолжают аналогичные современные компьютеры, такие как IBM zSeries. В 1965 году Digital Equipment Corporation (DEC) представила другой влиятельный компьютер, ориентированный на научные и исследовательские рынки, PDP-8.

плату Fujitsu с процессорами SPARC64 VIIIfx

плату Fujitsu с процессорами SPARC64 VIIIfx Транзисторные компьютеры. имели несколько явных преимуществ перед своими предшественниками. Помимо повышения надежности и снижения энергопотребления, транзисторы также позволяли процессорам работать на гораздо более высоких скоростях из-за короткого времени переключения транзистора по сравнению с лампой или реле. Повышенная надежность и резко увеличенная скорость переключающих элементов (которые к тому времени были почти исключительно транзисторами), тактовые частоты процессора в десятки мегагерц были легко получены в этот период. Кроме того, в то время как дискретные транзисторы и ЦП на микросхемах интенсивно использовались, начали появляться новые высокопроизводительные конструкции, такие как SIMD (Single Instruction Multiple Data) векторные процессоры. Эти ранние экспериментальные разработки позже привели к эре специализированных суперкомпьютеров, подобных тем, которые производятся Cray Inc и Fujitsu Ltd.

CPU, основная память и внешняя шина интерфейс DEC PDP-8 / I, изготовленный из интегральных схем среднего размера

CPU, основная память и внешняя шина интерфейс DEC PDP-8 / I, изготовленный из интегральных схем среднего размера В этот период был использован метод было разработано производство множества взаимосвязанных транзисторов в компактном пространстве. Интегральная схема (IC) позволяла изготавливать большое количество транзисторов на единственной основе полупроводников кристалл, или «микросхеме». Сначала в микросхемы были миниатюризированы только очень простые неспециализированные цифровые схемы, такие как вентили ИЛИ-НЕ. ЦП, основанные на этих «строительных блоках» ИС, обычно называют устройствами «малой интеграции» (SSI). ИС SSI, такие как те, которые используются в компьютере управления Apollo, обычно содержат до нескольких десятков транзисторов. Чтобы построить весь ЦП из микросхем SSI, потребовались тысячи отдельных микросхем, но при этом потреблялось гораздо меньше места и энергии, чем в более ранних конструкциях дискретных транзисторов.

IBM System / 370, продолжение System / 360 использовала микросхемы SSI вместо дискретно-транзисторных модулей Solid Logic Technology. PDP-8 / I и KI10 PDP-10 компании DEC также переключились с отдельных транзисторов, используемых в PDP-8 и PDP-10, на микросхемы SSI и их чрезвычайно популярные Линия PDP-11 изначально была построена с использованием микросхем SSI, но в конечном итоге была реализована с использованием компонентов LSI, как только они стали практичными.

MOSFET (полевой транзистор металл-оксид-полупроводник), также известный как MOS-транзистор, был изобретен Мохамед Аталла и Давон Канг в Bell Labs в 1959 году и продемонстрировали в 1960 году. Это привело к разработке MOS (металл-оксид- полупроводник), предложенная Аталлой в 1960 году и Кангом в 1961 году, а затем изготовленная Фредом Хейманом и Стивеном Хофштейном на RCA в 1962 году. С ее высокой масштабируемостью и гораздо более низкой мощностью потребляемая мощность и более высокая плотность, чем у транзисторов с биполярным переходом, MOSFET позволил создавать интегральные схемы с высокой плотностью.

Ли Бойсел опубликовал важные статьи, в том числе статью за 1967 год " манифест », в котором описывается, как построить эквивалент 32-разрядного мэйнфрейма из относительно небольшого количества крупномасштабных интеграционных схем (LSI). Единственным способом создания микросхем LSI, которые представляют собой микросхемы с сотней или более вентилей, было создание их с использованием процесса производства полупроводников MOS (либо логики PMOS, логики NMOS или логика CMOS ). Однако некоторые компании продолжали создавать процессоры на основе микросхем биполярной транзисторно-транзисторной логики (TTL), поскольку транзисторы с биполярным переходом были быстрее, чем микросхемы MOS вплоть до 1970-х годов (несколько компаний, например Datapoint продолжал создавать процессоры из микросхем TTL до начала 1980-х годов). В 1960-х годах МОП-микросхемы были медленнее и изначально считались полезными только в приложениях, требующих малой мощности. После разработки кремниевого затвора МОП-технологии Федерико Фаггин в Fairchild Semiconductor в 1968 году, МОП-микросхемы в значительной степени заменили биполярный TTL в качестве стандартной технологии микросхем в начале 1970-х.

По мере развития технологии микроэлектроники все большее количество транзисторов размещалось на ИС, что уменьшало количество отдельных ИС, необходимых для полного ЦП. ИС MSI и LSI увеличили количество транзисторов до сотен, а затем и до тысяч. К 1968 году количество микросхем, необходимых для создания полного ЦП, было сокращено до 24 микросхем восьми различных типов, каждая из которых содержит примерно 1000 полевых МОП-транзисторов. В отличие от своих предшественников SSI и MSI, первая реализация LSI PDP-11 содержала ЦП, состоящий всего из четырех интегральных схем LSI.

Die Intel 80486DX2 микропроцессор (фактический размер: 12 × 6,75 мм) в упаковке

Die Intel 80486DX2 микропроцессор (фактический размер: 12 × 6,75 мм) в упаковке  процессор Intel Core i5 на материнской плате ноутбука серии Vaio E (справа, под тепловая трубка )

процессор Intel Core i5 на материнской плате ноутбука серии Vaio E (справа, под тепловая трубка ) Внутри ноутбука с извлеченным из разъема процессором

Внутри ноутбука с извлеченным из разъема процессором Достижения в технологии MOS ИС привели к изобретению микропроцессора в начале 1970-х годов. первый коммерчески доступный микропроцессор, Intel 4004 в 1971 году, и первый широко используемый микропроцессор, Intel 8080 в 1974 году, этот класс процессоров почти полностью вытеснил все остальные центральные процессоры. Методы реализации. Производители мэйнфреймов и мини-компьютеров того времени запустили собственные программы разработки интегральных схем, чтобы обновить свои старые компьютерные архитектуры, и в конечном итоге произвела набор команд совместимых микропроцессоров, которые были обратно совместимы с их старым аппаратным и программным обеспечением. В сочетании с появлением и возможным успехом повсеместного персонального компьютера термин CPU теперь применяется почти исключительно к микропроцессорам. Несколько процессоров (обозначенных ядер) могут быть объединены в одну микросхему обработки.

Предыдущие поколения ЦП были реализованы в виде дискретных компонентов и множества небольших интегральных схем (ИС) на одной или нескольких платах. С другой стороны, микропроцессоры - это процессоры, изготовленные на очень небольшом количестве ИС; обычно всего один. Общий меньший размер ЦП в результате реализации на одном кристалле означает более быстрое время переключения из-за физических факторов, таких как уменьшение паразитной емкости затвора . Это позволило синхронным микропроцессорам иметь тактовую частоту от десятков мегагерц до нескольких гигагерц. Кроме того, возможность конструировать чрезвычайно маленькие транзисторы на ИС многократно увеличила сложность и количество транзисторов в одном ЦП. Эта широко наблюдаемая тенденция описывается законом Мура, который оказался достаточно точным предиктором роста сложности ЦП (и других ИС) до 2016 года.

Хотя сложность, размер, конструкция и общая форма ЦП сильно изменились с 1950 года, основная конструкция и функции практически не изменились. Почти все распространенные сегодня процессоры можно очень точно описать как машины с хранимыми программами фон Неймана. Поскольку закон Мура больше не действует, возникли опасения по поводу ограничений технологии транзисторов интегральных схем. Чрезвычайная миниатюризация электронных ворот приводит к тому, что эффекты таких явлений, как электромиграция и подпороговая утечка, становятся гораздо более значительными. Эти новые проблемы являются одними из многих факторов, заставляющих исследователей исследовать новые методы вычислений, такие как квантовый компьютер, а также расширять использование параллелизма и других методов, расширяющих полезность классической модели фон Неймана.

Основная операция большинства ЦП, независимо от физической формы, которую они принимают, заключается в выполнении последовательности сохраненных инструкций, которая называется программой. Инструкции, которые должны быть выполнены, хранятся в некотором виде компьютерной памяти. Почти все процессоры следуют этапам выборки, декодирования и выполнения в своей операции, которые в совокупности известны как цикл команд .

После выполнения команды весь процесс повторяется, и следующий цикл команды обычно выбирает следующий цикл. -последовательная инструкция из-за увеличенного значения в программном счетчике . Если была выполнена инструкция перехода, счетчик программы будет изменен, чтобы содержать адрес инструкции, к которой был выполнен переход, и выполнение программы продолжается в обычном режиме. В более сложных CPU несколько инструкций могут быть извлечены, декодированы и выполнены одновременно. В этом разделе описывается то, что обычно называется «классический конвейер RISC », который довольно часто встречается среди простых процессоров, используемых во многих электронных устройствах (часто называемых микроконтроллерами). Он в значительной степени игнорирует важную роль кеш-памяти ЦП и, следовательно, этап доступа к конвейеру.

Некоторые инструкции манипулируют программным счетчиком, а не создают данные результата напрямую; такие инструкции обычно называются «переходами» и облегчают поведение программы, такое как циклы, условное выполнение программы (посредством использования условного перехода) и наличие функций . В некоторых процессорах некоторые другие инструкции изменяют состояние битов в регистре «флагов». Эти флаги могут использоваться, чтобы влиять на поведение программы, поскольку они часто указывают на результат различных операций. Например, в таких процессорах команда «сравнить» оценивает два значения и устанавливает или очищает биты в регистре флагов, чтобы указать, какое из них больше или равны ли они; один из этих флагов может затем использоваться более поздней инструкцией перехода для определения хода выполнения программы.

Первый шаг, выборка, включает извлечение инструкции (которая представлена числом или последовательностью чисел) из памяти программы. Расположение (адрес) инструкции в программной памяти определяется программным счетчиком (ПК), в котором хранится число, идентифицирующее адрес следующей инструкции, которая должна быть выбрана. После того, как команда выбрана, длина ПК увеличивается на длину команды, так что он будет содержать адрес следующей инструкции в последовательности. Часто команда, которая должна быть выбрана, должна быть получена из относительно медленной памяти, что приводит к остановке процессора в ожидании возврата команды. В современных процессорах эта проблема в основном решается с помощью кешей и конвейерных архитектур (см. Ниже).

Инструкция, которую ЦП извлекает из памяти, определяет, что ЦП будет делать. На этапе декодирования, выполняемом схемой, известной как декодер инструкций, инструкция преобразуется в сигналы, управляющие другими частями ЦП.

Способ интерпретации инструкции определяется архитектурой набора команд ЦП (ISA). Часто одна группа битов (то есть «поле») в инструкции, называемая кодом операции, указывает, какая операция должна быть выполнена, в то время как остальные поля обычно предоставляют дополнительную информацию, необходимую для операции, такую как операнды. Эти операнды могут быть указаны как постоянное значение (называемое непосредственным значением) или как расположение значения, которое может быть регистром процессора или адресом памяти, как определено некоторым режимом адресации.

В некоторых конструкциях ЦП декодер инструкций реализован в виде фиксированной неизменяемой схемы. В других случаях микропрограмма используется для преобразования инструкций в наборы сигналов конфигурации ЦП, которые применяются последовательно в течение нескольких тактовых импульсов. В некоторых случаях память, в которой хранится микропрограмма, может быть перезаписана, что позволяет изменить способ, которым ЦП декодирует инструкции.

После этапов выборки и декодирования выполняется этап выполнения. В зависимости от архитектуры ЦП это может состоять из одного действия или последовательности действий. Во время каждого действия различные части ЦП электрически соединяются, чтобы они могли выполнять все или часть желаемой операции, а затем действие завершается, обычно в ответ на тактовый импульс. Очень часто результаты записываются во внутренний регистр ЦП для быстрого доступа с помощью последующих инструкций. В других случаях результаты могут быть записаны в более медленную, но менее дорогую и более емкую основную память.

. Например, если должна быть выполнена инструкция сложения, арифметико-логический блок (ALU) вводит подключены к паре источников операндов (числа для суммирования), ALU сконфигурирован для выполнения операции сложения, так что сумма его входов операндов будет отображаться на его выходе, а выход ALU подключен к хранилищу (например, регистр или память), который получит сумму. Когда происходит тактовый импульс, сумма будет передана в хранилище, и, если результирующая сумма будет слишком большой (т.е. она больше, чем размер выходного слова ALU), будет установлен флаг арифметического переполнения.

Блок-схема базового однопроцессорного компьютера с центральным процессором. Черные линии обозначают поток данных, а красные линии обозначают поток управления; стрелки указывают направления потока.

Блок-схема базового однопроцессорного компьютера с центральным процессором. Черные линии обозначают поток данных, а красные линии обозначают поток управления; стрелки указывают направления потока. В схему ЦП встроен набор основных операций, которые он может выполнять, называемый набором команд. Такие операции могут включать, например, сложение или вычитание двух чисел, сравнение двух чисел или переход к другой части программы. Каждая базовая операция представлена определенной комбинацией битов, известной как машинный язык код операции ; при выполнении инструкций в программе на машинном языке ЦП решает, какую операцию выполнять, «декодируя» код операции. Полная инструкция на машинном языке состоит из кода операции и, во многих случаях, дополнительных битов, которые определяют аргументы для операции (например, числа, которые должны быть суммированы в случае операции сложения). По шкале сложности программа на машинном языке представляет собой набор инструкций на машинном языке, которые выполняет ЦП.

Фактическая математическая операция для каждой инструкции выполняется схемой комбинационной логики в процессоре ЦП, известной как арифметико-логический блок или ALU. Как правило, ЦП выполняет инструкцию, извлекая ее из памяти, используя свой ALU для выполнения операции, а затем сохраняя результат в памяти. Помимо инструкций для целочисленной математики и логических операций, существуют различные другие машинные инструкции, например, для загрузки данных из памяти и их сохранения, операций ветвления и математических операций над числами с плавающей запятой, выполняемых плавающей запятой ЦП. блок (FPU).

Блок управления (CU) - это компонент ЦП, который управляет работой процессора. Он сообщает памяти компьютера, арифметическому и логическому устройству, а также устройствам ввода и вывода, как реагировать на инструкции, отправленные процессору.

Он управляет работой других блоков, обеспечивая синхронизирующие и управляющие сигналы. Большинство компьютерных ресурсов управляется CU. Он направляет поток данных между ЦП и другими устройствами. Джон фон Нейман включил блок управления как часть архитектуры фон Неймана. В современных компьютерных разработках блок управления обычно является внутренней частью ЦП, а его общая роль и работа не изменились с момента его появления.

Символьное представление ALU и его входных и выходных сигналов

Символьное представление ALU и его входных и выходных сигналов Арифметико-логический блок (АЛУ) - это цифровая схема в процессоре, которая выполняет целочисленные арифметические операции и побитовые логические операции. Входами в ALU являются слова данных, над которыми нужно работать (называемые операндами ), информация о состоянии из предыдущих операций и код от блока управления, указывающий, какую операцию выполнить. В зависимости от выполняемой инструкции операнды могут поступать из внутренних регистров ЦП или внешней памяти, или они могут быть константами, генерируемыми самим ALU.

Когда все входные сигналы установлены и распространяются через схему ALU, результат выполненной операции появляется на выходах ALU. Результат состоит как из слова данных, которое может храниться в регистре или памяти, так и из информации о состоянии, которая обычно сохраняется в специальном внутреннем регистре ЦП, зарезервированном для этой цели.

Блок генерации адреса (AGU ), иногда также называемый блоком вычисления адреса (ACU ), - это исполнительный блок внутри ЦП, который вычисляет адреса, используемые ЦП для доступа к основной памяти. За счет того, что вычисления адресов обрабатываются отдельной схемой, которая работает параллельно с остальной частью ЦП, количество циклов ЦП, необходимых для выполнения различных машинных инструкций, может быть уменьшено, что приводит к повышению производительности.

При выполнении различных операций процессорам необходимо вычислять адреса памяти, необходимые для выборки данных из памяти; например, позиции в памяти элементов массива должны быть вычислены до того, как ЦП сможет извлечь данные из фактических мест памяти. Эти вычисления генерации адреса включают в себя различные целочисленные арифметические операции, такие как сложение, вычитание, операции по модулю или битовые сдвиги. Часто для вычисления адреса памяти задействовано несколько машинных команд общего назначения, которые не обязательно быстро декодируют и выполняют. Путем включения AGU в конструкцию ЦП вместе с введением специализированных инструкций, использующих AGU, различные вычисления генерации адресов могут быть выгружены из остальной части ЦП и часто могут выполняться быстро за один цикл ЦП.

Возможности AGU зависят от конкретного процессора и его архитектуры. Таким образом, некоторые AGU реализуют и предоставляют больше операций вычисления адреса, в то время как некоторые также включают более сложные специализированные инструкции, которые могут работать с несколькими операндами одновременно. Кроме того, некоторые архитектуры ЦП включают в себя несколько AGU, поэтому одновременно может выполняться более одной операции вычисления адреса, что обеспечивает дальнейшее повышение производительности за счет использования суперскалярной природы усовершенствованных конструкций ЦП. Например, Intel включает несколько AGU в свои микроархитектуры Sandy Bridge и Haswell , которые увеличивают пропускную способность подсистемы памяти ЦП, позволяя несколько инструкции доступа к памяти, которые должны выполняться параллельно.

Большинство высокопроизводительных микропроцессоров (в настольных, портативных, серверных компьютерах) имеют блок управления памятью, преобразующий логические адреса в физические адреса ОЗУ, обеспечивая возможности защиты памяти и разбиения на страницы, полезные для виртуальной памяти. Более простые процессоры, особенно микроконтроллеры , обычно не включают MMU.

A Кэш ЦП - это аппаратный кэш, используемый центральным процессором (ЦП) компьютера для снижения средней стоимости (время или энергии) для доступа к данным из основной памяти. Кэш - это меньшая, более быстрая память, ближе к ядру процессора, которое хранит копии данных из часто используемых основных ячеек памяти. Большинство процессоров имеют разные независимые кеши, в том числе инструкции и кеши данных, где кэш данных обычно организован в виде иерархии большего количества уровней кеширования (L1, L2, L3, L4 и т. Д.).

Все современные (быстрые) процессоры (за некоторыми специализированными исключениями) имеют несколько уровней кэшей процессора. Первые процессоры, использовавшие кэш, имели только один уровень кеша; в отличие от более поздних кешей уровня 1, он не был разделен на L1d (для данных) и L1i (для инструкций). Почти все современные процессоры с кешем имеют разделенный кэш L1. У них также есть кэш L2, а для более крупных процессоров - кеш L3. Кэш L2 обычно не разделяется и действует как общий репозиторий для уже разделенного кеша L1. Каждое ядро многоядерного процессора имеет выделенный кэш L2 и обычно не используется совместно между ядрами. Кэш L3 и кеши более высокого уровня являются общими для ядер и не разделяются. Кэш L4 в настоящее время встречается редко и обычно находится в динамической памяти с произвольным доступом (DRAM), а не в статической памяти с произвольным доступом (SRAM), на отдельном кристалле или кристалле.. Исторически так было и с L1, в то время как более крупные чипы позволяли интегрировать его и, как правило, все уровни кэша, за возможным исключением последнего уровня. Каждый дополнительный уровень кеша имеет тенденцию быть больше и оптимизироваться по-разному.

Существуют и другие типы кэшей (которые не учитываются в «размере кэша» наиболее важных кешей, упомянутых выше), например, буфер резервного преобразования (TLB), который является частью блок управления памятью (MMU), который есть у большинства ЦП.

Размер кэшей обычно определяется степенями двойки: 4, 8, 16 и т. Д. KiB или MiB (для больших, отличных от L1) размеров, хотя IBM z13 имеет кэш инструкций L1 96 КиБ.

Большинство процессоров являются синхронными схемами, что означает, что они используют тактовый сигнал для управления их последовательными операциями. Тактовый сигнал создается внешней схемой генератора, которая генерирует постоянное количество импульсов каждую секунду в форме периодической прямоугольной волны. Частота тактовых импульсов определяет скорость, с которой ЦП выполняет инструкции, и, следовательно, чем выше тактовая частота, тем больше инструкций ЦП будет выполнять каждую секунду.

Чтобы обеспечить правильную работу ЦП, период тактовой частоты превышает максимальное время, необходимое для распространения (перемещения) через ЦП всех сигналов. Устанавливая период тактовой частоты на значение, намного превышающее задержку распространения для наихудшего случая, можно спроектировать весь ЦП и способ перемещения данных по «краям» нарастающего и падающего тактового сигнала. Это дает преимущество в значительном упрощении ЦП как с точки зрения дизайна, так и с точки зрения количества компонентов. Однако он также несет в себе недостаток, заключающийся в том, что весь ЦП должен ждать своих самых медленных элементов, хотя некоторые его части намного быстрее. Это ограничение в значительной степени компенсируется различными методами увеличения параллелизма ЦП (см. Ниже).

Однако одни только архитектурные улучшения не решают всех недостатков глобально синхронных процессоров. Например, тактовый сигнал подвержен задержкам любого другого электрического сигнала. Более высокие тактовые частоты во все более сложных ЦП затрудняют поддержание тактового сигнала в фазе (синхронизированном) во всем устройстве. Это привело к тому, что многие современные ЦП потребовали предоставления нескольких идентичных тактовых сигналов, чтобы избежать задержки одного сигнала, достаточно значительной, чтобы вызвать сбой ЦП. Другой серьезной проблемой, связанной с резким увеличением тактовой частоты, является количество тепла, которое рассеивается процессором. Постоянно меняющиеся часы заставляют многие компоненты переключаться независимо от того, используются ли они в это время. Как правило, переключающийся компонент потребляет больше энергии, чем элемент в статическом состоянии. Следовательно, с увеличением тактовой частоты растет и потребление энергии, в результате чего ЦП требует большего рассеивания тепла в виде решений охлаждения ЦП.

Один метод работы с переключением ненужных компонентов называется синхронизацией, который включает отключение синхросигнала для ненужных компонентов (их эффективное отключение). Однако это часто считается трудным для реализации и поэтому не находит широкого применения за пределами проектов с очень низким энергопотреблением. Одной из примечательных недавних разработок ЦП, в которой используется расширенная синхронизация, является Xenon на базе IBM PowerPC, используемый в Xbox 360 ; Таким образом значительно снижаются требования к электропитанию Xbox 360. Другой метод решения некоторых проблем с глобальным тактовым сигналом - полное удаление тактового сигнала. Хотя удаление глобального тактового сигнала значительно усложняет процесс проектирования во многих отношениях, асинхронные (или бесчасовые) конструкции обладают заметными преимуществами в потреблении энергии и рассеивании тепла по сравнению с аналогичными синхронными конструкциями. Хотя это несколько необычно, но целые асинхронные процессоры были построены без использования глобального тактового сигнала. Двумя яркими примерами этого являются ARM совместимый AMULET и MIPS R3000-совместимый MiniMIPS.

Вместо того, чтобы полностью удалять тактовый сигнал, некоторые конструкции ЦП позволяют некоторым частям устройства быть асинхронными, например использовать асинхронные ALU в сочетании с суперскалярной конвейерной обработкой для достижения некоторого увеличения арифметической производительности. Хотя не совсем ясно, могут ли полностью асинхронные проекты работать на сопоставимом или более высоком уровне, чем их синхронные аналоги, очевидно, что они, по крайней мере, преуспевают в более простых математических операциях. Это, в сочетании с превосходными характеристиками энергопотребления и рассеивания тепла, делает их очень подходящими для встроенных компьютеров.

Многие современные процессоры имеют встроенный в кристалл модуль управления питанием, который регулирует включение требуется подача напряжения на схему ЦП, что позволяет поддерживать баланс между производительностью и потребляемой мощностью.

Каждый ЦП представляет числовые значения определенным образом. Например, некоторые ранние цифровые компьютеры представляли числа как знакомые десятичные (основание 10) значения системы счисления, а другие использовали более необычные представления, такие как троичное (основание три). Почти все современные процессоры представляют числа в двоичной форме, где каждая цифра представлена некоторой двузначной физической величиной, такой как «высокое» или «низкое» напряжение.

A шестибитовое слово, содержащее двоично-закодированное представление десятичного значения 40. Большинство современных ЦП используют размеры слова, равные степени двойки, например 8, 16, 32 или 64 бита.

A шестибитовое слово, содержащее двоично-закодированное представление десятичного значения 40. Большинство современных ЦП используют размеры слова, равные степени двойки, например 8, 16, 32 или 64 бита. С числовым представлением связаны размер и точность целых чисел, которые может представлять ЦП. В случае двоичного ЦП это измеряется количеством битов (значащие цифры двоичного целого числа), которые ЦП может обработать за одну операцию, что обычно называется размером слова, разрядностью, ширина пути данных, целочисленная точность или целочисленный размер. Целочисленный размер процессора определяет диапазон целочисленных значений, с которыми он может напрямую работать. Например, 8-битный CPU может напрямую управлять целыми числами, представленными восемью битами, которые имеют диапазон 256 (2) дискретных целочисленных значений.

Целочисленный диапазон также может влиять на количество ячеек памяти, которые ЦП может напрямую адресовать (адрес - это целочисленное значение, представляющее конкретную ячейку памяти). Например, если двоичный ЦП использует 32 бита для представления адреса памяти, он может напрямую адресовать 2 ячейки памяти. Чтобы обойти это ограничение и по другим причинам, некоторые ЦП используют механизмы (такие как переключение банков ), которые позволяют адресовать дополнительную память.

ЦП с большим размером слова требуют большего количества схем и, следовательно, физически больше, стоят больше и потребляют больше энергии (и, следовательно, выделяют больше тепла). В результате в современных приложениях обычно используются более мелкие 4- или 8-битные микроконтроллеры, хотя доступны процессоры с гораздо большими размерами слова (например, 16, 32, 64, даже 128-битные). Однако, когда требуется более высокая производительность, преимущества большего размера слова (большие диапазоны данных и адресные пространства) могут перевешивать недостатки. ЦП может иметь внутренние пути данных короче, чем размер слова, чтобы уменьшить размер и стоимость. Например, хотя набор команд IBM System / 360 был 32-битным набором команд, System / 360 Model 30 и Model 40 имел 8-битные пути данных в арифметико-логическом блоке, так что 32-битное сложение требовало четырех циклов, по одному на каждые 8 бит операндов, и, хотя инструкция Motorola 68000 series set был 32-битным набором команд, Motorola 68000 и Motorola 68010 имели 16-битные пути данных в арифметико-логическом блоке, так что 32-битное сложение требовало двух циклов.

Чтобы получить некоторые преимущества, предоставляемые как более низкой, так и более высокой битовой длиной, многие наборы инструкций имеют разную разрядность для целочисленных данных и данных с плавающей запятой, что позволяет ЦП, реализующим этот набор инструкций, иметь разная разрядность для разных частей устройства. Например, набор команд IBM System / 360 был в основном 32-битным, но поддерживал 64-битные значения с плавающей запятой для обеспечения большей точности и диапазона чисел с плавающей запятой. Модель 65 System / 360 имела 8-битный сумматор для десятичной и двоичной арифметики с фиксированной запятой и 60-битный сумматор для арифметики с плавающей запятой. Во многих более поздних конструкциях ЦП используется аналогичная смешанная разрядность, особенно когда процессор предназначен для универсального использования, когда требуется разумный баланс возможностей целых чисел и чисел с плавающей запятой.

Модель субскалярного ЦП, в которой для выполнения трех инструкций требуется пятнадцать тактовых циклов

Модель субскалярного ЦП, в которой для выполнения трех инструкций требуется пятнадцать тактовых циклов Описание базовой операции ЦП, предложенное в предыдущем разделе, описывает простейшую форму, в которой CPU взять можно. Этот тип ЦП, обычно называемый субскалярным, работает и выполняет одну инструкцию с одним или двумя частями данных за раз, то есть меньше одной инструкции за такт (IPC < 1).

Этот процесс приводит к неэффективности, присущей субскалярным ЦП. Поскольку одновременно выполняется только одна инструкция, весь ЦП должен ждать завершения этой инструкции, прежде чем переходить к следующей инструкции. В результате субскалярный ЦП "зависает" на инструкции, выполнение которых занимает более одного тактового цикла. Даже добавление второй исполнительной единицы (см. ниже) не сильно улучшает производительность; вместо того, чтобы зависать один путь, теперь два пути зависают и количество неиспользуемых транзисторов увеличивается. Эта конструкция, в которой ресурсы выполнения ЦП могут работать только с одной инструкцией за раз, может достичь только скалярной производительности (одна инструкция за такт, IPC = 1). Однако производительность почти всегда субскалярный (менее th одна инструкция на такт, IPC < 1).

Попытки достичь скалярной и лучшей производительности привели к появлению различных методологий проектирования, которые заставляют ЦП вести себя менее линейно и более параллельно. При упоминании параллелизма в ЦП обычно используются два термина для классификации этих методов проектирования:

Каждая методология отличается как способами реализации, так и относительной эффективностью, которую они обеспечивают для увеличения производительности ЦП для приложения.

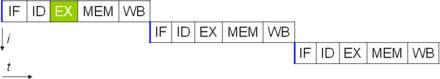

Базовый пятиступенчатый конвейер. В лучшем случае этот конвейер может поддерживать скорость выполнения одной инструкции за такт.

Базовый пятиступенчатый конвейер. В лучшем случае этот конвейер может поддерживать скорость выполнения одной инструкции за такт. Один из простейших методов, используемых для достижения повышенного параллелизма, - это начать первые шаги выборки и декодирования инструкций до того, как завершится выполнение предыдущей инструкции.. Это простейшая форма метода, известная как конвейерная обработка инструкций, и используется почти во всех современных ЦП общего назначения. Конвейерная обработка позволяет выполнять более одной инструкции в любой момент времени, разбивая путь выполнения на отдельные этапы. Это разделение можно сравнить с конвейерной линией, на которой инструкция выполняется более полной на каждом этапе, пока она не выйдет из конвейера выполнения и не будет удалена.

Конвейерная обработка, однако, дает возможность ситуации, когда результат предыдущей операции необходим для завершения следующей операции; состояние, часто называемое конфликтом зависимости данных. Чтобы справиться с этим, необходимо уделять особое внимание проверке таких условий и задержке части конвейера команд , если это происходит. Естественно, для этого требуются дополнительные схемы, поэтому конвейерные процессоры более сложны, чем субскалярные (хотя и не очень). Конвейерный процессор может стать почти скалярным, что сдерживается только остановками конвейера (инструкция тратит более одного такта на этапе).

Простой суперскалярный конвейер. Посредством выборки и отправки двух инструкций за один раз можно выполнить максимум две инструкции за такт.

Простой суперскалярный конвейер. Посредством выборки и отправки двух инструкций за один раз можно выполнить максимум две инструкции за такт. Дальнейшее усовершенствование идеи конвейерной обработки инструкций привело к разработке метода, который еще больше снижает время простоя компонентов ЦП. Проекты, которые считаются суперскалярными, включают длинный конвейер команд и несколько идентичных исполнительных блоков, таких как блоки загрузки-сохранения, арифметико-логические блоки, блоки с плавающей запятой и блоки генерации адресов. В суперскалярном конвейере несколько инструкций считываются и передаются диспетчеру, который решает, могут ли инструкции выполняться параллельно (одновременно). Если это так, они отправляются доступным исполнительным модулям, что дает возможность одновременного выполнения нескольких инструкций. В общем, чем больше инструкций суперскалярный ЦП может отправить одновременно ожидающим исполнительным модулям, тем больше инструкций будет выполнено в данном цикле.

Большая часть трудностей при проектировании суперскалярной архитектуры ЦП заключается в создании эффективного диспетчера. Диспетчер должен иметь возможность быстро и правильно определять, могут ли инструкции выполняться параллельно, а также отправлять их таким образом, чтобы поддерживать как можно больше исполнительных модулей занятыми. Это требует, чтобы конвейер команд заполнялся как можно чаще, и вызывает потребность в суперскалярных архитектурах в значительных объемах кэша ЦП. Он также делает методы предотвращения опасности, такие как прогнозирование ветвлений, спекулятивное исполнение, переименование регистров, выполнение вне очереди. и транзакционная память имеет решающее значение для поддержания высокого уровня производительности. Пытаясь предсказать, какое ответвление (или путь) займет условная инструкция, ЦП может минимизировать количество раз, которое весь конвейер должен ждать, пока условная инструкция не будет завершена. Спекулятивное выполнение часто обеспечивает умеренное повышение производительности за счет выполнения частей кода, которые могут не понадобиться после завершения условной операции. Выполнение вне очереди несколько изменяет порядок, в котором выполняются инструкции, чтобы уменьшить задержки из-за зависимостей данных. Также в случае одиночного потока инструкций, множественного потока данных - в случае, когда необходимо обработать много данных одного и того же типа - современные процессоры могут отключать части конвейера, чтобы при выполнении одной инструкции при многократном выполнении ЦП пропускает фазы выборки и декодирования и, таким образом, значительно увеличивает производительность в определенных случаях, особенно в очень монотонных программных механизмах, таких как программное обеспечение для создания видео и обработки фотографий.

В случае, когда часть ЦП является суперскалярной, а часть - нет, часть, которая не является суперскалярной, страдает от потери производительности из-за задержек при планировании. Intel P5 Pentium имел два суперскалярных ALU, каждый из которых мог принимать одну инструкцию за такт, но его FPU не мог принимать одну инструкцию за такт. Таким образом, P5 был целочисленным суперскаляром, но не суперскаляром с плавающей запятой. Преемник архитектуры Intel P5, P6, добавил суперскалярные возможности к своим функциям с плавающей запятой и, следовательно, позволил значительно повысить производительность команд с плавающей запятой.

И простая конвейерная обработка, и суперскалярная конструкция увеличивают ILP ЦП, позволяя одному процессору завершить выполнение инструкций со скоростью, превышающей одну инструкцию за такт. Большинство современных ЦП являются, по крайней мере, несколько суперскалярными, и почти все ЦП общего назначения, разработанные в последнее десятилетие, являются суперскалярными. В последующие годы часть внимания при разработке компьютеров с высоким уровнем ILP была перенесена с аппаратного обеспечения ЦП на его программный интерфейс, или ISA. Стратегия очень длинного командного слова (VLIW) приводит к тому, что некоторая часть ILP становится подразумеваемой непосредственно программным обеспечением, уменьшая объем работы, которую CPU должен выполнять для повышения ILP, и тем самым уменьшая сложность конструкции.

Другая стратегия достижения производительности - параллельное выполнение нескольких потоков или процессов. Эта область исследований известна как параллельные вычисления. В таксономии Флинна эта стратегия известна как поток нескольких инструкций, поток нескольких данных (MIMD).

Одной из технологий, используемых для этой цели, была многопроцессорная обработка (МП). Первоначальная разновидность этой технологии известна как симметричная многопроцессорная обработка (SMP), при которой небольшое количество процессоров совместно используют согласованное представление о своей системе памяти. В этой схеме каждый ЦП имеет дополнительное оборудование для постоянного обновления памяти. Избегая устаревших представлений о памяти, процессоры могут взаимодействовать с одной и той же программой, а программы могут переноситься с одного процессора на другой. Чтобы увеличить количество взаимодействующих процессоров за пределы горстки, в 1990-х годах были введены такие схемы, как неоднородный доступ к памяти (NUMA) и протоколы согласованности на основе каталогов. Системы SMP ограничены небольшим количеством процессоров, в то время как системы NUMA были построены с тысячами процессоров. Первоначально многопроцессорность была построена с использованием нескольких дискретных процессоров и плат для реализации взаимосвязи между процессорами. Когда все процессоры и их взаимосвязь реализованы на одном кристалле, технология известна как многопроцессорная обработка на уровне кристалла (CMP), а один кристалл - как многоядерный процессор.

параллелизм существовал с единственной программой. Одна программа может иметь несколько потоков (или функций), которые могут выполняться отдельно или параллельно. Некоторые из самых ранних примеров этой технологии реализовали обработку ввода / вывода, такую как прямой доступ к памяти, как отдельный поток от вычислительного потока. Более общий подход к этой технологии был представлен в 1970-х годах, когда системы были разработаны для параллельного выполнения нескольких вычислительных потоков. Эта технология известна как многопоточность (MT). Этот подход считается более рентабельным, чем многопроцессорность, поскольку только небольшое количество компонентов в ЦП реплицируется для поддержки MT, в отличие от всего ЦП в случае MP. В MT исполнительные блоки и система памяти, включая кеши, совместно используются несколькими потоками. Обратной стороной МП является то, что аппаратная поддержка многопоточности более заметна для программного обеспечения, чем поддержка МП, и, следовательно, программное обеспечение супервизора, такое как операционные системы, должно претерпевать более значительные изменения для поддержки МП. Один из реализованных типов МП известен как временная многопоточность, где один поток выполняется до тех пор, пока он не остановится в ожидании возврата данных из внешней памяти. В этой схеме ЦП затем быстро переключает контекст на другой поток, который готов к работе, переключение часто выполняется за один такт процессора, например, UltraSPARC T1. Другой тип МП - это одновременная многопоточность, когда инструкции из нескольких потоков выполняются параллельно в течение одного тактового цикла ЦП.

В течение нескольких десятилетий с 1970-х до начала 2000-х годов при разработке высокопроизводительных ЦП общего назначения основное внимание уделялось достижению высокого уровня ILP с помощью таких технологий, как конвейерная обработка, кэширование, суперскалярное выполнение, выполнение вне очереди и т. Д. Эта тенденция привела к появлению больших и энергоемких процессоров, таких как Intel Pentium 4. К началу 2000-х разработчики ЦП не могли достичь более высокой производительности с помощью методов ILP из-за растущего несоответствия между рабочими частотами ЦП и рабочими частотами основной памяти, а также растущего рассеивания мощности ЦП из-за более эзотерических методов ILP.

Разработчики ЦП затем позаимствовали идеи с рынков коммерческих вычислений, таких как обработка транзакций, где совокупная производительность нескольких программ, также известная как пропускная способность вычислений, была важнее, чем производительность одного потока или процесса.

Об этом изменении акцента свидетельствует распространение двухъядерных процессоров и процессоров с большим числом ядер и, в частности, новые разработки Intel, напоминающие его менее суперскалярную архитектуру P6. Поздние разработки в нескольких семействах процессоров демонстрируют CMP, включая x86-64 Opteron и Athlon 64 X2, SPARC UltraSPARC T1, IBM POWER4 и POWER5, а также несколько процессоров консоли для видеоигр, таких как тройной процессор Xbox 360. основной дизайн PowerPC и 7-ядерный Cell микропроцессор PlayStation 3 .

Менее распространенная, но все более важная парадигма процессоров (и действительно, вычисления в общие) касается параллелизма данных. Все процессоры, описанные ранее, называются скалярными устройствами определенного типа. Как следует из названия, векторные процессоры обрабатывают несколько фрагментов данных в контексте одной инструкции. В этом отличие от скалярных процессоров, которые обрабатывают один фрагмент данных для каждой инструкции. Используя таксономию Флинна, эти две схемы работы с данными обычно упоминаются как поток одиночных инструкций, поток множественных данных (SIMD) и поток одиночных инструкций, одиночный поток данных (SISD) соответственно. Большая полезность в создании процессоров, которые имеют дело с векторами данных, заключается в оптимизации задач, которые обычно требуют выполнения одной и той же операции (например, суммы или скалярного произведения ) для большого набора данных. Некоторые классические примеры этих типов задач включают мультимедийные приложения (изображения, видео и звук), а также многие типы научных и инженерных задач. В то время как скалярный процессор должен завершить весь процесс выборки, декодирования и выполнения каждой инструкции и значения в наборе данных, векторный процессор может выполнить единственную операцию над сравнительно большим набором данных с помощью одной инструкции. Это возможно только в том случае, если приложение требует много шагов, которые применяют одну операцию к большому набору данных.

Самые ранние векторные процессоры, такие как Cray-1, были связаны почти исключительно с научными исследованиями и криптографическими приложениями. Однако, поскольку мультимедиа в значительной степени переместилась на цифровые носители, потребность в той или иной форме SIMD в процессорах общего назначения стала значительной. Вскоре после того, как включение модулей с плавающей запятой стало обычным явлением в процессорах общего назначения, спецификации и реализации исполнительных модулей SIMD также начали появляться для процессоров общего назначения. Некоторые из этих ранних спецификаций SIMD - например, HP Multimedia Acceleration eXtensions (MAX) и Intel MMX - были только целочисленными. Это оказалось серьезным препятствием для некоторых разработчиков программного обеспечения, поскольку многие приложения, использующие SIMD, в основном работают с числами с плавающей запятой. Постепенно разработчики уточняли и переделывали эти ранние проекты в некоторые из общих современных спецификаций SIMD, которые обычно связаны с одним ISA. Некоторые известные современные примеры включают Intel SSE и связанный с PowerPC AltiVec (также известный как VMX).

Облачные вычисления могут включать разделение операций ЦП на виртуальные центральные процессоры (vCPU s).

Хост - это виртуальный эквивалент физической машины, на которой работает виртуальная система. Когда несколько физических машин работают в тандеме и управляются как единое целое, сгруппированные вычислительные ресурсы и ресурсы памяти образуют кластер. В некоторых системах возможно динамическое добавление и удаление из кластера. Ресурсы, доступные на уровне хоста и кластера, могут быть разделены на пулы ресурсов с точной степенью детализации.

Производительность или скорость процессора зависит, среди многих других факторов, тактовая частота (обычно кратная герц ) и количество инструкций за такт (IPC), которые вместе являются факторами для инструкций в секунду (IPS), которые ЦП может выполнить. Многие сообщенные значения IPS представляют собой «пиковые» скорости выполнения искусственных последовательностей инструкций с небольшим количеством ветвей, тогда как реальные рабочие нагрузки состоят из комбинации инструкций и приложений, выполнение некоторых из которых занимает больше времени, чем других. Производительность иерархии памяти также сильно влияет на производительность процессора, и эта проблема практически не учитывается при вычислениях MIPS. Из-за этих проблем были разработаны различные стандартизованные тесты, часто называемые «эталонными тестами» для этой цели - «такие как SPECint - для попытки измерить реальную эффективную производительность в часто используемых приложениях..

Производительность компьютеров повышается за счет использования многоядерных процессоров, которые, по сути, представляют собой подключение двух или более отдельных процессоров (называемых в этом смысле ядер) в одну интегральную схему. В идеале двухъядерный процессор был бы почти вдвое мощнее одноядерного. На практике прирост производительности намного меньше, всего около 50%, из-за несовершенных программных алгоритмов и реализации. Увеличение количества ядер в процессоре (т.е. двухъядерных, четырехъядерных и т. Д.) Увеличивает обрабатываемую рабочую нагрузку. Это означает, что процессор теперь может обрабатывать множество асинхронных событий, прерываний и т. Д., Которые могут сказываться на ЦП при перегрузке. Эти ядра можно рассматривать как разные этажи на перерабатывающем предприятии, где каждый этаж выполняет свою задачу. Иногда эти ядра будут обрабатывать те же задачи, что и соседние с ними ядра, если одного ядра недостаточно для обработки информации.

Из-за особых возможностей современных ЦП, таких как одновременная многопоточность и без ядра, которые предполагают совместное использование фактических ресурсов ЦП с целью увеличения использования, мониторинга уровней производительности и использование оборудования постепенно становилось все более сложной задачей. В ответ некоторые ЦП реализуют дополнительную аппаратную логику, которая отслеживает фактическое использование различных частей ЦП и предоставляет различные счетчики, доступные для программного обеспечения; примером является технология Intel Performance Counter Monitor.

| Викискладе есть материалы, связанные с центральными процессорами. |

| Викиверситет имеет учебные ресурсы по Введение в компьютеры / процессоры |