В теории вероятности условная вероятность является мерой вероятности из события, происходящего, при условии, что другое событие (по предположению, презумпции, утверждению или свидетельству) уже произошло. Если интересующим событием является событие A, а событие B известно или предполагается, что оно произошло, «условная вероятность A при условии B» или «вероятность A при условии B» обычно записывается как P (A | B), или иногда P B (A) или P (A / B). Например, вероятность того, что какой-либо конкретный человек кашляет в любой день, может составлять всего 5%. Но если мы знаем или предполагаем, что человек болен, то у него гораздо больше шансов кашлять. Например, условная вероятность того, что кто-то плохо себя чувствует, кашляет, может составлять 75%, и в этом случае у нас будет P (Кашель) = 5% и P (Кашель | Больной) = 75%.

Условная вероятность - одно из наиболее важных и фундаментальных понятий в теории вероятностей. Но условные вероятности могут быть довольно скользкими и требуют осторожной интерпретации. Например, между A и B не должно быть причинно-следственной связи, и они не должны возникать одновременно.

P (A | B) может быть равно P (A), а может и не быть (безусловная вероятность A). Если P (A | B) = P (A), то события A и B называются независимыми : в таком случае знание любого события не влияет на вероятность друг друга. P (A | B) (условная вероятность A при B) обычно отличается от P (B | A). Например, если у человека денге, у него может быть 90% -ный шанс положительного результата теста на денге. В этом случае измеряется то, что если событие B («лихорадка денге») произошло, вероятность A (тест положительный) при условии, что B (наличие лихорадки денге) имеет место, составляет 90%: то есть P (A | Б) = 90%. В качестве альтернативы, если у человека положительный результат теста на лихорадку денге, у него может быть только 15% шанс действительно заболеть этим редким заболеванием, потому что уровень ложноположительных результатов теста может быть высоким. В этом случае измеряется вероятность события B (наличие денге) при условии, что событие A (тест положительный) произошло: P (B | A) = 15%. Неправильное приравнивание двух вероятностей может привести к различным ошибкам в рассуждении, таким как ошибка базовой ставки. Условные вероятности могут быть обращены с помощью теоремы Байеса.

Условные вероятности могут отображаться в таблице условных вероятностей.

Иллюстрация условных вероятностей с Диаграмма Эйлера. Безусловная вероятность P (A) = 0,30 + 0,10 + 0,12 = 0,52. Однако условная вероятность P (A | B 1) = 1, P (A | B 2) = 0,12 ÷ (0,12 + 0,04) = 0,75 и P (A | B 3) = 0.

Иллюстрация условных вероятностей с Диаграмма Эйлера. Безусловная вероятность P (A) = 0,30 + 0,10 + 0,12 = 0,52. Однако условная вероятность P (A | B 1) = 1, P (A | B 2) = 0,12 ÷ (0,12 + 0,04) = 0,75 и P (A | B 3) = 0.  На древовидной диаграмме вероятности ветвления зависят от события, связанного с родительским узлом. (Здесь верхние черты указывают, что событие не происходит.)

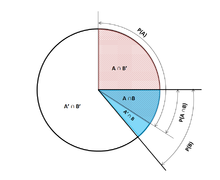

На древовидной диаграмме вероятности ветвления зависят от события, связанного с родительским узлом. (Здесь верхние черты указывают, что событие не происходит.)  Круговая диаграмма Венна, описывающая условные вероятности

Круговая диаграмма Венна, описывающая условные вероятности Даны два события A и B из сигма-поля вероятностного пространства, с безусловной вероятностью B больше нуля (т. Е. P (B)>0), условная вероятность A для данного B определяется как частное вероятности объединения событий A и B, и вероятность события B:

где

Обратите внимание, что приведенное выше уравнение является определением, а не теоретическим результатом. Мы просто обозначаем количество

Некоторые авторы, такие как де Финетти, предпочитают вводить условную вероятность в качестве аксиомы вероятности :

Хотя математически эквивалентно, это может быть предпочтительнее с философской точки зрения; согласно основным интерпретациям вероятностей, таким как субъективная теория, условная вероятность считается примитивной сущностью. Кроме того, эта «аксиома умножения» вводит симметрию с аксиомой суммирования для взаимоисключающих событий :

Условная вероятность можно определить как вероятность условного события

Можно показать, что

, который соответствует определению условной вероятности Колмогорова. Обратите внимание, что в этом случае уравнение

Если P (B) = 0, то согласно простому определению P (A | B) равно undefined. Однако можно определить условную вероятность относительно σ-алгебры таких событий (например, возникающих из непрерывной случайной величины ).

Например, если X и Y являются невырожденными и совместно непрерывными случайными величинами с плотностью ƒ X, Y (x, y), то (при условии, что B имеет положительное значение мера )

Случай, когда B имеет нулевую меру, является проблематичным. Для случая, когда B = y 0 }, представляющего одну точку, условная вероятность может быть определена как:

Однако этот подход приводит к парадоксу Бореля – Колмогорова. Более общий случай нулевой меры еще более проблематичен, как видно из Зная, что предел, когда все δy i стремятся к нулю,

![{\ displaystyle P (X \ in A \ mid Y \ in \ bigcup _ {i} [y_ {i}, y_ {i} + \ delta y_ {i}]) \ приблизительно { \ frac {\ sum _ {i} \ int _ {x \ in A} f_ {X, Y} (x, y_ {i}) \, dx \, \ delta y_ {i}} {\ sum _ {i } \ int _ {x \ in \ mathbb {R}} f_ {X, Y} (x, y_ {i}) \, dx \, \ delta y_ {i}}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/26f127ee4281f3096623f1808477d47e2d60ad01)

зависит от их отношения, когда они приближаются к нулю. См. условное ожидание для получения дополнительной информации.

Пусть X - случайная величина; мы предполагаем, что X конечно, то есть X принимает только конечное число значений x. Пусть A - событие, тогда условная вероятность A для данного X определяется как случайная величина, записанная P (A | X), которая принимает значение

всякий раз, когда

Более формально,

Условная вероятность P (A | X) является функцией X. Например. если функция g определяется как

, то

Обратите внимание, что P (A | X) и X теперь оба случайные величины. Согласно закону полной вероятности , ожидаемое значение P (A | X) равно безусловной вероятности A.

Частичная условная вероятность

Исходя из этого, частичную условную вероятность можно определить как

где

Обусловленность Джеффри - это особый случай частичной условной вероятности, в котором условные события должны образовывать раздел :

Предположим, что кто-то тайно бросает два честных шестигранных кубика, и мы хотим вычислить вероятность того, что открытая сумма первого кубика равна 2, учитывая информацию о том, что их сумма не превышает 5.

Вероятность того, что D 1 = 2

Таблица 1 показывает интервал выборки 36 комбинаций выпавших значений двух кубиков, каждая из которых встречается с вероятностью 1/36, с числами, отображенными красным и темно-серым. ячейки равны D 1 + D 2.

D1= 2 ровно в 6 из 36 исходов; таким образом, P (D 1 = 2) = ⁄ 36 = ⁄ 6:

| + | D2 | ||||||

|---|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | ||

| D1 | 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 2 | 3 | 4 | 5 | 6 | 7 | 8 | |

| 3 | 4 | 5 | 6 | 7 | 8 | 9 | |

| 4 | 5 | 6 | 7 | 8 | 9 | 10 | |

| 5 | 6 | 7 | 8 | 9 | 10 | 11 | |

| 6 | 7 | 8 | 9 | 10 | 11 | 12 | |

Вероятность того, что D 1 + D 2 ≤ 5

Таблица 2 показывает, что D 1 + D 2 ≤ 5 ровно для 10 из 36 результатов, таким образом, P (D 1 + D 2 ≤ 5) = ⁄ 36:

| + | D2 | ||||||

|---|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | ||

| D1 | 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 2 | 3 | 4 | 5 | 6 | 7 | 8 | |

| 3 | 4 | 5 | 6 | 7 | 8 | 9 | |

| 4 | 5 | 6 | 7 | 8 | 9 | 10 | |

| 5 | 6 | 7 | 8 | 9 | 10 | 11 | |

| 6 | 7 | 8 | 9 | 10 | 11 | 12 | |

Вероятность того, что D 1 = 2 при условии, что D 1 + D 2 ≤ 5

Таблица 3 показывает, что для 3 из этих 10 исходов D 1 = 2.

Таким образом, условная вероятность P (D 1 = 2 | D 1+D2≤ 5) = ⁄ 10 = 0,3:

| + | D2 | ||||||

|---|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | ||

| D1 | 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 2 | 3 | 4 | 5 | 6 | 7 | 8 | |

| 3 | 4 | 5 | 6 | 7 | 8 | 9 | |

| 4 | 5 | 6 | 7 | 8 | 9 | 10 | |

| 5 | 6 | 7 | 8 | 9 | 10 | 11 | |

| 6 | 7 | 8 | 9 | 10 | 11 | 12 | |

Здесь, в более ранней записи для определения условной вероятности, обусловливающее событие B - это то, что D 1 + D 2 ≤ 5, и событие A равно D 1 = 2. Имеем

В статистическом выводе условная вероятность - это обновление вероятности события на основе новой информации. Включение новой информации может быть выполнено следующим образом:

.

. относительно P (B), вероятность того, что B произошло.

относительно P (B), вероятность того, что B произошло. всякий раз, когда P (B)>0, и 0 в противном случае.

всякий раз, когда P (B)>0, и 0 в противном случае.Результатом этого подхода является в вероятностной мере, которая согласуется с исходной вероятностной мерой и удовлетворяет всем аксиомам Колмогорова. Эта мера условной вероятности также могла быть результатом предположения, что относительная величина вероятности A по отношению к X будет сохранена по отношению к B (см. Формальный вывод ниже).

Формулировка «свидетельство» или «информация» обычно используется в байесовской интерпретации вероятности. Условное событие интерпретируется как свидетельство условного события. То есть P (A) - это вероятность A до учета свидетельства E, а P (A | E) - это вероятность A после учета свидетельства E или после обновления P (A). Это согласуется с частотной интерпретацией, которая является первым определением, данным выше.

События A и B определяются как статистически независимые, если

Если P (B) не равно нулю, то это эквивалентно утверждению, что

Аналогично, если P (A) не равно нулю, то

также эквивалентно. Хотя производные формы могут показаться более интуитивно понятными, они не являются предпочтительным определением, поскольку условные вероятности могут быть неопределенными, а предпочтительное определение является симметричным в A и B.

Независимые события против взаимоисключающих событий

Концепции взаимно независимые события и взаимоисключающие события являются отдельными и разными. В следующей таблице сравниваются результаты для двух случаев (при условии, что вероятность обусловливающего события не равна нулю).

| Если статистически независимый | Если взаимоисключающий | |

|---|---|---|

|  | 0 |

|  | 0 |

|  | 0 |

Фактически, взаимоисключающие события не могут быть статистически независимыми (если только они оба не являются невозможно), поскольку знание того, что одно происходит, дает информацию о другом (в частности, что последнее, безусловно, не произойдет).

Геометрическая визуализация теоремы Байеса. В таблице значения 2, 3, 6 и 9 дают относительные веса каждого соответствующего условия и случая. Цифры обозначают ячейки таблицы, участвующие в каждой метрике, вероятность - это доля каждой затененной цифры. Это показывает, что P (A | B) P (B) = P (B | A) P (A), то есть P (A | B) = P (B | A) P (A) / P (B). Аналогичные рассуждения можно использовать, чтобы показать, что P (Ā | B) = P (B | Ā) P (Ā) / P (B) и т. Д.

Геометрическая визуализация теоремы Байеса. В таблице значения 2, 3, 6 и 9 дают относительные веса каждого соответствующего условия и случая. Цифры обозначают ячейки таблицы, участвующие в каждой метрике, вероятность - это доля каждой затененной цифры. Это показывает, что P (A | B) P (B) = P (B | A) P (A), то есть P (A | B) = P (B | A) P (A) / P (B). Аналогичные рассуждения можно использовать, чтобы показать, что P (Ā | B) = P (B | Ā) P (Ā) / P (B) и т. Д. В общем, нельзя предполагать, что P (A | B) ≈ P (B | A). Это может быть коварной ошибкой даже для тех, кто хорошо разбирается в статистике. Связь между P (A | B) и P (B | A) задается теоремой Байеса :

То есть P (A | B) ≈ P (B | A), только если P (B) / P (A) ≈ 1, или, что то же самое, P (А) ≈ Р (В).

В общем, нельзя предполагать, что P (A) ≈ P (A | B). Эти вероятности связаны посредством закона полной вероятности :

где события

Эта ошибка может возникнуть из-за систематической ошибки выбора. Например, в контексте медицинского заявления, пусть S C будет событием, когда последствия (хроническое заболевание) S возникает как следствие обстоятельств (острое состояние) C. Пусть H будь то случай, когда человек обращается за медицинской помощью. Предположим, что в большинстве случаев C не вызывает S (так что P (S C) является низким). Предположим также, что за медицинской помощью обращаются только в том случае, если S возник из-за C. Исходя из опыта пациентов, врач может ошибочно заключить, что P (S C) высокий. Фактическая вероятность, наблюдаемая врачом, равна P (S C | H).

Частичное или полное отсутствие учета априорной вероятности называется пренебрежением базовой ставкой. Обратное, недостаточная корректировка априорной вероятности - это консерватизм.

Формально P (A | B) определяется как вероятность A согласно новой функции вероятности в пространстве выборок., так что результаты, не входящие в B, имеют вероятность 0 и что это согласуется со всеми исходными вероятностными мерами.

Пусть Ω будет пространством выборки с элементарными событиями {ω}, и пусть P - вероятностная мера относительно σ-алгебры области Ω. Предположим, нам сказали, что произошло событие B ⊆ Ω. Новое распределение вероятностей (обозначенное условным обозначением) должно быть присвоено на {ω}, чтобы отразить это. Все события, не входящие в B, будут иметь нулевую вероятность в новом распределении. Для событий в B должны быть выполнены два условия: вероятность B равна единице, и относительные величины вероятностей должны быть сохранены. Первое требуется в соответствии с аксиомами вероятности, а второе вытекает из того факта, что новая вероятностная мера должна быть аналогом P, в котором вероятность B равна единице - и каждое событие, которое не является в B, следовательно, имеет нулевую вероятность. Следовательно, для некоторого масштабного коэффициента α новое распределение должно удовлетворять:

Подставляя 1 и 2 в 3, чтобы выбрать α:

![{\ displaystyle {\ begin {align} 1 = \ sum _ {\ omega \ in \ Omega} { P (\ omega \ mid B)} \\ = \ sum _ {\ omega \ in B} {P (\ omega \ mid B)} + {\ cancelto {0} {\ sum _ {\ omega \ notin B } P (\ omega \ mid B)}} \\ = \ alpha \ sum _ {\ omega \ in B} {P (\ omega)} \\ [5pt] = \ alpha \ cdot P (B) \ \ [5pt] \ Rightarrow \ alpha = {\ frac {1} {P (B)}} \ end {align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bc21b49c38af5566aeb4794016be9ee06b40458c)

Итак, новое распределение вероятностей равно

Теперь для общего события A

![{\ displaystyle {\ begin {align} P (A \ mid B) = \ sum _ {\ omega \ in A \ cap B} {P (\ omega \ mid B)} + {\ cancelto {0} { \ sum _ {\ omega \ in A \ cap B ^ {c}} P (\ omega \ mid B)}} \\ = \ sum _ {\ omega \ in A \ cap B} {\ frac {P ( \ omega)} {P (B)}} \\ [5pt] = {\ frac {P (A \ cap B)} {P (B)}} \ end {align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f6e98f9200e5cf74a15231fc3c753ccfeb8d1c6)

| На Викискладе есть материалы, связанные с Условная вероятность. |