Представление типа случайного процесса

В статистика, эконометрика и обработка сигналов, авторегрессивная (AR) модель является представлением типа случайного процесса ; как таковой, он используется для описания определенных изменяющихся во времени процессов природы, экономики и т. д. Модель авторегрессии определяет, что выходная переменная линейно зависит от собственных значений и на стохастическом члене (неточно предсказуемый термин); таким образом, модель имеет форму стохастического разностного уравнения (или рекуррентного отношения, которое не следует путать с дифференциальным уравнением). Вместе с моделью скользящего среднего (MA), это частный случай и ключевой компонент более общего авторегрессионного скользящего среднего (ARMA) и интегрированного авторегрессионного скользящего усредненные модели (ARIMA) временного ряда , которые имеют более сложную стохастическую структуру; это также частный случай модели векторной авторегрессии (VAR), которая состоит из более чем одного взаимосвязанного стохастического разностного уравнения для более чем одной развивающейся случайной величины.

В отличие от модели скользящего среднего (MA), авторегрессионная модель не всегда стационарная, поскольку может содержать единичный корень.

Содержание

- 1 Определение

- 2 Межвременной эффект шоков

- 3 Характеристический полином

- 4 Графики значение процессов AR (p)

- 5 Пример: процесс AR (1)

- 5.1 Явное среднее / разница форма процесса AR (1)

- 6 Выбор максимального запаздывания

- 7 Расчет параметров AR

- 7.1 Уравнения Юла - Уокера

- 7.2 Оценка параметров AR

- 8 Спектр

- 8.1 AR (0)

- 8.2 AR (1)

- 8.3 AR (2)

- 9 Реализации в статистических пакетах

- 10 Импульсная характеристика

- 11 Прогнозирование на n-шаг вперед

- 12 Оценка качества прогнозов

- 13 См. также

- 14 Примечания

- 15 Ссылки

- 16 Внешние ссылки

Определение

Обозначение  указывает авторегрессионную модель порядка p. Модель AR (p) определяется как

указывает авторегрессионную модель порядка p. Модель AR (p) определяется как

где  - параметры модели,

- параметры модели,  - константа, и

- константа, и  - это белый шум. Это может быть эквивалентно записано с использованием оператора обратного сдвига B как

- это белый шум. Это может быть эквивалентно записано с использованием оператора обратного сдвига B как

так, чтобы переместить член суммирования влево и используя полиномиальное обозначение, имеем

![{\ displaystyle \ phi [B] X_ {t} = c + \ varepsilon _ {t} \,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b384dd193d1b8b0063a997d5a8d65434a7908880)

Таким образом, авторегрессионная модель может рассматривать как результат всего- полюса фильтр с бесконечной импульсной характеристикой, входной сигнал которого - белый шум.

Некоторые ограничения параметров необходимы для того, чтобы модель оставалась стационарной в широком смысле. Например, процессы в модели AR (1) с  не являются стационарными. В более общем смысле, чтобы модель AR (p) была стационарной в широком смысле, корни многочлена

не являются стационарными. В более общем смысле, чтобы модель AR (p) была стационарной в широком смысле, корни многочлена  должен лежать за пределами единичного круга, т. е., каждый (комплексный) корень

должен лежать за пределами единичного круга, т. е., каждый (комплексный) корень  должен удовлетворять

должен удовлетворять  (см. стр. 88,90).

(см. стр. 88,90).

Межвременной эффект шоков

В процессе AR одноразовый шок влияет на значения эволюционирующей переменной бесконечно далеко в будущее. модель AR (1)  . Ненулевое значение для

. Ненулевое значение для  при скажем, время t = 1 влияет на

при скажем, время t = 1 влияет на  на отношение

на отношение  . Тогда по уравнению AR для

. Тогда по уравнению AR для  в терминах

в терминах  , это влияет на

, это влияет на  на отношение

на отношение  . Тогда по уравнению AR для

. Тогда по уравнению AR для  в терминах

в терминах  , это влияет на

, это влияет на  на сумму

на сумму  . Продолжение этого процесса показывает, что эффект

. Продолжение этого процесса показывает, что эффект  никогда не заканчивается, хотя процесс стационарный, то эффект уменьшается до нуля. в пределе.

никогда не заканчивается, хотя процесс стационарный, то эффект уменьшается до нуля. в пределе.

Временя каждого шок влияет на значения X бесконечно далеко в будущем их возникновения, на заданное значение X t влиять на шоки, происходящие бесконечно далеко в прошлом. Это также можно увидеть, переписав авторегрессию

(где константа термин был опущен, предполагаемая, что переменная была измерена как отклонение от своего среднего) как

Когда полиномиальное деление справа равно полином в операторе обратного сдвига, примененный к  , имеет бесконечный порядок, то есть бесконечное количество запаздывающих значений

, имеет бесконечный порядок, то есть бесконечное количество запаздывающих значений  появляется в правой части уравнения.

появляется в правой части уравнения.

Характеристический многочлен

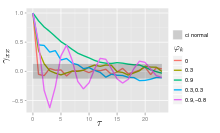

автокорреляционная функция процесса AR (p) может быть выражена как

где  являются корнями многочлена

являются корнями многочлена

где B - оператор обратного сдвига, где  - функция, определяющая авторегрессию, а где

- функция, определяющая авторегрессию, а где  - коэффициенты авторегрессии.

- коэффициенты авторегрессии.

Автокорреляционная функция процесса AR (p) представляет собой сумму убывающих экспонент.

- Каждый действительный корень вносит свой вклад в автокорреляционную функцию, которая экспоненциально затухает.

- Точно так же каждая пара комплексно-сопряженных корней вносит свой вклад в экспоненциально затухающие колебания.

Графики процессов AR (p)

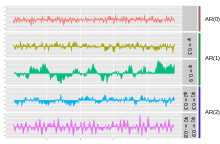

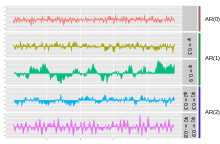

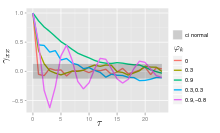

AR (0); AR (1) с параметром AR 0.3; AR (1) с параметром AR 0.9; AR (2) с строгими AR 0,3 и 0,3; и AR (2) включает AR 0,9 и -0,8

Простейшим AR является AR (0), который не имеет зависимости между членами. Только термин ошибка / инновация / шум вносит вклад в результат процесса, поэтому на рисунке AR (0) соответствует белому шуму.

Для процесса AR (1) с положительным значением  , только предыдущий член в процессе и шумовой член вносит вклад в вывод. Если

, только предыдущий член в процессе и шумовой член вносит вклад в вывод. Если  близко к 0, тогда процесс по-прежнему выглядит как белый шум, но по мере приближения

близко к 0, тогда процесс по-прежнему выглядит как белый шум, но по мере приближения  1, выходной сигнал получает больший вклад от предыдущего члена по сравнению с шумом. Это приводит к «сглаживанию» или интеграции выходного сигнала, аналогичному фильтру нижних частот.

1, выходной сигнал получает больший вклад от предыдущего члена по сравнению с шумом. Это приводит к «сглаживанию» или интеграции выходного сигнала, аналогичному фильтру нижних частот.

Для процесса AR (2) два предыдущих члена и шумовой член вносят вклад в вывод. Если оба значения  и

и  положительны, вывод будет напоминать фильтр нижних частот, с уменьшением высокочастотной части шума. Если

положительны, вывод будет напоминать фильтр нижних частот, с уменьшением высокочастотной части шума. Если  положительно, а

положительно, а  отрицательно, то процесс способствует смене знака между сроками процесса. Выход колеблется. Это можно сравнить с обнаружением края или изменением направления.

отрицательно, то процесс способствует смене знака между сроками процесса. Выход колеблется. Это можно сравнить с обнаружением края или изменением направления.

Пример: процесс AR (1)

Процесс AR (1) задается следующим образом:

где  - белый шум с нулевым средним и постоянной дисперсией

- белый шум с нулевым средним и постоянной дисперсией  . (Примечание: индекс в

. (Примечание: индекс в  был опущен.) Процесс является стационарным в широком смысле, если

был опущен.) Процесс является стационарным в широком смысле, если  , поскольку он получается как выходной сигнал стабильного фильтра, на входе которого используется белый шум. (Если

, поскольку он получается как выходной сигнал стабильного фильтра, на входе которого используется белый шум. (Если  , тогда дисперсия

, тогда дисперсия  зависит от запаздывания t, так что дисперсия ряда расходится до бесконечности, когда t стремится к бесконечности, и, следовательно, не является стационарной в широком смысле.) Предполагаемая, что

зависит от запаздывания t, так что дисперсия ряда расходится до бесконечности, когда t стремится к бесконечности, и, следовательно, не является стационарной в широком смысле.) Предполагаемая, что  , среднее

, среднее  идентично для всех значений t по самому определению стационарности в широком смысле. Если среднее обозначено как

идентично для всех значений t по самому определению стационарности в широком смысле. Если среднее обозначено как  , из

, из

что

и, следовательно,

В частности, если  , то среднее

, то среднее

дисперсия равна

где  - стандартное отклонение

- стандартное отклонение  . Это можно показать, заметив, что

. Это можно показать, заметив, что

, а, заметив, что указанная выше величина является стабильной фиксированной точкой этой связь.

автоковариация определяется как

Можно видеть, что функция автоковариации затухает со временем спада (также называемым временем ) от  [чтобы увидеть это, напишите

[чтобы увидеть это, напишите  где

где  не зависит от

не зависит от  . Тогда заметим, что

. Тогда заметим, что  и сопоставьте это с законом экспоненциального затухания

и сопоставьте это с законом экспоненциального затухания  ].

].

Функция спектральной плотности представляет собой преобразование Фурье функции автоковариации. В дискретных терминах это будет преобразование Фурье с дискретным временем:

Это выражение является периодическим из-за дискретного характера  , который проявляется как член косинуса в знаменателе. Если предположить, что время выборки (

, который проявляется как член косинуса в знаменателе. Если предположить, что время выборки ( ) намного меньше, чем время затухания (

) намного меньше, чем время затухания ( ), то мы можем использовать континуальное приближение к

), то мы можем использовать континуальное приближение к  :

:

, что дает лоренцев профиль для спектральной плотности:

, где  - угловая частота, связанная со временем затухания.

- угловая частота, связанная со временем затухания.  .

.

Альтернативное выражение для  можно получить, сначала подставив

можно получить, сначала подставив  для

для  в определении уравнении. Продолжение этого процесса N раз дает

в определении уравнении. Продолжение этого процесса N раз дает

Если N приближается к бесконечности,  подойдет нуль и:

подойдет нуль и:

Видно, что  представляет собой белый шум, свёрнутый с

представляет собой белый шум, свёрнутый с  ядро плюс постоянное среднее. Если белый шум

ядро плюс постоянное среднее. Если белый шум  является гауссовским процессом, то

является гауссовским процессом, то  также является гауссовским процессом. В других случаях центральная предельная теорема указывает, что

также является гауссовским процессом. В других случаях центральная предельная теорема указывает, что  будет приблизительно нормально распределиться, когда

будет приблизительно нормально распределиться, когда  близок к единице.

близок к единице.

Явная форма среднего / разностного процесса AR (1)

Модель AR (1) представляет собой дискретную временную аналогию непрерывного процесса Орнштейна-Уленбека. Поэтому иногда полезно понимать модели AR (1), приведенной в эквивалентной форме. В этой модели AR (1) с параметром формы процесса  задается следующим образом:

задается следующим образом:

, где

, где  и

и  - это модельное среднее.

- это модельное среднее.

Поместить это в формулу  , а затем развернуть ряд для

, а затем развернуть ряд для  , можно показать, что:

, можно показать, что:

![{\ displaystyle \ operatorname {E} (X_ {t + n } | X_ {t}) = \ mu \ left [1- \ theta ^ {n} \ right] + X_ {t} \ theta ^ {n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/57e7ce545d36dfb0de17a55881ba8322e99955a5) и

и .

.

Выбор максимальной задержки

Частичная автокорреляция процесса AR (p) равна нулю ской, не превышающей порядок p, и обеспечивает хорошую модель для корреляции между  и

и  , поэтому соответствующая максимальная задержка - это та, при превышении которой частичная автокорреляция все равны нулю.

, поэтому соответствующая максимальная задержка - это та, при превышении которой частичная автокорреляция все равны нулю.

Расчет параметров AR

Существует множество способов оценки коэффициентов, например, обычная процедура наименьших квадратов или метод моментов (через уравнения Юла - Уокера).

Модель AR (p) задается уравнением

Он основан на параметрах  где i = 1,..., p. Между этими функциями процесса существует прямое соответствие, это соответствие может быть инвертировано для определения параметров из автокорреляционной функции (сама получается из ковариаций). Это делается с помощью формулы Юла - Уокера.

где i = 1,..., p. Между этими функциями процесса существует прямое соответствие, это соответствие может быть инвертировано для определения параметров из автокорреляционной функции (сама получается из ковариаций). Это делается с помощью формулы Юла - Уокера.

Уравнения Юла - Уокера

Уравнения Юла - Уокера, названные в честь Удни Юла и Гилберта Уокера, представленные собой соответствующие системы.

где m = 0,..., p, что дает p + 1 уравнение. Здесь  - автоковариационная функция X t,

- автоковариационная функция X t,  - стандартное а

- стандартное а  - дельта-функция Кронекера.

- дельта-функция Кронекера.

Временная последняя часть отдельного уравнения отлична от нуля, только если m = 0, система уравнений может быть решена путем представления для m>0 в матричной форме, таким образом получая уравнение

который может быть решен для всех  Оставшееся уравнение для m = 0:

Оставшееся уравнение для m = 0:

который, однажды  известны, могут быть решены для

известны, могут быть решены для

Альтернативная формулировка в терминах автокорреляционная функция. Параметры AR определяются первыми p + 1 элементами  автокорреляционная функция. Затем полная автокорреляционная функция может быть получена путем рекурсивного вычисления

автокорреляционная функция. Затем полная автокорреляционная функция может быть получена путем рекурсивного вычисления

Примеры для некоторых процессов AR (p) низкого порядка

- p = 1

- , следовательно,

- p = 2

- Уравнения Юла - Уокера для процесса AR (2):

- Помните, что

- Первое использование уравнения дает

- Используя формулу рекурсии, получаем

Оценка параметров параметров AR

Приведенные выше уравнения (уравнения Юла-Уокера) используют несколько способов оценки параметров модели AR (p) путем теоретических ковариаций оценочных значений. Некоторые из этих вариантов можно описать следующим образом:

- Оценка автоковариаций или автокорреляций. Здесь каждый из этих слагаемых оценивается отдельно с использованием этих общепринятых оценок. Есть разные способы сделать это, и выбор между ними влияет на свойства схемы оценки. Например, отрицательные оценки дисперсии могут быть получены с помощью некоторых вариантов.

- Формулировка в виде задачи регрессии наименьших квадратов, в которой строится обычная задача прогнозирования методом наименьших квадратов на основе прогнозирования значений X t на p предыдущих значений той же серии. Это можно рассматривать как схему прямого прогнозирования. Можно, что нормальные уравнения для этой задачи соответствуют аппроксимации матричной формы уравнений Юла - Уокера, в котором появляется новое появление автоковариантности одного и того же запаздывания, заменяется несколько иной оценкой.

- Формулировка как расширенная форма обычной задачи прогнозирования методом наименьших квадратов. Здесь два набора прогнозных соотношений объединены в единую схему оценки и единый набор нормальных соотношений. Один набор представляет собой набор способов прямого прогнозирования, а другой - соответствующий набор способов обратного прогнозирования, относящихся к обратному представлению модели AR:

- Здесь прогнозируемые значения X t будут основаны на будущих значениях того же ряда. Этот способ оценки параметров AR разработан Бургом и называется методом Бурга: Бургом и более поздние авторы назвали эти оценки «оценками максимальными энтропии», но аргументация, лежащая в основе этого, применима к использованию любого набора оцененных параметров AR. По сравнению со схемой оценивания, используются только уравнения прогнозирования, производятся оценки разные автоковариации, и оценки разные свойства устойчивости. Оценки Бург, в частности, связаны с спектральной оценкой максимальной энтропии.

Другие возможные подходы к оценке включают в себя оценку максимальной правдоподобия. Доступны два варианта размера правдоподобия: в одном (в целом эквивалентном схеме наименьших квадратов прямого прогнозирования) рассматриваемая функция правдоподобия соответствует условному распределению более поздних значений в ряду при начальных значениях p в ряду; во втором случае функция правдоподобия соответствующая безусловному распределению всех значений в наблюдаемом ряду. Существующие ряды коротких подходов.

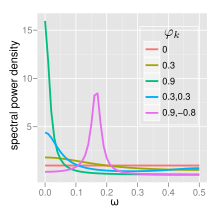

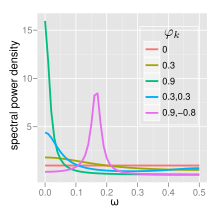

Спектр

спектральная плотность мощности (PSD) процесса AR (p) с дисперсией шума  is

is

AR (0)

Для белого шума (AR (0))

AR (1)

Для AR (1)

- Если

есть один спектральный пик при f = 0, часто называемый красный шум. По мере того, как

есть один спектральный пик при f = 0, часто называемый красный шум. По мере того, как  становится ближе к 1, появляется более высокая мощность на низких частотах, т. Е. Большие временные задержки.

становится ближе к 1, появляется более высокая мощность на низких частотах, т. Е. Большие временные задержки. - Если

, существует минимум при f = 0, часто называемый синим шумом, спектру света, все, кроме красного света, будет отфильтровано.

, существует минимум при f = 0, часто называемый синим шумом, спектру света, все, кроме красного света, будет отфильтровано.

AR (2)

AR (2) процессы можно разделить на три группы в зависимости от характеристик. также действует как фильтр верхних частот, все, кроме синего света, будет отфильтровано. их корней:

- Когда

, процесс имеет пару комплексно-сопряженных корней, создающих среднечастотный пик при:

, процесс имеет пару комплексно-сопряженных корней, создающих среднечастотный пик при:

В противном случае процесс имеет действительные корни и:

- Когда

он действует как фильтр нижних частот для белого шума со спектральным пиком при

он действует как фильтр нижних частот для белого шума со спектральным пиком при

- Когда

он действует как фильтр верхних частот для белого шума со спектральным пиком при

он действует как фильтр верхних частот для белого шума со спектральным пиком при  .

.

Процесс нестационарен, когда корни находятся вне единичной окружности. Процесс устойчиво, когда корни находятся внутри единого круга или, что эквивалентно, когда коэффициенты находятся в треугольнике  .

.

Полная функция PSD может быть выражена в вещественной форме как:

Реализации в статистических пакетах

- R, статистика пакета включает функцию ar.

- MATLAB Econometrics Toolbox и System Identification Toolbox включает модели авторегрессии

- Matlab и Octave : набор инструментов TSA содержит несколько функций оценки для одно-, многомерных и адаптивные модели авторегрессии.

- PyMC3 : структура байесовской статистики и вероятностного программирования поддерживает режимы авторегрессии с p-лагами.

- bayesloop поддерживает вывод параметров и выбор моделей для процесса AR-1 с изменяющимися во времени параметров.

- Python : реализовать в статистических моделях.

Импульсный отклик

Импульсный отклик системы - это изменение развивающейся в ответ на изменение значений шокового члена за k периодов ранее, как функция от k. Модель AR используется частным случаем модели векторной авторегрессии, здесь используется вычисление импульсной характеристики в векторной авторегрессии # импульсная характеристика.

n-шаговое прогнозирование

того, как параметры авторегрессии

были оценены, авторегрессия может быть назначена для прогнозирования произвольное количество периодов в будущем. Сначала используйте t для обозначения первого периода, по которому еще нет данных; замените известные предыдущие значения X ti вместо i = 1,..., p в уравнении авторегрессии при установке члена ошибки  равно нулю (потому что мы прогнозируем, что X t равно его ожидаемому значению, а ожидаемое значение ненаблюдаемого члена равно нулю). Результатом уравнения авторегрессии прогноз на первый ненаблюдаемый период. Затем используйте t для обозначения следующего периода. опять же, уравнение авторегрессии используется для составления прогноза, с одним отличием: значение X за период до текущего прогнозируемого неизвестно, поэтому вместо него используется его ожидаемое значение - прогнозируемое значение, полученное на предыдущем этапе прогнозирования.. Затем для будущих периодов используется та же процедура, каждый раз с использованием одного прогнозируемого значения в правой части прогнозного уравнения до тех пор, пока предсказанные значения не предсказываются из предыдущих шагов.

равно нулю (потому что мы прогнозируем, что X t равно его ожидаемому значению, а ожидаемое значение ненаблюдаемого члена равно нулю). Результатом уравнения авторегрессии прогноз на первый ненаблюдаемый период. Затем используйте t для обозначения следующего периода. опять же, уравнение авторегрессии используется для составления прогноза, с одним отличием: значение X за период до текущего прогнозируемого неизвестно, поэтому вместо него используется его ожидаемое значение - прогнозируемое значение, полученное на предыдущем этапе прогнозирования.. Затем для будущих периодов используется та же процедура, каждый раз с использованием одного прогнозируемого значения в правой части прогнозного уравнения до тех пор, пока предсказанные значения не предсказываются из предыдущих шагов.

Существует четыре неопределенности относительно прогнозов, полученного таким образом: (1) неопределенность относительно того, является ли авторегрессионная модель правильной моделью; (2) неопределенность относительно точности прогнозируемых значений, используемые в качестве запаздывающих значений в правой части уравнения авторегрессии; (3) неопределенность истинных значений коэффициентов авторегрессии; и (4) неопределенность в отношении значения члена  для прогнозируемого периода. Каждый из трех последних может быть определен количественно и объединен для расчета доверительного интервала для прогнозов на n шагов вперед; доверительный интервал будет становиться интервалом по мере увеличения n из-за использования все большего числа оценочных значений для числа с правой стороны.

для прогнозируемого периода. Каждый из трех последних может быть определен количественно и объединен для расчета доверительного интервала для прогнозов на n шагов вперед; доверительный интервал будет становиться интервалом по мере увеличения n из-за использования все большего числа оценочных значений для числа с правой стороны.

Оценка качества прогнозов

Прогностическая эффективность авторегрессионной модели может быть оценена, как только оценка будет выполнена, если используется перекрестная проверка. В этом подходе использовались некоторые из доступных для целей оценки параметров, а некоторые из возможных наблюдений позже в наборе данных были задержаны для тестирования вне выборки. В качестве альтернативы, по прошествии некоторого времени после того, как была проведена оценка параметров, станет доступным больше данных, и прогностическая характеристика может быть оценена с использованием новых данных.

В любом случае есть два аспекта прогнозной производительности, которые могут быть оценены: на один шаг вперед и на n шагов вперед. Для производительности на один шаг вперед оцененные параметры используются в уравнении авторегрессии вместе с наблюдаемыми значениями X для всех периодов, предшествующих прогнозируемому, и выходом уравнения является прогноз на один шаг вперед; эта процедура используется для получения прогнозов для каждого из наблюдений вне выборки. Чтобы оценить качество прогнозов на n шагов вперед, для получения прогнозов используется процедура прогнозирования, описанная в предыдущем разделе.

Учитывая набор прогнозируемых значений и соответствующий набор фактических значений для X для различных периодов времени, общий метод оценки заключается в использовании среднеквадратичной ошибки прогнозирования ; доступны и другие меры (см. прогнозирование # точность прогнозирования ).

Возникает вопрос, как интерпретировать измеренную точность прогноза - например, что такое «высокое» (плохое) или «низкое» (хорошее) значение для среднеквадратичной ошибки прогноза? Есть две возможные точки сравнения. Во-первых, точность прогнозирования альтернативной модели, оцененная при различных допущениях моделирования или различных методах оценки, может использоваться для целей сравнения. Во-вторых, показатель точности вне выборки можно сравнить с той же мерой, вычисленной для точек данных в выборке (которые использовались для оценки параметров), для которых доступно достаточно значений предшествующих данных (то есть отбрасывание первых p данных точки, для которых p предварительных данных недоступны). Поскольку модель была оценена специально для максимального соответствия точкам в выборке, обычно бывает так, что прогностическая эффективность вне выборки будет хуже, чем прогностическая эффективность внутри выборки. Но если качество прогнозирования ухудшается вне выборки на «не очень сильно» (что не поддается точному определению), то прогнозист может быть удовлетворен производительностью.

См. Также

Примечания

Ссылки

- Миллс, Теренс К. (1990). Методы временных рядов для экономистов. Cambridge University Press.

- Персиваль, Дональд Б.; Уолден, Эндрю Т. (1993). Спектральный анализ для физических приложений. Cambridge University Press.

- Pandit, Sudhakar M.; Ву, Шиен-Мин (1983). Временные ряды и системный анализ с приложениями. John Wiley Sons.

Внешние ссылки

![{\ displaystyle \ phi [B] X_ {t} = c + \ varepsilon _ {t} \,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b384dd193d1b8b0063a997d5a8d65434a7908880)

(см. стр. 88,90).

AR (0); AR (1) с параметром AR 0.3; AR (1) с параметром AR 0.9; AR (2) с строгими AR 0,3 и 0,3; и AR (2) включает AR 0,9 и -0,8

AR (0); AR (1) с параметром AR 0.3; AR (1) с параметром AR 0.9; AR (2) с строгими AR 0,3 и 0,3; и AR (2) включает AR 0,9 и -0,8

, где

, где  и

и  - это модельное среднее.

- это модельное среднее.

![{\ displaystyle \ operatorname {E} (X_ {t + n } | X_ {t}) = \ mu \ left [1- \ theta ^ {n} \ right] + X_ {t} \ theta ^ {n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/57e7ce545d36dfb0de17a55881ba8322e99955a5) и

и .

.

есть один спектральный пик при f = 0, часто называемый красный шум. По мере того, как

есть один спектральный пик при f = 0, часто называемый красный шум. По мере того, как  становится ближе к 1, появляется более высокая мощность на низких частотах, т. Е. Большие временные задержки.

становится ближе к 1, появляется более высокая мощность на низких частотах, т. Е. Большие временные задержки. , существует минимум при f = 0, часто называемый синим шумом, спектру света, все, кроме красного света, будет отфильтровано.

, существует минимум при f = 0, часто называемый синим шумом, спектру света, все, кроме красного света, будет отфильтровано.

, процесс имеет пару комплексно-сопряженных корней, создающих среднечастотный пик при:

, процесс имеет пару комплексно-сопряженных корней, создающих среднечастотный пик при:

он действует как фильтр нижних частот для белого шума со спектральным пиком при

он действует как фильтр нижних частот для белого шума со спектральным пиком при

он действует как фильтр верхних частот для белого шума со спектральным пиком при

он действует как фильтр верхних частот для белого шума со спектральным пиком при  .

.