В численном анализе, методах конечных разностей (FDM ) представляет собой класс численных методов для решения дифференциальных уравнений путем аппроксимации производных с помощью конечных разностей. Как пространственная область, так и временной интервал (если применимо) дискретизируются или разбиваются на конечное число шагов, и значение решения в этих дискретных точках аппроксимируется путем решения алгебраических уравнений, содержащих конечные разности и значения. из близлежащих точек.

Методы конечных разностей преобразуют обыкновенные дифференциальные уравнения (ODE) или уравнения в частных производных (PDE), которые могут быть нелинейными, в система линейных уравнений, которая может быть решена методами матричной алгебры. Современные компьютеры могут эффективно выполнять эти вычисления линейной алгебры, что, наряду с их относительной простотой реализации, привело к широкому использованию FDM в современном численном анализе. Сегодня FDM являются одним из наиболее распространенных подходов к численному решению PDE, наряду с методами конечных элементов.

Содержание

- 1 Вывод из полинома Тейлора

- 2 Точность и порядок

- 3 Пример: обыкновенное дифференциальное уравнение

- 4 Пример: уравнение теплопроводности

- 4.1 Явный метод

- 4.2 Неявный метод

- 4.3 Метод Кривошипа – Николсона

- 4.4 Сравнение

- 5 Пример: оператор Лапласа

- 5.1 Согласованность

- 5.2 Свойства

- 5.2.1 Субгармоника

- 5.2.2 Среднее значение

- 5.2.3 Принцип максимума

- 6 Метод SBP-SAT

- 7 См. Также

- 8 Ссылки

- 9 Дополнительная литература

- 9.1 Различные лекции и конспекты лекций

Вывод из полинома Тейлора

Во-первых, предположим, что функция, производные которой должны быть аппроксимированы, правильно ведет себя по теореме Тейлора, мы можем создать ряд Тейлора разложение

где n! обозначает факториал числа n, а R n (x) - это остаточный член, обозначающий разницу между многочленом Тейлора степени n и исходной функцией. Мы получим приближение для первой производной функции «f», сначала усекая многочлен Тейлора:

Настройка, x 0 = a имеем,

Деление поперек на h дает:

Решение относительно f '(a):

Предполагая, что  достаточно мало, аппроксимация первой производной от «f» равна:

достаточно мало, аппроксимация первой производной от «f» равна:

Это, не случайно, похоже на определение производной, которое дается как:

кроме предела к нулю ( метод назван в честь этого).

Точность и порядок

Погрешность решения метода определяется как разница между приближением и точным аналитическим решением. Двумя источниками ошибок в методах конечных разностей являются ошибка округления, потеря точности из-за компьютерного округления десятичных величин и ошибка усечения или ошибка дискретизации <269.>, разница между точным решением исходного дифференциального уравнения и точной величиной, предполагающей совершенную арифметику (то есть без округления).

Метод конечных разностей основан на дискретизации функции на сетке.

Чтобы использовать метод конечных разностей для аппроксимации решения проблемы, нужно сначала дискретизировать область задачи. Обычно это делается путем разделения домена на однородную сетку (см. Изображение справа). Это означает, что конечно-разностные методы производят наборы дискретных численных приближений производной, часто «ступенчато по времени».

Выражением общего интереса является ошибка локального усечения метода. Обычно выражается с использованием нотации Big-O, локальная ошибка усечения относится к ошибке из-за одного применения метода. То есть это величина  , если

, если  относится к точному значению, а

относится к точному значению, а  к числовому приближение. Остаточный член полинома Тейлора удобен для анализа локальной ошибки усечения. Используя форму Лагранжа остатка от полинома Тейлора для

к числовому приближение. Остаточный член полинома Тейлора удобен для анализа локальной ошибки усечения. Используя форму Лагранжа остатка от полинома Тейлора для  , что равно

, что равно

, где

, где

может быть обнаружен доминирующий член локальной ошибки усечения. Например, снова используя формулу прямой разности для первой производной, зная, что  ,

,

и с некоторыми алгебраическими манипуляциями это приводит к

и далее отмечая, что величина слева является приближением метода конечных разностей и что величина справа является точной величиной, представляющей интерес плюс остаток, ясно, что остаток - это локальная ошибка усечения. Окончательное выражение этого примера и его порядок:

Это означает что в этом случае локальная ошибка усечения пропорциональна размерам шага. Качество и продолжительность моделируемого решения FDM зависит от выбора уравнения дискретизации и размеров шага (временные и пространственные шаги). Качество данных и продолжительность моделирования значительно увеличиваются при меньшем размере шага. Следовательно, для практического использования необходим разумный баланс между качеством данных и продолжительностью моделирования. Большие временные шаги полезны для увеличения скорости моделирования на практике. Однако слишком большие временные шаги могут создать нестабильность и повлиять на качество данных.

Критерии фон Неймана и Куранта-Фридрихса-Леви часто используются для определения устойчивость численной модели.

Пример: обыкновенное дифференциальное уравнение

Например, рассмотрим обыкновенное дифференциальное уравнение

В методе Эйлера для решения этого уравнения используется коэффициент конечных разностей

, чтобы аппроксимировать дифференциальное уравнение, сначала подставив это для u '(x), затем применяя небольшую алгебру (умножая обе стороны на h, а затем добавляя u (x) к обеим сторонам), чтобы получить

Последнее уравнение является конечно-разностным уравнением, и решение этого уравнения дает приближенное решение дифференциальное уравнение.

Пример: уравнение теплопроводности

Рассмотрим нормализованное уравнение теплопроводности в одном измерении с однородными граничными условиями Дирихле

(граничное условие)

(граничное условие) (начальное условие)

(начальное условие)

Один из способов численного решения этого уравнения - аппроксимировать все производные конечными разностями. Разделим область в пространстве с помощью сетки  и во времени с использованием сетки

и во времени с использованием сетки  . Мы предполагаем однородное разделение как в пространстве, так и во времени, поэтому разница между двумя последовательными точками пространства будет h, а между двумя последовательными моментами времени будет k. Точки

. Мы предполагаем однородное разделение как в пространстве, так и во времени, поэтому разница между двумя последовательными точками пространства будет h, а между двумя последовательными моментами времени будет k. Точки

будут представлять численное приближение

Явный метод

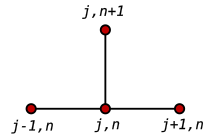

Шаблон для наиболее распространенного явного метода для уравнения теплопроводности.

Использование прямая разница в момент времени  и центральная разница второго порядка для пространственной производной в позиции

и центральная разница второго порядка для пространственной производной в позиции  (FTCS ) получаем рекуррентное уравнение:

(FTCS ) получаем рекуррентное уравнение:

Это явный метод для решения одномерного уравнение теплопроводности.

Мы можем получить  из других значений следующим образом:

из других значений следующим образом:

где

Итак, с этим рекуррентным соотношением и зная значения в момент времени n, можно получить соответствующие значения в момент времени n + 1.  и

и  должен должны быть заменены граничными условиями, в этом примере они оба равны 0.

должен должны быть заменены граничными условиями, в этом примере они оба равны 0.

Этот явный метод известен как численно устойчивый и сходящийся всякий раз, когда  . Численные ошибки пропорциональны шагу по времени и квадрату шага по пространству:

. Численные ошибки пропорциональны шагу по времени и квадрату шага по пространству:

Неявный метод

Шаблон неявного метода.

Если мы используем обратную разницу во время  и центральная разность второго порядка для пространственной производной в позиции

и центральная разность второго порядка для пространственной производной в позиции  (время назад, метод центрированного пространства "BTCS") получаем рекуррентное уравнение:

(время назад, метод центрированного пространства "BTCS") получаем рекуррентное уравнение:

Это неявный метод для решение одномерного уравнения теплопроводности.

Мы можем получить  из решения системы линейных уравнений:

из решения системы линейных уравнений:

Схема всегда численно устойчива и сходится, но обычно более трудоемкий в числовом отношении, чем явный метод, поскольку он требует решения системы численных уравнений на каждом временном шаге. Ошибки линейны по временному шагу и квадратичны по пространственному шагу:

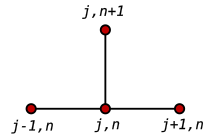

Метод Кривошипа – Николсона

Наконец, если мы используем центральную разность в момент времени  и центральная разность второго порядка для пространственной производной в позиции

и центральная разность второго порядка для пространственной производной в позиции  («CTCS») получаем рекуррентное уравнение:

(«CTCS») получаем рекуррентное уравнение:

Эта формула известен как метод Crank – Nicolson.

Шаблон Crank – Nicolson.

Мы можем получить  от решения системы линейных уравнений:

от решения системы линейных уравнений:

Схема всегда численно устойчива и сходящийся, но обычно более интенсивный в числовом отношении, поскольку требует решения системы числовых уравнений на каждом временном шаге. Ошибки квадратичны как по временному шагу, так и по пространственному шагу:

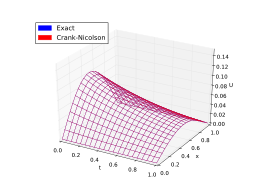

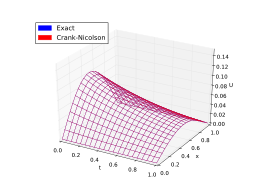

Сравнение

Подводя итог, обычно схема Кранка – Николсона является наиболее подходящей. четкая схема для малых временных шагов Для больших временных шагов неявная схема работает лучше, так как она менее требовательна к вычислениям. Явная схема является наименее точной и может быть нестабильной, но также является наиболее простой в реализации и наименее трудоемкой.

Вот пример. На рисунках ниже представлены решения, полученные с помощью вышеуказанных методов для аппроксимации уравнения теплопроводности

с граничным условием

Точное решение:

Сравнение методов конечных разностей

Явный метод (нестабильный)

Неявный метод (стабильный)

Метод Кранка-Николсона (стабильный)

Пример: оператор Лапласа

(непрерывный) оператор Лапласа в  -размеры задаются как

-размеры задаются как  . Дискретный оператор Лапласа

. Дискретный оператор Лапласа  зависит от размерности

зависит от размерности  .

.

В 1D оператор Лапласа аппроксимируется как

Это приближение обычно выражается с помощью следующего шаблона

и представляет собой симметричную трехдиагональную матрицу. Для равноудаленной сетки получается матрица Теплица.

. 2D-случай показывает все характеристики более общего nD-случая. Каждую вторую частную производную необходимо аппроксимировать аналогично одномерному случаю

, что является обычно задается следующим шаблоном

Согласованность

Согласованность вышеупомянутого приближения может быть продемонстрирована для очень регулярных функций, таких как  . Утверждение:

. Утверждение:

Чтобы доказать это, нужно заменить ряд Тейлора разложения до 3-го порядка в дискретный оператор Лапласа.

Свойства

Субгармоника

Подобно непрерывным субгармоническим функциям, можно определить субгармонические функции для конечно-разностных приближений

Среднее значение

Можно определить общий шаблон положительного типа через

<45 Если

<45 Если  является (дискретной) субгармонической, то выполняется следующее свойство среднего значения

является (дискретной) субгармонической, то выполняется следующее свойство среднего значения

где аппроксимация оценивается в точках сетки, и предполагается, что шаблон имеет положительный тип.

Аналогичное свойство среднего значения также выполняется для непрерывного случая.

Принцип максимума

Для (дискретного т. е. функция субгармоники  следующие утверждения:

следующие утверждения:

где  - дискретизации непрерывной области

- дискретизации непрерывной области  , соответственно граница

, соответственно граница  .

.

Аналогичный принцип максимума также выполняется для непрерывного случая.

Метод SBP-SAT

Метод SBP-SAT - это стабильный и точный метод дискретизации и наложения граничных условий корректного уравнения в частных производных с использованием конечных разностей высокого порядка. Метод основан на конечных разностях, где операторы дифференцирования проявляют свойства суммирования по частям. Обычно эти операторы состоят из матриц дифференцирования с центральными разностными шаблонами внутри с тщательно подобранными односторонними граничными шаблонами, предназначенными для имитации интеграции по частям в дискретной настройке. Используя метод SAT, граничные условия PDE накладываются слабо, когда граничные значения «подтягиваются» к желаемым условиям, а не точно выполняются. Если параметры настройки (присущие методике SAT) выбраны правильно, результирующая система ODE будет демонстрировать такое же энергетическое поведение, что и непрерывное PDE, то есть система не имеет роста нефизической энергии. Это гарантирует стабильность, если используется схема интегрирования с областью устойчивости, которая включает части мнимой оси, например метод Рунге-Кутта четвертого порядка. Это делает метод SAT привлекательным методом наложения граничных условий для методов конечных разностей более высокого порядка, в отличие, например, от метода впрыска, который обычно не будет устойчивым при использовании операторов дифференцирования высокого порядка.

См. Также

Ссылки

Дополнительная литература

- кВт Мортон и Д.Ф. Майерс, Численное решение уравнений с частными производными, Введение. Cambridge University Press, 2005.

- Аутар Кау и Э. Эрик Калу, Численные методы с приложениями, (2008) [1]. Содержит краткое инженерное введение в FDM (для ODE) в главе 08.07.

- Джон Стрикверда (2004). Конечно-разностные схемы и уравнения с частными производными (2-е изд.). СИАМ. ISBN 978-0-89871-639-9.

- Смит, Г.Д. (1985), Численное решение уравнений с частными производными: методы конечных разностей, 3-е изд., Oxford University Press

- Питер Олвер (2013). Введение в уравнения с частными производными. Springer. Глава 5: Конечные различия. ISBN 978-3-319-02099-0..

- Рэндалл Дж. Левек, Конечно-разностные методы для обыкновенных и дифференциальных уравнений с частными производными, SIAM, 2007.

Различные лекции и конспекты лекций

Метод конечных разностей основан на дискретизации функции на сетке.

Метод конечных разностей основан на дискретизации функции на сетке.

(граничное условие)

(граничное условие) (начальное условие)

(начальное условие)

Шаблон для наиболее распространенного явного метода для уравнения теплопроводности.

Шаблон для наиболее распространенного явного метода для уравнения теплопроводности.

Шаблон неявного метода.

Шаблон неявного метода.

Шаблон Crank – Nicolson.

Шаблон Crank – Nicolson.

Явный метод (нестабильный)

Явный метод (нестабильный)  Неявный метод (стабильный)

Неявный метод (стабильный)  Метод Кранка-Николсона (стабильный)

Метод Кранка-Николсона (стабильный)

<45 Если

<45 Если  является (дискретной) субгармонической, то выполняется следующее свойство среднего значения

является (дискретной) субгармонической, то выполняется следующее свойство среднего значения