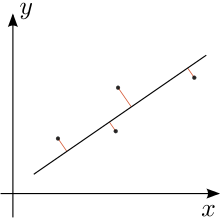

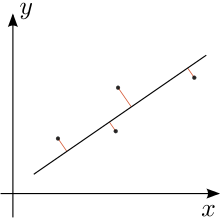

Регрессия Деминга. Красные линии показывают ошибку как по x, так и по y. Это отличается от традиционного метода наименьших квадратов, который измеряет ошибку параллельно оси y. Показанный случай с отклонениями, измеренными перпендикулярно, возникает, когда ошибки в x и y имеют одинаковую дисперсию.

В статистике, регрессия Деминга, названная в честь W. Эдвардс Деминг - это модель ошибок в переменных, которая пытается найти строку наилучшего соответствия для двумерного набора данных. Он отличается от простой линейной регрессии тем, что учитывает ошибки в наблюдениях как по оси x, так и по оси y. Это частный случай общих наименьших квадратов, который позволяет использовать любое количество предикторов и более сложную структуру ошибок.

Регрессия Деминга эквивалентна оценке максимального правдоподобия модели ошибок в переменных, в которой ошибки для двух переменных считаются независимыми и нормально распределенные, и отношение их дисперсий, обозначенное δ, известно. На практике это соотношение можно оценить из соответствующих источников данных; однако процедура регрессии не учитывает возможные ошибки при оценке этого отношения.

Регрессия Деминга лишь немного сложнее вычислить по сравнению с простой линейной регрессией. Большинство пакетов статистических программ, используемых в клинической химии, предлагают регрессию Деминга.

Модель была первоначально введена Адкоком (1878), который рассматривал случай δ = 1, а затем в более общем плане Куммеллом (1879) с произвольным δ. Однако их идеи оставались в основном незамеченными более 50 лет, пока не были возрождены Купмансом (1937), а затем еще больше распространены Демингом (1943). Последняя книга стала настолько популярной в клинической химии и смежных областях, что метод был даже назван регрессией Деминга в этих областях.

Содержание

- 1 Спецификация

- 2 Решение

- 3 Ортогональная регрессия

- 4 См. Также

- 5 Примечания

- 6 Ссылки

Спецификация

Предположим, что доступные данные (y i, x i) - измеренные наблюдения «истинных» значений (y i *, x i *), которые лежат на линии регрессии:

где ошибки ε и η независимы, и предполагается, что отношение их дисперсий известно:

На практике дисперсия  и

и  параметры часто неизвестны, что усложняет оценку

параметры часто неизвестны, что усложняет оценку  . Обратите внимание, что если метод измерения для

. Обратите внимание, что если метод измерения для  и

и  одинаков, эти отклонения, вероятно, будут равны, так что

одинаков, эти отклонения, вероятно, будут равны, так что  для этого случая.

для этого случая.

Мы стремимся найти линию «наилучшего соответствия»

такой, что взвешенная сумма квадратов остатков модели минимизирована:

Полный вывод см. в Jensen (2007).

Решение

Решение может быть выражено в терминах выборочных моментов второй степени. То есть сначала мы вычисляем следующие величины (все суммы идут от i = 1 до n):

Наконец, оценки параметров модели методом наименьших квадратов будут

Ортогональная регрессия

Для случая равенства дисперсии ошибок, то есть когда  , регрессия Деминга становится ортогональной регрессией: она минимизирует сумму квадратов перпендикулярных расстояний от точек данных до линия регрессии. В этом случае обозначьте каждое наблюдение как точку z j на комплексной плоскости (т. Е. Точка (x j, y j) записывается как z j = x j + iy j, где i - мнимая единица ). Обозначьте как Z сумму квадратов разностей точек данных от центроида (также обозначенного в комплексных координатах), который является точкой, горизонтальное и вертикальное положение которой являются средними значениями точек данных. Тогда:

, регрессия Деминга становится ортогональной регрессией: она минимизирует сумму квадратов перпендикулярных расстояний от точек данных до линия регрессии. В этом случае обозначьте каждое наблюдение как точку z j на комплексной плоскости (т. Е. Точка (x j, y j) записывается как z j = x j + iy j, где i - мнимая единица ). Обозначьте как Z сумму квадратов разностей точек данных от центроида (также обозначенного в комплексных координатах), который является точкой, горизонтальное и вертикальное положение которой являются средними значениями точек данных. Тогда:

- Если Z = 0, то каждая линия, проходящая через центроид, является линией наилучшего ортогонального соответствия [это неверно - возьмите прямоугольник с центром в начале координат, представляющий четыре точки данных и выровненный по горизонтальной и вертикальной осям. Если ширина больше высоты, тогда ось x подходит лучше, чем ось y].

- Если Z ≠ 0, ортогональная линия регрессии проходит через центроид и параллельна вектору от начала до

.

.

A тригонометрическое представление линии ортогональной регрессии было дано Кулиджем в 1913 году.

Application

В в случае трех неколлинеарных точек на плоскости, треугольник с этими точками в качестве вершин имеет уникальный эллипс Штейнера, то есть касательные к сторонам треугольника в их серединах. Основная ось этого эллипса приходится на ортогональную линию регрессии для трех вершин.

См. Также

Примечания

Ссылки

- Adcock, RJ (1878). «Проблема наименьших квадратов». Аналитик. Анналы математики. 5 (2): 53–54. DOI : 10.2307 / 2635758. JSTOR 2635758. CS1 maint: ref = harv (ссылка )

- Кулидж, Дж. Л. (1913). «Два геометрических приложения математики наименьших квадратов». The American Mathematical Monthly. 20(6): 187–190. doi : 10.2307 / 2973072. CS1 maint: ref = harv (ссылка )

- Корнблит, П.Дж.; Гочман, Н. (1979). «Неправильные коэффициенты регрессии методом наименьших квадратов». Clin. Chem. 25 (3): 432–438. PMID 262186. CS1 maint: ref = harv (link )

- Deming, WE (1943). Статистическая корректировка данных. Wiley, NY (Dover Publications edition, 1985).). ISBN 0-486-64685-8. CS1 maint: ref = harv (link )

- Fuller, Wayne A. (1987). Измерение модели ошибок. John Wiley Sons, Inc. ISBN 0-471-86187-1. CS1 maint: ref = harv (link )

- Glaister, P. (2001). «Снова о наименьших квадратах». The Mathematical Gazette. 85: 104–107. doi : 10.2307 / 3620485. CS1 maint: ref = harv (link )

- Дженсен, Андерс Кристиан (200 7). «Регрессия Деминга, пакет MethComp» (PDF). CS1 maint: ref = harv (ссылка )

- Koopmans, TC (1937). Анализ линейной регрессии экономических временных рядов. DeErven Ф. Бон, Харлем, Нидерланды. CS1 maint: ref = harv (ссылка )

- Kummell, CH (1879). «Редукция уравнений наблюдения, которые содержат более одной наблюдаемой величины». Аналитик. Анналы математики. 6 (4): 97–105. doi : 10.2307 / 2635646. JSTOR 2635646. CS1 maint: ref = harv (ссылка )

- Linnet, K. (1993). «Оценка регрессионных процедур для сравнительных исследований методов». Clinical Chemistry. 39 (3): 424–432. PMID 8448852. CS1 maint: ref = harv (ссылка )

- Минда, Д. ; Phelps, S. (2008). «Треугольники, эллипсы и кубические многочлены» (PDF). American Mathematical Monthly. 115 (8): 679 –689. MR 2456092. CS1 maint: ref = harv (ссылка )

Регрессия Деминга. Красные линии показывают ошибку как по x, так и по y. Это отличается от традиционного метода наименьших квадратов, который измеряет ошибку параллельно оси y. Показанный случай с отклонениями, измеренными перпендикулярно, возникает, когда ошибки в x и y имеют одинаковую дисперсию.

Регрессия Деминга. Красные линии показывают ошибку как по x, так и по y. Это отличается от традиционного метода наименьших квадратов, который измеряет ошибку параллельно оси y. Показанный случай с отклонениями, измеренными перпендикулярно, возникает, когда ошибки в x и y имеют одинаковую дисперсию.

.

.