A самоорганизующаяся карта (SOM ) или самоорганизующаяся карта характеристик (SOFM ) - это тип искусственной нейронной сети (ANN), которая обучается с использованием неконтролируемого обучения для создания низкоразмерное (обычно двумерное) дискретное представление входного пространства обучающих выборок, называемое картой, и поэтому является методом уменьшения размерности. Самоорганизующиеся карты отличаются от других искусственных нейронных сетей, поскольку они применяют конкурентное обучение в отличие от обучения с исправлением ошибок (например, обратное распространение с градиентным спуском ) и в том смысле, что они используют функцию соседства для сохранения топологических свойств входного пространства.

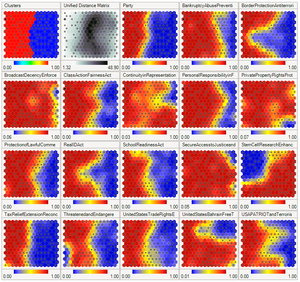

Самоорганизующаяся карта с изображением США. Конгресс схемы голосования. Входными данными была таблица со строкой для каждого члена Конгресса и столбцами для определенных голосов, содержащими голоса каждого члена «да» / «нет» / «воздержался». Алгоритм SOM расположил эти элементы в двумерной сетке, расположив аналогичные элементы ближе друг к другу. Первый график показывает группировку, когда данные разделены на два кластера. Второй график показывает среднее расстояние до соседей: большие расстояния темнее. Третий сюжет предсказывает членство в партии республиканцев (красный) или демократов (синий). На остальных графиках каждая наложена на результирующую карту с прогнозируемыми значениями во входном измерении: красный цвет означает прогнозируемое голосование «да» по этому законопроекту, синий означает голосование «нет». График был создан в Synapse.

Самоорганизующаяся карта с изображением США. Конгресс схемы голосования. Входными данными была таблица со строкой для каждого члена Конгресса и столбцами для определенных голосов, содержащими голоса каждого члена «да» / «нет» / «воздержался». Алгоритм SOM расположил эти элементы в двумерной сетке, расположив аналогичные элементы ближе друг к другу. Первый график показывает группировку, когда данные разделены на два кластера. Второй график показывает среднее расстояние до соседей: большие расстояния темнее. Третий сюжет предсказывает членство в партии республиканцев (красный) или демократов (синий). На остальных графиках каждая наложена на результирующую карту с прогнозируемыми значениями во входном измерении: красный цвет означает прогнозируемое голосование «да» по этому законопроекту, синий означает голосование «нет». График был создан в Synapse.. Это делает SOM полезными для визуализации за счет создания низкоразмерных представлений многомерных данных, сродни многомерному масштабированию. Искусственная нейронная сеть, представленная финским профессором Теуво Кохоненом в 1980-х годах, иногда называется картой Кохонена или сетью . Сеть Кохонена представляет собой удобную в вычислительном отношении абстракцию, основанную на биологических моделях нейронных систем 1970-х годов и моделях морфогенеза, восходящих к Алану Тьюрингу в 1950-х.

Хотя это Типично рассматривать этот тип сетевой структуры как относящуюся к сетям прямого распространения, где узлы визуализируются как подключенные, этот тип архитектуры принципиально отличается по расположению и мотивации.

Полезные расширения включают использование тороидальных сеток, в которых соединяются противоположные края, и использование большого количества узлов.

Также часто используется U-матрица. Значение U-матрицы конкретного узла - это среднее расстояние между вектором веса узла и его ближайшими соседями. В квадратной сетке, например, могут рассматриваться ближайшие 4 или 8 узлов (окрестности фон Неймана и Мура соответственно) или шесть узлов в гексагональной сетке.

Большие SOM отображают эмерджентные свойства. В картах, состоящих из тысяч узлов, можно выполнять кластерные операции на самой карте.

Как и большинство искусственных нейронных сетей, SOM работают в двух режимах: обучение и отображение. «Обучение» строит карту с использованием примеров ввода (конкурентный процесс, также называемый векторным квантованием ), тогда как «отображение» автоматически классифицирует новый входной вектор.

Видимая часть самоорганизующейся карты - это пространство карты, которое состоит из компонентов, называемых узлами или нейронами. Пространство карты определяется заранее, обычно как конечная двумерная область, где узлы расположены в регулярной шестиугольной или прямоугольной сетке. Каждый узел связан с вектором «веса», который является позицией во входном пространстве; то есть он имеет ту же размерность, что и каждый входной вектор. Пока узлы в пространстве карты остаются фиксированными, обучение заключается в перемещении векторов весов к входным данным (уменьшение метрики расстояния) без нарушения топологии, созданной из пространства карты. Таким образом, самоорганизующаяся карта описывает отображение из входного пространства более высокого измерения в пространство карты более низкого измерения. После обучения карта может классифицировать вектор из входного пространства, найдя узел с ближайшим (с наименьшей метрикой расстояния) весовым вектором к вектору входного пространства.

Цель обучения на самоорганизующейся карте - заставить разные части сети одинаково реагировать на определенные входные шаблоны. Частично это вызвано тем, как зрительная, слуховая или другая сенсорная информация обрабатывается в отдельных частях коры головного мозга в человеческом мозге.

. Иллюстрация тренировки самоорганизующаяся карта. Голубая капля - это распределение обучающих данных, а маленький белый диск - текущие обучающие данные, взятые из этого распределения. Сначала (слева) узлы SOM произвольно располагаются в пространстве данных. Выбирается ближайший к обучающей базе узел (выделен желтым). Он перемещается к обучающей базе данных, поскольку (в меньшей степени) является ее соседями по сетке. После многих итераций сетка имеет тенденцию аппроксимировать распределение данных (справа).

. Иллюстрация тренировки самоорганизующаяся карта. Голубая капля - это распределение обучающих данных, а маленький белый диск - текущие обучающие данные, взятые из этого распределения. Сначала (слева) узлы SOM произвольно располагаются в пространстве данных. Выбирается ближайший к обучающей базе узел (выделен желтым). Он перемещается к обучающей базе данных, поскольку (в меньшей степени) является ее соседями по сетке. После многих итераций сетка имеет тенденцию аппроксимировать распределение данных (справа). Веса нейронов инициализируются либо небольшими случайными значениями, либо выбираются равномерно из подпространства, охватываемого двумя самыми большими главными компонентами собственные векторы. При использовании последнего варианта обучение происходит намного быстрее, потому что начальные веса уже дают хорошее приближение к весам SOM.

В сеть необходимо подавать большое количество примеров векторов, которые представляют, насколько это возможно, типы векторы, ожидаемые во время картирования. Примеры обычно вводятся несколько раз в виде итераций.

В обучении используется соревновательное обучение. Когда обучающий пример подается в сеть, вычисляется его евклидово расстояние до всех весовых векторов. Нейрон, весовой вектор которого наиболее похож на входной, называется единицей наилучшего согласования (BMU). Веса BMU и близких к нему нейронов в сетке SOM корректируются по входному вектору. Величина изменения уменьшается со временем и по мере удаления от BMU сетки. Формула обновления для нейрона v с вектором весов Wv(s):

,

,где s - индекс шага, t - индекс обучающей выборки, u - индекс BMU для входного вектора D (t), α (s) - монотонно убывающий коэффициент обучения; Θ (u, v, s) - функция соседства, которая дает расстояние между нейроном u и нейроном v на шаге s. В зависимости от реализаций t может систематически сканировать набор обучающих данных (t равно 0, 1, 2... T-1, затем повторять, T - размер обучающей выборки), случайным образом извлекаться из набора данных (Самостоятельная выборка ) или реализовать какой-либо другой метод выборки (например, складной нож ).

Функция соседства Θ (u, v, s) (также называемая функцией бокового взаимодействия) зависит от расстояния сетки между BMU (нейроном u) и нейроном v. В простейшей форме это 1 для всех нейронов, достаточно близких к BMU и 0 для других, но функции Gaussian и mexican-hat также являются обычным выбором. Независимо от функциональной формы, функция соседства сжимается со временем. Вначале, когда окружение велико, самоорганизация происходит в глобальном масштабе. Когда соседство сократилось до пары нейронов, веса сходятся к локальным оценкам. В некоторых реализациях коэффициент обучения α и функция соседства Θ неуклонно уменьшаются с увеличением s, в других (в частности, в тех, где t сканирует набор обучающих данных) они уменьшаются пошагово, один раз каждые T шагов.

Процесс обучения SOM на двумерном наборе данных

Процесс обучения SOM на двумерном наборе данных Этот процесс повторяется для каждого входного вектора в течение (обычно большого) количества циклов λ . В итоге сеть связывает выходные узлы с группами или шаблонами во входном наборе данных. Если эти шаблоны могут быть названы, имена могут быть присоединены к связанным узлам в обученной сети.

Во время отображения будет один единственный нейрон-победитель: нейрон, весовой вектор которого находится ближе всего к входному вектору. Это можно просто определить, вычислив евклидово расстояние между входным вектором и вектором весов.

Несмотря на то, что в этой статье было подчеркнуто представление входных данных в виде векторов, любой вид объекта, который может быть представлен в цифровом виде, с которым связана соответствующая мера расстояния и в котором возможны необходимые операции для обучения, может использоваться для построения самоорганизующейся карты. Сюда входят матрицы, непрерывные функции или даже другие самоорганизующиеся карты.

Это необходимые переменные, векторы выделены жирным шрифтом,

- текущая итерация

- текущая итерация - предел итераций

- предел итераций - индекс вектора целевых входных данных во входном наборе данных

- индекс вектора целевых входных данных во входном наборе данных

- целевой вектор входных данных.

- целевой вектор входных данных. - индекс узла на карте

- индекс узла на карте - это текущий весовой вектор узла

- это текущий весовой вектор узла

- это индекс единицы наилучшего соответствия (BMU) на карте

- это индекс единицы наилучшего соответствия (BMU) на карте - ограничение из-за расстояния от BMU, обычно называемое функцией соседства, а

- ограничение из-за расстояния от BMU, обычно называемое функцией соседства, а - ограничение обучения из-за по ходу итерации.

- ограничение обучения из-за по ходу итерации.

и повторите с шага 2, пока

и повторите с шага 2, пока

вариант алгоритма :

и повторите, начиная с шага 2, пока

и повторите, начиная с шага 2, пока

Выбор хорошего начального приближения является известная проблема для всех итерационных методов обучения нейронных сетей. Кохонен использовал случайное инициирование весов SOM. В последнее время инициализация главного компонента, при которой начальные веса карты выбираются из пространства первых главных компонентов, стала популярной благодаря точной воспроизводимости результатов.

Тщательное сравнение подхода случайного инициирования с главным компонентом Инициализация для одномерных SOM (моделей главных кривых) показала, что преимущества инициализации SOM главных компонентов не универсальны. Лучший способ инициализации зависит от геометрии конкретного набора данных. Инициализация главного компонента предпочтительнее (в измерении один), если главная кривая, аппроксимирующая набор данных, может быть однолистно и линейно спроецирована на первый главный компонент (квазилинейные множества). Однако для нелинейных наборов данных случайное инициирование работает лучше.

Рассмотрим массив узлов размером n × m, каждый из которых содержит вектор весов и знает о своем местоположении в массиве. Каждый весовой вектор имеет ту же размерность, что и входной вектор узла. Первоначально веса могут быть установлены на случайные значения.

Теперь нам нужен ввод для подачи карты. Цвета могут быть представлены их красными, зелеными и синими компонентами. Следовательно, мы будем представлять цвета как векторы в единичном кубе свободного векторного пространства над ℝ, созданном базисом :

Показанная диаграмма

Самоорганизующиеся карты (SOM) трех и восьми цветов с U-Matrix.

Самоорганизующиеся карты (SOM) трех и восьми цветов с U-Matrix. сравнивает результаты обучения на наборах данных

и исходные изображения. Обратите внимание на поразительное сходство между ними.

Точно так же после обучения сетки нейронов 40 × 40 для 250 итераций со скоростью обучения 0,1 на Ирис Фишера карта уже может обнаружить основные различия между видами.

Самоорганизующаяся карта (SOM) набора данных о цветках ириса Фишера с U-матрицей. Вверху слева: цветное изображение, образованное первыми тремя измерениями четырехмерных весовых векторов SOM. Вверху справа: псевдоцветное изображение величины весовых векторов SOM. Внизу слева: U-матрица (евклидово расстояние между весовыми векторами соседних ячеек) SOM. Внизу справа: наложение точек данных (красный: I. setosa, зеленый: I. versicolor и синий: I. virginica) на U-матрицу на основе минимального евклидова расстояния между векторами данных и векторами веса SOM.

Самоорганизующаяся карта (SOM) набора данных о цветках ириса Фишера с U-матрицей. Вверху слева: цветное изображение, образованное первыми тремя измерениями четырехмерных весовых векторов SOM. Вверху справа: псевдоцветное изображение величины весовых векторов SOM. Внизу слева: U-матрица (евклидово расстояние между весовыми векторами соседних ячеек) SOM. Внизу справа: наложение точек данных (красный: I. setosa, зеленый: I. versicolor и синий: I. virginica) на U-матрицу на основе минимального евклидова расстояния между векторами данных и векторами веса SOM.  Картографическое представление самоорганизующейся карты (U-Matrix ) на основе данных из избранных статей Википедии (частота слов). Расстояние обратно пропорционально сходству. «Горы» - это грани между кластерами. Красные линии - это ссылки между статьями.

Картографическое представление самоорганизующейся карты (U-Matrix ) на основе данных из избранных статей Википедии (частота слов). Расстояние обратно пропорционально сходству. «Горы» - это грани между кластерами. Красные линии - это ссылки между статьями.  Одномерный SOM в сравнении с анализом главных компонентов (PCA) для аппроксимации данных. SOM - красная ломаная линия с квадратами, 20 узлов. Первый главный компонент представлен синей линией. Точки данных - это маленькие серые кружки. Для PCA доля необъяснимой дисперсии в этом примере составляет 23,23%, для SOM - 6,86%.

Одномерный SOM в сравнении с анализом главных компонентов (PCA) для аппроксимации данных. SOM - красная ломаная линия с квадратами, 20 узлов. Первый главный компонент представлен синей линией. Точки данных - это маленькие серые кружки. Для PCA доля необъяснимой дисперсии в этом примере составляет 23,23%, для SOM - 6,86%. Есть два способа интерпретации SOM. Поскольку в фазе обучения веса всего окружения перемещаются в одном направлении, похожие предметы имеют тенденцию возбуждать соседние нейроны. Таким образом, SOM формирует семантическую карту, где похожие образцы отображаются близко друг к другу, а несходные - отдельно. Это можно визуализировать с помощью U-матрицы (евклидово расстояние между векторами весов соседних ячеек) SOM.

Другой способ - рассматривать веса нейронов как указатели на входное пространство.. Они образуют дискретную аппроксимацию распределения обучающих выборок. Больше нейронов указывает на области с высокой концентрацией обучающей выборки и меньше нейронов, где выборок мало.

SOM можно рассматривать как нелинейное обобщение анализа главных компонентов (PCA). Было показано, используя как искусственные, так и реальные геофизические данные, что SOM имеет много преимуществ по сравнению с традиционными методами извлечения признаков, такими как эмпирические ортогональные функции (EOF) или PCA.

Первоначально SOM не был сформулирован как решение проблемы оптимизации. Тем не менее, было несколько попыток изменить определение SOM и сформулировать проблему оптимизации, которая дает аналогичные результаты. Например, эластичные карты используют механическую метафору эластичности для аппроксимации главных многообразий : аналогия - эластичная мембрана и пластина.

| На Викискладе есть материалы, связанные с Самоорганизующимися картами. |