Статистический вывод можно рассматривать как теорию азартных игр, применяемую к окружающему нас миру. Множество приложений для логарифмических показателей информации точно подсказывают нам, как сделать наилучшее предположение перед лицом неполной информации. В этом смысле теория информации может считаться формальным выражением теории азартных игр. Поэтому неудивительно, что теория информации имеет приложения к азартным играм.

Ставки Келли или пропорциональные ставки - это приложение От теории информации до инвестирования и азартных игр. Его первооткрывателем был Джон Ларри Келли-младший..

Часть идеи Келли заключалось в том, чтобы игрок максимизировал математическое ожидание логарифма своего капитала, а не ожидаемую прибыль от каждой ставки. Это важно, так как в последнем случае человек будет вынужден поставить все, что у него есть, когда ему будет предложена выгодная ставка, а если он проиграет, у него не будет капитала для последующих ставок. Келли понял, что это логарифм капитала игрока, который складывается в последовательных ставках и «к которому применяется закон больших чисел».

A бит - это количество энтропии в событии с таблицей ставок с двумя возможными исходами и четными коэффициентами. Очевидно, мы могли бы удвоить наши деньги, если бы знали заранее, каков будет исход этого события. Келли пришел к выводу, что независимо от того, насколько сложен сценарий ставок, мы можем использовать оптимальную стратегию ставок, называемую критерием Келли, чтобы наши деньги расти экспоненциально с любой дополнительной информацией, которую мы можем получить. Значение этой «незаконной» дополнительной информации измеряется как взаимная информация относительно результата события, на которое можно сделать ставку:

где Y - дополнительная информация, X - результат события, на которое можно сделать ставку, а I - состояние знаний букмекера. Это среднее расхождение Кульбака – Лейблера, или информационный выигрыш, для апостериорного распределения вероятностей X при значении Y относительно априорного распределения. или заявленные шансы на X. Обратите внимание, что ожидание берется за Y, а не за X: нам нужно оценить, насколько точна в долгосрочной перспективе наша дополнительная информация Y, прежде чем мы начнем делать ставки реальными деньгами на X. Это простой применение байесовского вывода. Обратите внимание, что дополнительная информация Y может повлиять не только на наши знания о событии X, но и на само событие. Например, Y может означать лошадь, у которой слишком много овса или недостаточно воды. Та же самая математика применима и в этом случае, потому что с точки зрения букмекера, случайные фиксации гонок уже учитываются, когда он рассчитывает свои коэффициенты.

Природа дополнительной информации чрезвычайно привередлива. Мы уже видели, что это может повлиять на фактическое событие, а также на наши знания о результате. Предположим, у нас есть информатор, который сообщает нам, что определенная лошадь собирается победить. Мы, конечно, не хотим ставить все наши деньги на эту лошадь только на слух: этот информатор может делать ставку на другую лошадь и, возможно, распространяет слухи только для того, чтобы самому получить лучшие шансы. Вместо этого, как мы указали, нам необходимо оценить нашу дополнительную информацию в долгосрочной перспективе, чтобы увидеть, как она соотносится с результатами гонок. Таким образом, мы можем точно определить, насколько надежен наш информатор, и сделать ставки именно так, чтобы максимизировать ожидаемый логарифм нашего капитала в соответствии с критерием Келли. Даже если наш информатор лжет нам, мы все равно можем извлечь выгоду из его лжи, если сможем найти некоторую обратную корреляцию между его подсказками и фактическими результатами гонки.

Коэффициент удвоения при игре в азартные игры на скачках равен

![{\ displaystyle W (b, p) = \ mathbb {E} [\ log _ {2} S (X)] = \ sum _ {i = 1} ^ {m} p_ {i } \ log _ {2} b_ {i} o_ {i}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7709e5610bd7a212201e0e6ff5219ed4468515bd)

где есть

, для которого

где

Существует важное, но простое соотношение между количеством дополнительная информация, которую получает игрок, и ожидаемый экспоненциальный рост его капитала (Келли):

для оптимальной стратегии ставок, где

Это уравнение было первым применением теории информации Шеннона за пределами ее преобладающей парадигмы передачи данных (Пирс).

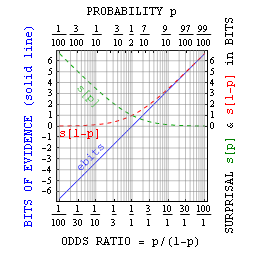

Неожиданность и свидетельство в битах, как логарифмические меры вероятности и шансов соответственно.

Неожиданность и свидетельство в битах, как логарифмические меры вероятности и шансов соответственно. Логарифмическая вероятностная мера самоинформация или неожиданность, среднее значение которой информационная энтропия / неопределенность, средняя разность которой составляет KL-дивергенция, сама по себе имеет приложения для анализа вероятностей. Две его основные сильные стороны заключаются в том, что неожиданности: (i) уменьшают мизерные вероятности до числа управляемого размера, и (ii) добавляют всякий раз, когда вероятности умножаются.

Например, можно сказать, что «количество состояний равно двум количеству битов», т.е. #states = 2. Здесь величина, измеряемая в битах, является логарифмической мерой информации, упомянутой выше. Следовательно, выпадение всех орлов после первого подбрасывания N монет вызывает N неожиданностей.

Аддитивная природа сюрпризов и способность почувствовать их значение с помощью горстки монет могут помочь поместить невероятные события (например, выигрыш в лотерею или несчастный случай) в контекст. Например, если один из 17 миллионов билетов является победителем, то неожиданность выигрыша от одного случайного выбора составляет около 24 бит. Несколько раз бросив 24 монеты, вы почувствуете сюрприз, когда все решится с первого раза.

Аддитивный характер этой меры также пригодится при взвешивании альтернатив. Например, представьте, что неожиданность вреда от вакцинации составляет 20 бит. Если неожиданность выявления болезни без вакцинации составляет 16 бит, но неожиданность вреда от болезни, если вы ее поймаете, составляет 2 бита, тогда неожиданность вреда от НЕ получения вакцинации составляет всего 16 + 2 = 18 бит. Независимо от того, решите вы пройти вакцинацию или нет (например, денежные затраты на ее оплату не включены в это обсуждение), вы можете, по крайней мере, принять на себя ответственность за решение, основанное на том, что отказ от вакцинации требует большего, чем немного дополнительного риска.

В более общем смысле, можно связать вероятность p с битами неожиданных sbit как вероятность = 1/2. Как было предложено выше, это в основном полезно с малыми вероятностями. Однако Джейнс указал, что с помощью утверждений истина-ложь можно также определить биты доказательств ebits как неожиданность против минус неожиданность за. Это свидетельство в битах относится просто к отношению шансов = p / (1-p) = 2 и имеет преимущества, аналогичные преимуществам самой самоинформации.

Теорию информации можно рассматривать как способ количественной оценки информации, чтобы принять лучшее решение перед лицом несовершенной информации. То есть как принять наилучшее решение, используя только имеющуюся у вас информацию. Смысл ставок состоит в том, чтобы рационально оценить все соответствующие переменные неопределенной игры / расы / матча, затем сравнить их с оценками букмекерской конторы, которые обычно представлены в форме коэффициентов или спредов, и сделать правильную ставку, если оценки существенно различаются. Сфера азартных игр, где это используется больше всего, - это ставки на спорт. Спортивные увечья очень хорошо поддаются теории информации из-за доступности статистики. В течение многих лет известные экономисты проверяли различные математические теории, используя спорт в качестве лаборатории, с очень разными результатами.

Согласно одной из теорий ставок на спорт, это случайное блуждание. Случайное блуждание - это сценарий, при котором новая информация, цены и доходность будут колебаться случайно, это часть гипотезы эффективного рынка. Основное убеждение в гипотезе эффективного рынка состоит в том, что рынок всегда будет вносить корректировки в соответствии с любой новой информацией. Следовательно, никто не может превзойти рынок, потому что он торгует на той же информации, на которой рынок корректировался. Однако, по мнению Фамы, для создания эффективного рынка необходимо соблюдение трех качеств:

Статистики показали, что это третье условие, позволяющее использовать теорию информации в борьбе с физическими недостатками в спорте. Когда все не согласны с тем, как информация повлияет на исход события, мы получаем разные мнения.