Синтез речи - это искусственное воспроизведение речи. Компьютерная система, используемая для этой цели, называется речевым компьютером или синтезатором речи и может быть реализована в программном мощном или аппаратном мощном. Система преобразования текста в речь (TTS ) преобразует текст на нормальном языке в речь; другие системы преобразуют символические лингвистические представления, например фонетические транскрипции в речь.

Синтезированная речь может быть создана объединением частей записанной, которые хранятся в базе данных . Системы различаются размером хранимых речевых Система, в которой хранятся телефоны или дифоны, обеспечивает самый большой диапазон выходов, но может не иметь четкости. Для использования определенных методов использования целых слов или предложений высококачественный вывод. В качестве альтернативы, синтезатор может быть модель речевого тракта и другие характеристики человеческого голоса для создания полностью «синтетического» речевого вывода.

Качество синтезатора речи оценивается по его сходству человеческому голосу и его способности быть понятным. Понятная программа преобразования текста в речь позволяет людям с нарушениями зрения или нарушениями чтения слушать написанные слова на домашнемнем. Многие компьютерные операционные системы включают синтезаторы речи с начала 1990-х годов.

Обзор типичной системы TTS

Обзор типичной системы TTS Система преобразования текста в речь (или «движок») состоит из двух частей: внешнего интерфейса и справка внутреннего интерфейса. Передняя часть имеет две основные задачи. Во-первых, он преобразует исходный текст, используемые символы, такие как числа и сокращения, в эквивалент написан. Этот процесс часто называют нормализацией текста, предварительной обработкой или токенизацией. Затем интерфейсная часть назначает фонетические транскрипции каждому слову, делит и помечает текст на просодические единицы, например фразы, предложения, и предложения. Процесс присвоения слов фонетической транскрипции называется преобразованием текста в фонему или графемы в фонемы. Фонетическая транскрипция и просодическая информация вместе составляют символическое лингвистическое представление, которое выводится во внешнем интерфейсе. Серверная часть - часто называемая синтезатором - затем преобразует символическое лингвистическое представление в звук. В некоторых системах эта часть включает вычисление просодии (контур высоты тона, длительности фонем), которая затем накладывается на выходную речь.

Задолго до изобретения электронной обработки сигналов некоторые люди пытались создать машины, имитирующие человеческую речь. Некоторые ранние легенды о существовании «Медных голов » касались Папы Сильвестра II (ум. 1003 г. н.э.), Альберта Великого (1198–1280) и Роджер Бэкон (1214–1294).

В 1779 году немецкий - датский ученый Кристиан Готлиб Кратценштейн выиграл первый приз в конкурсе, объявленном Российской Императорской Академией. наук и искусств для построенных им моделей человеческого голосового тракта, способных воспроизводить пять длинных гласных звуков (в записи : [aː], [ eː], [iː], [oː] и [uː]). Затем последовала управляемая мехами «акустико-механическая речевая машина » Вольфганг фон Кемпелен из Прессбург, Венгрия,анный в статье 1791 года. Эта машина добавила модели языка и губ, что позволяет ему воспроизводить согласные, а также гласные. В 1837 году Чарльз Уитстон изготовил «говорящую машину» по проекту Кемпелена, а в 1846 году Йозеф Фабер представил «Euphonia ». В 1923 году Пэджет воскресил дизайн Уитстона.

В 1930-х годах Bell Labs разработала вокодер, который автоматически анализировал речь на ее основные тона и резонансы. На основе своей работы над вокодером Гомер Дадли разработал синтезатор голоса с клавишным управлением под названием The Voder (Голосовой демонстратор), который он выставил на Всемирной выставке в Нью-Йорке в 1939 году. году..

Доктор Франклин С. Купер и его коллеги из Haskins Laboratories создали паттерн воспроизведения в конце 1940-х и завершили его в 1950 году. Было несколько различных версий этого аппаратного устройства; в настоящее время выживает только один. Машина преобразует изображения акустических моделей речи в виде спектрограммы обратно в звук. Используя это устройство, Элвин Либерман и его коллеги представили акустические сигналы для восприятия фонетических сегментов (согласных и гласных).

Корпус компьютера и синтезатора речи, использованный Стивеном Хокингом в 1999

Корпус компьютера и синтезатора речи, использованный Стивеном Хокингом в 1999 Первые компьютерные системы синтеза речи возникли в конце 1950-х годов. Норико Умеда и др. разработал первую систему преобразования текста в 1968 году в Электротехнической лаборатории в Японии. В 1961 году физик Джон Ларри Келли-младший и его коллега Луи Герстман использовали компьютер IBM 704 для речи, что стало одним из самых значительных событий в истории. из Белл Лабс. Синтезатор диктофона Келли (вокодер ) воссоздал песню «Дейзи Белл » с музыкальным сопровождением от Макса Мэтьюза. По совпадению Артур Кларк навещал своего друга и коллегу Джона Пирса в лаборатории Bell Labs в Мюррей-Хилле. Кларк был впечатлен демонстрацией, что использовал ее в кульминационной сцене своей сценария для своего романа 2001: Космическая одиссея, где компьютер HAL 9000 поет ту же песню, что и астронавт. Дэйв Боумен усыпляет его. Несмотря на успех электронного синтезатора речи, продолжаются.

Линейное прогнозирующее кодирование (LPC), форма кодирования речи, началось с разработки Фумитада Итакура из Университета Нагоя и Сюдзо Сайто из Nippon Telegraph and Telephone (NTT) в 1966 году. Дальнейшие разработки в технологии LPC были сделаны Бишну С. Атал и Манфред Р. Шредер в Bell Labs в 1970-е годы. Позднее LPC используется для первого микросхем синтезатора речи, таких как Texas Instruments LPC Speech Chips, используется в Speak Spell игрушках 1978 года.

В 1975 году, Фумитада Итакура разработал метод спектральных пар линий (LSP) для кодирования речи с высокой степенью сжатия, когда работал в NTT. С 1975 по 1981 год Итакура изучал проблемы анализа и синтеза речи на основе метода LSP. В 1980 году его команда разработала микросхему синтезатора речи на основе LSP. LSP - важная технология для синтеза и кодирования речи, принятая в 1990-х годах почти всеми стандартми кодирования речи в качестве важного компонента, способствующего расширению цифрового речевой связи по мобильным каналам и Интернету.

В 1975 году была выпущена MUSA, которая стала одной из первых систем синтеза речи. Он состоял из автономного компьютерного оборудования и специального программного обеспечения, позволяющего читать по-итальянски. Вторая версия, выпущенная в 1978 году, также могла петь по-итальянски в стиле «а капелла».

Демонстрационная запись DECtalk с использованием голосов Perfect Paul и Uppity UrsulaДоминирующими системами в 1980-х и 1990-х годах была система DECtalk, основанная в основном на работе Денниса Клатта в Массачусетский технологический институт и система Bell Labs; последняя была одной из первых из многоязычных систем, не зависящих от языка, которая широко использовалась методами обработки естественного языка.

Портативная электроника с синтезатором речи начала появляться в 1970-х годах. Одним из первых был портативный калькулятор Telesensory Systems Inc. (TSI) Speech + для слепых в 1976 году. Другие устройства предназначались в первую очередь для образовательных целей, например, игрушка Speak Spell производства компании Texas Instruments в 1978 году. Fidelity выпустила говорящую версию своего электронного шахматного компьютера в 1979 году. Первой видеоигрой с синтезом речи была 1980 стрелялка аркадная игра, Stratovox (известная в Японии как Speak Rescue), от Сан Электроникс. Первой компьютерной игрой с синтезом речи была Manbiki Shoujo (Девушка в магазине), выпущенная в 1980 году для PET 2001, для этого разработчик игры, Хироши Судзуки, разработал метод программирования «нулевого пересечения» для создания синтезированной речевой волны. Другой ранний пример, аркадная версия Berzerk, также датируется 1980 годом. Milton Bradley Company выпустила первую многопользовательскую электронную игру с использованием использования голоса Милтон, в том же году.

Ранние электронные синтезаторы речи казались роботизированными и часто были различимы. Качество синтезированной речи неуклонно улучшилось, но по состоянию на 2016 год результаты современного системного синтеза речи по-прежнему отличаются от реальной речи.

Синтезированные голоса обычно казались мужскими до 1990 года, когда Энн Сирдал из ATT Bell Laboratories создала женский голос.

Курцвейл предсказал в 2005 году что, благодаря соотношению цены и качества удалось добиться, что синтезаторы речи стали дешевле и доступнее, больше людей выиграют от использования программ преобразования текста в речь.

Наиболее важными качествами системы синтеза речи являются естественность и разборчивость..Естественность, насколько результат звучит как человеческая речь, а разборчивость - это легкость, с которой вывод понимается. Идеальный синтезатор речи одновременно естественен и разборчив. Системы синтеза речи обычно стараются максимизировать обе характеристики.

Двумя вызывает технологию генерации сигналов синтетической речи являются каскадным синтезом и формантным синтезом. У нас есть сильные и слабые методы использования каждой системы, обычно определяет, какой подход будет работать.

Конкатенационный синтез основан на конкатенации (или соединении вместе) сегментов записанной речи. Как правило, конкатенативный синтез обеспечивает наиболее естественное звучание синтезированной речи. Однако различия между естественными вариациями речи и природой автоматических методов сегментации сигналов иногда приводят к слышимым сбоям на выходе. Есть три основных подтипа конкатенативного синтеза.

Синтез выбора блока большие базы данных записанной речи. Во время создания базы данных записанное высказанное сегментируется на некоторые или все из следующих: отдельные телефоны, дифоны, полутона, слоги, морфемы., слов, фраз и предложений. Как правило, разделение на сегменты выполняется с использованием специально модифицированного распознавателя речи, установленного в режиме «принудительного выравнивания» с некоторой ручной коррекцией, с использованием визуальных представлений, таких как форма волны и спектрограмма. Затем создается индекс в речевой базе данных на основе сегментации и акустических параметров, таких как основная частота (высота ), длительность, положение в слог и соседние телефоны. В время выполнения желаемое целевое предложение создается путем определения наилучшей цепочки кандидатов из базы данных (выбор единицы). Этот процесс обычно достигается с помощью специально взвешенного решений.

. Выбор блока обеспечивает максимальную естественность, поскольку он применяет лишь небольшую часть цифровой обработки сигнала (DSP) к записанной речи. DSP часто делает записанный речевой звук естественным, хотя некоторые системы используют небольшую обработку сигнала в точке конкатенации для сглаживания формы волны. Результат работы лучших систем выбора часто неотличим от настоящих голосов, особенно в тех контекстах, которые были настроены системой TTS. Однако для достижения максимальной естественности обычно требуется, чтобы базы данных речи были установлены очень большими, в некоторых системах представлены в пределах гигабайт записанных данных, десятки часов речи. Кроме того, известны алгоритмы выбора единиц измерения для выбора сегментов из места, которое приводит к неидеальному синтезу (например, второстепенные становятся нечеткими), даже если в базе данных есть лучший выбор. Недавно исследователи предложили автоматические методы обнаружения сегментов в системе речи с выбором.

Дифонный синтез использует минимальную речевую базу данных, содержащую все дифоны (переходы звука в звук), происходящие на языке. Количество дифонов зависит от фонотактики языка: например, на испанском языке около 800 дифонов, а на немецком языке - около 2500. При синтезе дифонов в речевой базе данных содержится только один пример каждого дифона. Во время выполнения целевая просодия предложения накладывается на эти минимальные единицы с помощью методов обработки цифрового сигнала, таких как кодирование с линейным предсказанием, PSOLA или MBROLA. или более современные методы, такие как изменение основного тона в исходной области с использованием дискретного косинусного преобразования. Синтез дифонов страдает от звуковых сбоев конкатенативного синтеза и роботизированного звука формантного синтеза, и имеет несколько преимуществ любого подхода, кроме небольшого размера. Таким образом, сообщество местных приложений, сокращается, общенационально, общение. Ранним примером синтеза дифонов является обучающий робот leachim, который был изобретен Майклом Дж. Фрименом. Личим содержит информацию о школьной программе и технические биографические данные о 40 учениках, которые он был запрограммирован обучать. Он был протестирован в классе четвертого класса в Бронксе, Нью-Йорк.

Доменно-специфический синтез объединяет заранее записанные слова и фразы для создания полных высказываний. Он используется в приложениях, выводимых системой, ограничен областью, например, объявления о расписании движения транспорта или сводки погоды. Эта технология очень проста для реализации и уже давно используется в коммерческих устройствах, как говорящие часы и калькуляторы. Уровень естественности этих систем может быть очень высоким, потому что различные типы предложений ограничены, и они близко соответствуют просодии и интонации оригинальных записей.

эти системы ограничены словами и фразами в своих базах данных, они не являются универсальными и могут синтезировать только те комбинации слов и фраз. Однако смешение слов в естественной речи может вызывать проблемы, если не принимать во внимание множество вариантов. Например, в неротических диалектах английского языка буква «r» в словах типа «clear» / ˈklɪə / обычно произносится только тогда, когда следующее слово имеет гласную в первой букве (например, «clear out» реализуется как / ˌKlɪəɹˈʌʊt /). Точно так же в французском многие конечные согласные больше не становятся беззвучными, если за ними следует слово, начинающееся с гласной, эффект, называемый liaison. Это чередование не может быть воспроизведено с помощью простой системы конкатенации слов, которая потребовала бы дополнительной сложности, чтобы быть контекстно-зависимой.

Синтез формант не использует человеческую речь образцы во время выполнения. Вместо этого синтезированный речевой вывод создается с использованием аддитивного синтеза и акустической модели (синтез физического моделирования ). Такие параметры, как уровни основной частоты, голоса и шума, изменяются со временем для создания формы сигнала искусственной речи. Этот метод иногда называют синтезом на основе правил; однако многие конкатенативные системы также имеют компоненты, основанные на правилах. Многие системы, основанные на технологии формантного синтеза, генерируют искусственную, звучащую как робот речь, которую никогда нельзя принять за человеческую. Однако максимальная естественность не всегда является целью системы синтеза речи, и системы синтеза формант имеют преимущества перед системами конкатенации. Синтезированная формантой речь может быть надежно разборчивой даже на очень высоких скоростях, что позволяет избежать акустических сбоев, которые обычно мешают конкатенативным системам. Высокоскоростная синтезированная речь используется слабовидящими для быстрой навигации по компьютеру с помощью программы чтения с экрана . Формантные синтезаторы обычно представляют собой программы меньшего размера, чем конкатенативные системы, потому что у них нет базы данных речевых образцов. Поэтому они могут использоваться во встроенных системах, где память и мощность микропроцессора особенно ограничены. Поскольку системы на основе формант полностью контролируют все аспекты выходной речи, можно выводить самые разные просодии и интонации, передавая не только вопросы и утверждения, но и различные эмоции и тона голоса.

Примеры высокоточного контроля интонации не в реальном времени в синтезе формант включают работу, проделанную в конце 1970-х годов для Texas Instruments игрушки Speak Spell, и в начале 1980-х годов Sega аркадных машин и во многих аркадных играх Atari, Inc., использующих TMS5220 LPC Chips. Создание правильной интонации для этих проектов было кропотливым, и результаты еще не были сопоставлены с интерфейсами преобразования текста в речь в реальном времени.

Артикуляционный синтез относится к вычислительнымметодам синтез речи, основанная на моделях голосового тракта человека и происходящих в нем артикуляционных процессов. Первый артикуляционный синтезатор, используемый для лабораторных экспериментов, был разработан в Haskins Laboratories в середине 1970-х годов Филипом Рубином, Томом Бэром и Полом Мермельштейном. Этот синтезатор, известный как ASY, основан на моделях речевого тракта, разработанных в Bell Laboratories в 1960-х и 1970-х годах Полом Мермельштейном, Сесилом Кокером и его коллегами.

До недавнего времени модели артикуляционного синтеза были включены в коммерческие системы синтеза речи. Заметным исключением система на основе NeXT, используемая и проданная Trillium Sound Research, дочерней компанией Университета Калгари, где была проведена большая часть оригинальных исследований. После прекращения существования различных воплощений NeXT (начатых Стивом Джобсом в конце 1980-х и слился с Apple Computer в 1997 году) программное обеспечение Trillium было опубликовано под стандартной общественной лицензией GNU, и работа продолжалась как гнуспич. Система, появившаяся на рынке в 1994 году, обеспечивает полное преобразование текста на основе артикуляции с использованием модели или аналога линии передачи орального и носового трактова человека, контролируемого «моделью отличительной области» Карре.

Более современные синтезаторы, разработанные Хорхе К. Лусеро и его коллегами, включают модели биомеханики голосовых складок, аэродинамики голосовой щели и распространение акустических волн в бронхах, трахеях, носовой и ротовой полостях и, таким образом, предоставляют себя полные системы физики.

Синтез на основе HMM - это метод синтеза, основанный на скрытых марковских моделях, также называемый статистическим параметрическим синтезом. В этой системе частотный спектр (голосовой тракт ), основная частота (источник голоса) и продолжительность (просодия ) речи моделируются одновременно с помощью ХММ. Речевые сигналы генерируются из самих HMM на основе критерия верхнего правдоподобия.

Синтезатор синусоидального сигнала - это метод синтеза речи путем замены форманты (основные энергетические полосы) со свистами чистого тона.

Учитывая входной текст или некоторую последовательность лингвистической единицы

, где

Обычно входной текст сначала передается в генератор акустических характеристик, а затем акустические характеристики передаются в нейронный вокодер. Для генератора акустических характеристик функция потерь обычно представляет собой потери L1 или L2. Эти функции потерь накладывают ограничение на то, что выходные акустические распределения характеристик должны быть гауссовскими или лапласовскими. На практике, поскольку диапазон человеческого голоса находится в диапазоне от 300 до 4000 Гц, функция потерь будет рассчитана на большее наказание в этом диапазоне:

где

В сентябре 2016 года DeepMind предложила WaveNet, глубокую генеративную модель необработанных звуковых сигналов. Это показывает сообществу, что модели, основанные на глубоком обучении, могут моделировать необработанные формы сигналов и хорошо работать при генерации речи из акустических функций, таких как спектрограммы или спектрограммы в мел-шкале, или даже из некоторых обработанных лингвистических функций. В начале 2017 года Мила (научно-исследовательский институт) предложила char2wav, модель для получения необработанной формы сигнала сквозным методом. Кроме того, Google и Facebook предложили Tacotron и VoiceLoop соответственно для создания акустических характеристик из непосредственно вводимого текста. Позднее в том же году Google использует Tacotron2, который объединил вокодер WaveNet с пересмотренной архитектурой Tacotron для выполнения непрерывного воспроизведения речи. Tacotron2 может генерировать высококачественную речь, приближающуюся к человеческому голосу. Многие исследователи во всем мире начинают замечать мощь сквозного синтезатора речи.

Преимущества сквозных методов одна заключаются в следующем:

Несмотря на многие упомянутые преимущества, сквозные методы по-прежнему имеют много проблем предстоит решить:

- Медленно проблема вывода

Чтобы решить проблему медленного вывода, Microsoft исследование и В обоих исследованийх Baidu предлагалось использовать неавторегрессивные модели, чтобы ускорить процесс вывода. Модель FastSpeech, предложенная Microsoft, использует мощность проекта Transformer с моделью продолжительности для достижения цели. Кроме того, модель продолжительности, заимствованная из методов, делает производство речи более устойчивым.

- Проблема устойчивости

Исследователи обнаружили, что проблема устойчивости связана с ошибками выравнивания текста, и это побуждает многих исследователей рассмотреть механизм внимания, который использует сильную локальную связь и монотонные свойства речи.

- Задача управляемости

Для решения управляемой проблемы предлагается много работ по вариационному автокодировщику.

- Задача плоской просодии

GST-Tacotron может немного облегчить проблему плоской просодии, однако все равно зависит от обучения данных.

- Проблема сглаженной акустической мощности

Для создания более реалистичных акустических характеристик можно применить стратегию обучения GAN.

Однако на практике нейронный вокодер может обобщать, даже когда входные характеристики более гладкие, чем реальные данные.

В настоящее время самостоятельному обучению уделяется много внимания из-за лучшего использования немаркированных данных. Исследования, что с помощью самоконтрольной потери сопротивления в парных данных уменьшаются.

Адаптация динамика с нулевым выстрелом является многообещающей, потому что одна модель может генерировать речь с различными стилями и характеристиками говорящих. В июне 2018 года Google предложила использовать обученную модель говорящего в качестве кодировщика динамика для извлечения встраивания говорящего. Затем кодировщик динамика становится частью нейронной модели преобразования текста в речь, и он может определять стиль и выходные характеристики речи. Это показывает сообществу, что возможно использование только одной модели для создания речи, состоящей из нескольких стилей.

Нейронный вокодер играет роль в синтезе речи на основе глубокого обучения для генерации высококачественной речи на основе акустических характеристик. Модель WaveNet, предложенная в 2016 году, обеспечивает отличные показатели качества речи. Wavenet разложил на множители совместную вероятность формы волны

где

Процесс нормализации текста редко бывает общим. Тексты заполнены гетеронимами, числами и сокращениями, которые требуют расширения в фонетическом представлении. В английском есть много вариантов написания, которые произносятся по-разному в зависимости от контекста. Например, «Мой последний проект - научиться лучше проецировать свой голос» содержит два варианта произношения «проект».

Большинство систем преобразования текста в речи (TTS) не генерируют семантических представлений своих входных текстов, поскольку процессы для этого ненадежны, плохо понятны и неэффективны с точки зрения вычислений. В результате используются различные эвристические методы , чтобы угадать правильный способ устранения неоднозначности омографов, например изучение соседних слов и использование статистики о частоте появления.

Недавно системы TTS начали использовать HMM (обсуждаемые выше) для генерации «частей речи », чтобы помочь в устранении неоднозначности омографов. Эта техника весьма успешна во многих случаях, например, следует ли произносить слово «прочитанное» как «красный», подразумевая прошедшее время, или как «тростник», подразумевая настоящее время. Типичная частота ошибок при использовании HMM таким образом обычно ниже пяти процентов. Эти методы также хорошо работают для большинства европейских языков, хотя доступ к необходимому обучению корпусу на этих языках часто затруднен.

Выбор способа преобразования чисел - еще одна проблема, которую необходимо решить системам TTS. Преобразовать число в слова (по крайней мере, на английском языке) - это простая задача программирования, например, «1325» превращается в «одну тысячу триста двадцать пять». Однако числа встречаются в самых разных контекстах; «1325» также можно читать как «один, три два, пять», «тринадцать двадцать пять» или «тринадцатьсот двадцать пять». Система TTS часто может сделать вывод, как расширить число, на основе окружающих слов, чисел и знаков препинания, а иногда система предоставляет способ указать контекст, если он неоднозначен. Римские цифры также могут читаться по-разному в зависимости от контекста. Например, «Генрих VIII» читается как «Генрих Восьмой», а «Глава VIII» читается как «Глава восьмая».

Точно так же сокращения могут быть неоднозначными. Например, аббревиатуру «in» для «дюймов» следует отличать от слова «in» и адреса «12 St John St. использует одну и ту же аббревиатуру для слов «Святой» и «Улица». Системы TTS с интеллектуальными интерфейсами могут делать обоснованные предположения о двусмысленных аббревиатурах, в то время как другие обеспечивают одинаковый результат во всех случаях, что приводит к бессмысленным (а иногда и комичным) выводам, таким как "Ulysses S. Grant ". как «Улисс Саут Грант».

Системы синтеза речи используют два основных подхода для определения произношения слова, основанное на его написании, процесс, который часто называют преобразованием текста в фонему или графемы -в фонемы (фонема - это термин, используемый лингвисты для описания отличительных звуков на языке ). Самый простой подход к преобразованию текста в фонемы - это на основе словаря, когда программа поддерживает большой словарь, поддерживает все слова и их правильные произношения. Определение правильного произношения каждого слова - это поиск каждого слова в конкретном слове. Другой подход основан на правилах, в которых произношения используются правила к словам, чтобы определить их произношение на основе их написания. Это похоже на подход к обучению чтению «зондированием» или синтетической фоникой.

У каждого подхода есть свои преимущества и недостатки. Подход, основанный на словарях, является быстрым и точным, совершенно не работает, если ему дают слово, которого нет в его работе. По мере роста размера словаря растут и требования к объему памяти системы синтеза. С другой стороны, система учитывает неправильное написание или произношение. (Учтите, что слово «of» очень распространено на английском языке, но это единственное слово, в котором буква «f» произносится [v].) В результате почти все системы воспроизведения используют комбинацию этих подходов.

Языки с фонематической орфографией имеют очень регулярную систему письма, имеют предсказание произношения слов на основе их написания довольно успешное. Системы правил речи для таких языков широко используют метод, основанный на тех немногих словах, как иностранные и за именаимствования, произношение которых не очевидно из их написания. С другой стороны, синтезатора речи для таких языков, как английский, которые имеют крайне нерегулярную систему правописания, с большей вероятностью полагаются на словари и используют основанные на своих словарях правила только для необычных слов или слов, которые в своих словарях.

Последовательная оценка речи Системы могут быть трудными из-за отсутствия общепринятых объективных критериев оценки. В разных организациях часто используются разные речевые данные. Качество системного синтеза речи также зависит от качества производственной техники, аналоговой или цифровой записи и средств, используемых для воспроизведения речи. Поэтому оценка системного синтеза речи часто затруднялась из-за различных методов производства и воспроизведения.

Однако с 2005 года некоторые исследователи начали оценивать системы синтеза речи, используя общий набор речевых данных.

Исследование в журнале Speech Communication, Эми Драхота и ее коллеги из Университета Портсмута, UK сообщили, что слушатели голосовых сообщений смогли с большей вероятностью определить, улыбается ли ли ли говорящий или нет. Было высказано предположение, что определение голосовых характеристик, которые сигнализируют об эмоциональном содержании, может быть использовано для того, чтобы сделать синтезированную речь более естественной. Одной из связанных проблем является изменение контура основного тона предложения, в зависимости от того, является ли оно утвердительным, вопросительным или восклицательным предложением. Один из методов модификации основного тона использует дискретное косинусное преобразование в исходной области (линейное предсказание остаток). Такие методы синхронной модификации основного тона требуют априорной маркировки основного тона базы данных синтезированной речи с использованием таких методов, как извлечение эпохи с использованием динамического индекса взрыв, применяемого к интегрированному остатку линейного предсказания вокализованных 547>

Популярные системы, предлагающие синтез речи в качестве встроенных возможностей.

Mattel Intellivision игровой консоль предлагала модуль Intellivoice Он включил в себя микросхему синтезатора речи SP0256 Рассказчик на съемном картридже для хранения базы данных общих слов, можно было комбинировать для создания фраз в играх. Intellivision. Микросхема устройства устройства Оратор также может принимать речевые данные из внешней памяти, любые дополнительные слова или фразы, необходимые для этого, храниться внутри самого картриджа. Данные состояли из аналогового фильтра для изменения поведения синтетической модели голосового тракта чипа, а не из простых оцифрованных образцов.

Также выпущенная в 1982 году, Software Automatic Mouth была первой коммерческой полностью программной программой для синтеза голоса. Позже он был использован в основе для Macintalk. Эта программа доступна для компьютеров Apple, отличных от Macintosh (включая Apple II и Lisa), различных моделей Atari и Commodore 64. Версия Apple предпочитает дополнительное оборудование, существее ЦАП, хотя вместо нее она использует однобитный звук компьютера. вывод (с добавлением сильных искажений), если карты не было. Atari использовала встроенный аудиочип POKEY. Воспроизведение речи на Atari обычно отключает запрос прерывания и выключает чип ANTIC во время вывода голоса. Слышимый звук - это ужасенная искаженная речь, когда экран включен. Commodore 64 использовал встроенный звуковой чип SID 64.

Возможно, первая речевой системой, интегрированной в операционная система, были персональные компьютеры 1400XL / 1450XL, разработанные Atari, Inc. с использованием чипа Votrax SC01 в 1983 году. В компьютерех 1400XL / 1450XL использовался конечный автомат для преобразования текста в речь World English Spelling. К сожалению, персональные компьютеры 1400XL / 1450XL не поставлялись в больших количествах.

Компьютеры Atari ST продавались с «stspeech.tos» на гибких дисках.

Первой речевой системой, интегрированной в операционную систему, которая поставлялась в количестве, была Apple Computer MacInTalk. Программное обеспечение было лицензировано сторонними разработчиками Джозефом Кацем и Марком Бартоном (позже SoftVoice, Inc.) использовалось во время выпуска компьютеров Macintosh в 1984 году. Эта январская демонстрация потребовала 512 килобайт оперативной памяти. В результате он не мог работать в 128 килобайтах оперативной памяти, на основе фактически получился первый Mac. Итак, демонстрация была выполнена на прототипе Mac 512k, хотя присутствующим об этом не сказали, и демонстрация вызвала значительный ажиотаж для Macintosh. В начале 1990-х Apple расширила свои возможности, предложив общесистемную поддержку преобразования текста в речь. С появлением более быстрых компьютеров на базе PowerPC они включили более качественную выборку голоса. Apple также внедрила распознавание речи в свои системы, которые обеспечивают гибкий набор команд. Совсем недавно Apple добавила голоса на основе семплов. Из любопытства речевая система Apple Macintosh превратилась в полностью поддерживаемую программу PlainTalk для людей с проблемами зрения. VoiceOver был представлен впервые в 2005 году в Mac OS X Tiger (10.4). В 10.4 (Tiger) и первые выпусках 10.5 (Leopard ) в Mac OS X поставлена только одна стандартная голосовая связь. Начиная с 10.6 (Snow Leopard ), пользователь мог выбирать из широкого списка голосов. Голоса VoiceOver обеспечивает хорошее дыхание между предложениями, а также улучшенную четкость при высокой скорости чтения по сравнению с PlainTalk. Mac OS X также включает приложение административной строки, которое преобразует текст в звуковую речь. Стандартные дополнения AppleScript включают глагол, который позволяет сценарию использовать любые из голосов и управлять высотой тона, скоростью речи и модуляцией произносимого текста.

Операционная система Apple iOS, используемая на iPhone, iPad и iPod Touch, использует синтез речи VoiceOver для обеспечения доступности. Некоторые сторонние приложения также используют синтезатор речи для облегчения навигации, чтения веб-страниц или перевода текста.

Используется в Alexa и как Программное обеспечение как услуга в AWS (с 2017 г.).

Вторая система с расширенными возможностями синтеза речи была AmigaOS, представленная в 1985 году. Голос синтезирован был лицензирован Commodore International от SoftVoice, Inc., который также разработал оригинальную систему преобразования текста в речь MacinTalk. В нем была реализована полная система имитации голоса для американского английского, мужскими и женскими голосами и маркерами "стресс", что стало возможным благодаря аудио чипсету Amiga. Система синтеза была разделена на библиотеку переводчика, которая преобразовывала неограниченный английский текст в стандартный набор фонетических кодов, которое реализовало формантную модель генерации речи. AmigaOS также имел высокоуровневый обработчик речи Speak Handler ", что другим программным строкам перенаправлять вывод текста в речь. Синтез речи иногда использовался в сторонних программах, особенно в текстовых процессорах и образовательном программном продукте.

Несмотря на ограничение американского английского языка, была неофициальная версия с многоязычным синтезом речи, в конечном итоге удалила поддержку синтезатора речи из AmigaOS 2.1.

Современная Windows настольные системы могут использовать компоненты SAPI 4, которая могла переводить на несколько языков с учетом набора правил для каждого языка. и SAPI 5 для поддержки речи речи и распознавания речи. нительное дополнение для Windows 95 и Windows 98. Windows 2000 добавила Экранный диктор, программа преобразования текста в речь для людей с нарушениями зрения. Сторонние программы, такие как JAWS для Windows, Window-Eyes, Non-visual Desktop Access, Supernova и System Access, могут выполнять различные задачи преобразования текста в речь, такие как чтение текста вслух с веб-сайта, учетной записи электронной почты, текстового документа, Буфер обмена Windows, набор текста с клавиатуры пользователя и т. Д. Не все программы напрямую использовать синтез речи. Некоторые программы могут использовать плагины, расширения или надстройки для чтения текста вслух. Доступны сторонние программы, умеющие читать текст из системного буфера обмена.

Microsoft Speech Server - это серверный пакет для синтеза и распознавания голоса. Он разработан для использования в сети с веб-приложениями и колл-центрами.

В начале 1980-х годов TI была известна как пионер в синтезе речи, и для TI-99/4 и 4A был доступен очень популярный подключаемый модуль синтезатора речи. Синтезаторы речи предлагались бесплатно при покупке ряда картриджей и использовались для многих видеоиграх, написанных TI (известные названия, предлагаемые с речью во время акции, были Alpiner и Parsec ). Синтезатор использует вариант кодирования с линейным предсказанием и имеет небольшой встроенный словарь. Первоначальное намерение состояло в том, чтобы выпустить небольшие картриджи, которые подключаются к блоку синтезатора, что увеличило бы встроенный словарный запасное устройство. Однако успех преобразования программного текста в картридже Terminal Emulator II отменил этот план.

Преобразование текста в речи (TTS ) относится к способности компьютеров читать текст вслух. TTS Engine преобразует письменный текст в фонематическое представление, а затем преобразует фонематическое представление в формы волны, которые могут выводить как звук. Механизмы TTS с различными языками, диалектами и специализированными словарями доступны у сторонних издателей.

Версия 1.6 для Android добавлена поддержка синтеза речи (TTS).

В настоящее время существует ряд приложений, плагинов и гаджетов, которые могут читать непосредственно сообщения из клиент электронной почты и веб-страницы из веб-сайтов или инструментов панели Google. Некоторые специализированные программы могут озвучивать RSS-потоки. С одной стороны, упрощают доставку информации, позволяя пользователям свои любимые источники новостей и преобразовывать их в подкасты. С другой стороны, он-лайн RSS-ридеры доступны практически на любом ПК, подключенном к Интернету. Пользователи могут загружать сгенерированные аудиофайлы на портативные устройства, например с помощью приемника подкастов и слушайте их во время прогулки, бега трусцой или по дороге на работу.

Растущей сферой в TTS на базе Интернета Интернет-технология вспомогательных технологий, например, 'Browsealoud' от британской компании и Readspeaker. Он может функциональность TTS любого (по функциям доступности, удобства, развлечения или информации), имеющему доступ к веб-браузеру. некоммерческий проект Pediaphon был создан в 2006 году для предоставления веб-интерфейса TTS, аналогичного Википедии.

. Другая работа ведется в контексте W3C через W3C Audio Incubator Group при участии BBC и Google Inc.

Некоторые открытые исходные коды доступны программные системы, такие как:

С появлением в 2016 году Adobe Voco прототип программного обеспечения для редактирования и генерации звука, который должен стать частью Adobe Creative Suite и аналогичноенного DeepMind WaveNet, программное обеспечение для синтеза звука на основе глубокой нейронной сети от Google синтез речи практически неотличим от голоса настоящего человека.

Adobe Voco занимает примерно 20 минут речи желаемого объекта, после чего может генерировать звукоподобный голос даже с фонемами, которых не было в. Программное обеспечение создает этические проблемы, поскольку позволяет украсть голоса других людей и манипулировать ими, чтобы все люди, что угодно.

На конференции 2018 г. по системам обработки нейронной информации (NeurIPS) исследователи из Google представил работу «Перенос обучения от проверки говорящего на синтез речи с множеством говорящих», в которой переносит обучение из проверки говорящего для получения текста синтез речи, который можно заставить звучать почти как любой из 5-секундного речевого образца (слушать).

Также исследователи из Baidu Research представили клонирование голосов система с аналогичными целями на конференции NeurIPS 2018, хотя результат довольно неубедительный. (слушайте)

К 2019 году цифровые аналоговые звуки попали в руки преступников, поскольку исследователям Symantec известны 3 случая использования цифровых звуковых технологий для преступность.

Это усиливает акцент на ситуации дезинформации в сочетании с фактами, что

В марте 2020 года бесплатно веб-приложение, которое генерирует высококачественные голоса из набора вымышленных персонажей из различных медиаисточников, под названием 15.ai был освобожден. Первыми персонажами были GLaDOS из Portal, Сумеречная Искорка и Флаттершай из сериала My Little Pony: Friendship Is Magic и Десятый Доктор из Доктор Кто. Последующие обновления включали Уитли из Portal 2, Солдата из Team Fortress 2 и оставшийся основной состав My Little Pony: Friendship Is Magic.

Был установлен ряд языков разметки для воспроизведения текста как речи в формате, совместимом с XML. Самым последним из них является язык разметки синтеза речи (SSML), который стал рекомендацией W3C в 2004 году. Старые языки разметки синтеза речи включают язык разметки речи Java (JSML ) и SABLE. Хотя каждый из них был предложен в качестве стандарта, ни один из них не получил широкого распространения.

Языки разметки синтеза речи отличаются от языков разметки диалогов. VoiceXML, например, включает теги, относящиеся к распознаванию речи, управлению диалогами и тональному набору, в дополнение к разметке текста в речь.

Синтез речи долгое время был жизненно важным инструментом вспомогательной технологии, и его применение в этой области широко и широко. Это позволяет устранить экологические барьеры для людей с различными формами инвалидности. Самым долгим применением программ чтения с экрана для людей с нарушением зрения, но системы преобразования текста в речь теперь широко используются людьми с дислексией и другие трудности с чтением, а также у малообразованных детей. Они также часто используются для помощи людям с тяжелыми нарушениями речи, как правило, с помощью специальных средств связи вывода голоса..

Методы синтеза речи также используются в развлекательных программах, таких как игры и анимация. В 2007 году Animo Limited объявила о разработке пакета прикладных программ на основе программного обеспечения для синтеза речи FineSpeech, специально предназначенного для клиентов в индустрии развлечений, способного генерировать повествование и диалоги в соответствии с пользовательскими спецификациями. Приложение достигло зрелости в 2008 году, когда NEC Biglobe анонсировала веб-сервис, который позволяет пользователям создавать фразы из голосов персонажей Code Geass: Lelouch of the Rebellion R2.

В последние годы преобразование текста в речь для людей с ограниченными возможностями и средств коммуникации для лиц с физическими недостатками стало широко использоваться в массовом транспорте. Синтез речи также находит новые применения за пределами рынка людей с ограниченными возможностями. Например, синтез речи в сочетании с распознаванием речи позволяет взаимодействовать с мобильными устройствами через интерфейсы обработки естественного языка.

Преобразование текста в речь также используется при приобретении второго языка. Например, Voki - это образовательный инструмент, созданный Oddcast, который позволяет пользователям создавать свой собственный говорящий аватар, используя разные акценты. Их можно отправлять по электронной почте, размещать на веб-сайтах или публиковать в социальных сетях.

Кроме того, синтез речи является ценным вычислительным помощником для анализа и оценки нарушений речи. Синтезатор качества голоса, разработанный Хорхе К. Лусеро и др. в Университете Бразилиа, моделирует физику фонации и включает модели дрожания и тремора голосовой частоты, шума воздушного потока и асимметрии гортани. Синтезатор использовался для имитации тембра дисфонических динамиков с контролируемыми уровнями грубости, дыхания и напряжения.

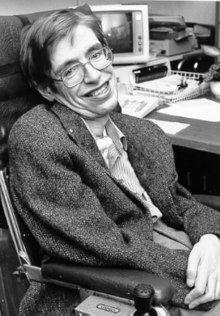

Стивен Хокинг был одним из самых известных людей, использующих речевой компьютер для общения

Стивен Хокинг был одним из самых известных людей, использующих речевой компьютер для общения