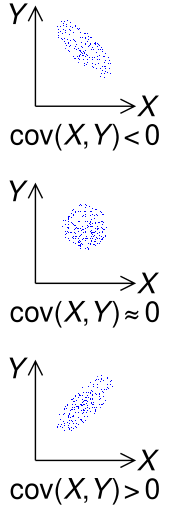

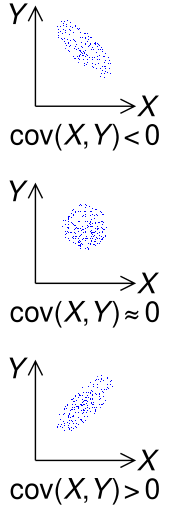

Знак ковариации двух случайных величин X и Y

В теории вероятностей и статистика, ковариация - это мера совместной изменчивости двух случайных величин. Если большие значения одной переменной в основном соответствуют большим значениям другой переменной, и то же самое верно для меньших значений (т. Е. Переменные имеют тенденцию показывать аналогичное поведение), ковариация положительная. В противоположном случае, когда большие значения одной переменной в основном соответствуют меньшим значениям другой (т.е. переменные имеют тенденцию показывать противоположное поведение), ковариация отрицательная. Знак ковариации, таким образом, показывает тенденцию в линейной зависимости между переменными. Величину ковариации непросто интерпретировать, поскольку она не нормирована и, следовательно, зависит от величин переменных. нормализованная версия ковариации, коэффициент корреляции , однако, показывает по своей величине силу линейной связи.

Необходимо различать (1) ковариацию двух случайных величин, которая является параметром population , который можно рассматривать как свойство совместное распределение вероятностей, и (2) ковариация выборки, которая помимо того, что служит дескриптором выборки, также служит в качестве оценочного значения параметра совокупности.

Содержание

- 1 Определение

- 1.1 Определение для сложных случайных величин

- 1.2 Дискретные случайные величины

- 2 Пример

- 3 Свойства

- 3.1 Ковариация с самим собой

- 3.2 Ковариация линейных комбинаций

- 3.3 Ковариационная идентичность Хёффдинга

- 3.4 Некоррелированность и независимость

- 3.5 Связь со внутренними продуктами

- 4 Вычисление выборочной ковариации

- 5 Обобщения

- 5.1 Автоковариационная матрица реальных случайных векторов

- 5.2 Кросс-ковариационная матрица реальных случайных векторов

- 6 Численные вычисления

- 7 Комментарии

- 8 Приложения

- 8.1 В генетике и молекулярной биологии

- 8.2 В финансовой экономике

- 8.3 В метеорологических и океанографических данных ассимиляция

- 8.4 В микрометеорологии

- 8.5 В извлечении признаков

- 8.6 В машинном обучении

- 9 См. также

- 10 Ссылки

Определение

Для двух совместно распределенных вещественные -значные случайные величины  и

и  с конечными секундами, ковариация определяется как ожидаемое значение (или среднее значение) произведения их отклонений от их индивидуальных ожидаемых значений:

с конечными секундами, ковариация определяется как ожидаемое значение (или среднее значение) произведения их отклонений от их индивидуальных ожидаемых значений:

![{\ displaystyle \ operatorname {cov} ( X, Y) = \ operatorname {E} {{\ big [} (X- \ operatorname {E} [X]) (Y- \ operatorname {E} [Y]) {\ big]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f98a8bf924edb41a8025b5ffaa1b255b4a6f48b9) | | (Eq.1) |

где ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) - ожидаемое значение из

- ожидаемое значение из  , также известное как среднее значение

, также известное как среднее значение  . Ковариацию также иногда обозначают как

. Ковариацию также иногда обозначают как  или

или  по аналогии с дисперсией. Используя свойство линейности ожиданий, это можно упростить до ожидаемой стоимости их продукта за вычетом произведения их ожидаемых значений:

по аналогии с дисперсией. Используя свойство линейности ожиданий, это можно упростить до ожидаемой стоимости их продукта за вычетом произведения их ожидаемых значений:

![{\ displaystyle {\ begin {выровнено } \ operatorname {cov} (X, Y) = \ operatorname {E} \ left [\ left (X- \ operatorname {E} \ left [X \ right] \ right) \ left (Y- \ operatorname {E } \ left [Y \ right] \ right) \ right] \\ = \ operatorname {E} \ left [XY-X \ operatorname {E} \ left [Y \ right] - \ operatorname {E} \ left [ X \ right] Y + \ OperatorName {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] \ right] \\ = \ operatorname {E} \ left [XY \ right] - \ имя оператора {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] - \ operatorname {E} \ left [X \ right] \ OperatorName {E} \ left [Y \ right] + \ имя оператора {E} \ left [X \ right] \ OperatorName {E} \ left [Y \ right] \\ = \ operatorname {E} \ left [XY \ right] - \ operatorn ame {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right], \ end {align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b82a8c24b0063ffd95d8624f460acaaacb2a99b3)

но это уравнение подвержен катастрофической отмене (см. раздел о числовых вычислениях ниже).

единицами измерения ковариации  являются те из

являются те из  , умноженные на

, умноженные на  . Напротив, коэффициенты корреляции, которые зависят от ковариации, являются безразмерной мерой линейной зависимости. (Фактически, коэффициенты корреляции можно просто понимать как нормализованную версию ковариации.)

. Напротив, коэффициенты корреляции, которые зависят от ковариации, являются безразмерной мерой линейной зависимости. (Фактически, коэффициенты корреляции можно просто понимать как нормализованную версию ковариации.)

Определение для сложных случайных величин

Ковариация между двумя комплексными случайными величинами  определяется как

определяется как

![{\displaystyle \operatorname {cov} (Z,W)=\operatorname {E} \left[(Z-\operatorname {E} [Z]){\overline {(W-\operatorname {E} [W])}}\right]=\operatorname {E} \left[Z{\overline {W}}\right]-\operatorname {E} [Z]\operatorname {E} \left[{\overline {W}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc823fe25634365b1859a3ee206ca894203a9ee2)

Обратите внимание на комплексное сопряжение второго фактора в определении.

Дискретные случайные величины

Если пара случайных величин  может принимать значения

может принимать значения  для

для  , с равными вероятностями

, с равными вероятностями  , тогда ковариация может быть эквивалентно записана в терминах средних

, тогда ковариация может быть эквивалентно записана в терминах средних ![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93) и

и ![{\displaystyle \operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/639e8577c6faffc0471c7e123ead30970034e6d5) как

как

Это также может быть эквивалентно выражено, без прямой ссылки на средства, как

В целом, если есть  возможных реализаций

возможных реализаций  , а именно

, а именно  , но с возможно неравными вероятностями

, но с возможно неравными вероятностями  для

для  , тогда ковариация

, тогда ковариация

Пример

Геометрическая интерпретация примера ковариации. Каждый детеныш oid - это ограничивающая рамка его точки (x, y, f (x, y)), а значения X и Y (пурпурная точка). Ковариация - это сумма объемов красных кубоидов минус синие кубоиды.

Предположим, что  и

и  имеют следующую функцию совместной вероятности, в которой шесть центральных ячеек дают дискретные совместные вероятности

имеют следующую функцию совместной вероятности, в которой шесть центральных ячеек дают дискретные совместные вероятности  шести гипотетических реализаций

шести гипотетических реализаций  :

:

| x | |  |

|---|

| 5 | 6 | 7 |

|---|

| y | 8 | 0 | 0,4 | 0,1 | 0,5 |

|---|

| 9 | 0,3 | 0 | 0,2 | 0,5 |

|---|

|

| 0,3 | 0,4 | 0,3 | 1 |

|---|

может принимать три значения (5, 6 и 7), а

может принимать три значения (5, 6 и 7), а  может принимать два (8 и 9). Их средние значения равны

может принимать два (8 и 9). Их средние значения равны  и

и  . Тогда

. Тогда

![{\displaystyle {\begin{aligned}\operatorname {co v} (X,Y)={}\sigma _{XY}=\sum _{(x,y)\in S}f(x,y)\left(x-\mu _{X}\right)\left(y-\mu _{Y}\right)\\[4pt]={}(0)(5-6)(8-8.5)+(0.4)(6-6)(8-8.5)+(0.1)(7-6)(8-8.5)+{}\\[4pt](0.3)(5-6)(9-8.5)+(0)(6-6)(9-8.5)+(0.2)(7-6)(9-8.5)\\[4pt]={}{-0.1}\;.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8a80fa4db641ca7ddd6f7a3fee8620eed15321a7)

Свойства

Ковариация с самим собой

Дисперсия - это особый случай ковариации, при котором две переменные идентичны (то есть, когда одна переменная всегда принимает то же значение, что и другое):

Ковариация линейных комбинаций

Если  ,

,  ,

,  и

и  - случайные величины с действительным знаком, а

- случайные величины с действительным знаком, а  - константы с действительным знаком., то следующие факты являются следствием определения ковариации:

- константы с действительным знаком., то следующие факты являются следствием определения ковариации:

Для последовательности  случайных величин в реальном -значное и константы

случайных величин в реальном -значное и константы  , мы имеем

, мы имеем

тождество ковариации Хёффдинга

Полезное тождество для вычисления ковариации между двумя случайными величинами  - тождество ковариации Хёффдинга:

- тождество ковариации Хёффдинга:

где  - совместная кумулятивная функция распределения случайного вектора

- совместная кумулятивная функция распределения случайного вектора  и

и  - это маргиналы.

- это маргиналы.

Некоррелированность и независимость

Случайные переменные, ковариация которых равна нулю, называются некоррелированными. Точно так же компоненты случайных векторов, ковариационная матрица которых равна нулю в каждой записи за пределами главной диагонали, также называются некоррелированными.

Если  и

и  являются независимыми случайными величинами, тогда их ковариация равна нулю. Это следует потому, что при независимости

являются независимыми случайными величинами, тогда их ковариация равна нулю. Это следует потому, что при независимости

![{\displaystyle \operatorname {E} [XY]=\operatorname {E} [X]\cdot \operatorname {E} [Y].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c0c2870ec57051083bd6262aa4069a2500dfda44)

Обратное, однако, обычно неверно. Например, пусть  равномерно распределен в

равномерно распределен в ![[-1,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01) и пусть

и пусть  . Очевидно, что

. Очевидно, что  и

и  не являются независимыми, но

не являются независимыми, но

![{\ displaystyle {\ begin {выровнено} \ operatorname {cov} (X, Y) = \ operatorname {cov} \ left (X, X ^ {2} \ right) \\ = \ operatorname {E} \ left [X \ cdot X ^ {2} \ right] - \ operatorname {E} [X] \ cdot \ operatorname {E} \ left [X ^ {2} \ right] \\ = \ operatorname {E} \ left [X ^ {3} \ right] - \ operatorname {E} [X] \ operatorname {E} \ left [X ^ {2} \ right] \\ = 0-0 \ cdot \ operatorname {E} [X ^ {2}] \ \ = 0. \ конец {выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/19b6f2d636d5ef9ba85b6350e49222109a28d665)

В этом случае связь между  и

и  является нелинейным, а корреляция и ковариация - это меры линейной зависимости между двумя случайными величинами. Этот пример показывает, что если две случайные величины некоррелированы, это, как правило, не означает, что они независимы. Однако, если две переменные совместно нормально распределены (но не если они просто индивидуально нормально распределены ), некоррелированность подразумевает независимость.

является нелинейным, а корреляция и ковариация - это меры линейной зависимости между двумя случайными величинами. Этот пример показывает, что если две случайные величины некоррелированы, это, как правило, не означает, что они независимы. Однако, если две переменные совместно нормально распределены (но не если они просто индивидуально нормально распределены ), некоррелированность подразумевает независимость.

Связь с внутренними продуктами

Многие свойства ковариации можно элегантно выделить, наблюдая, что она удовлетворяет свойствам, аналогичным свойствам внутреннего продукта :

- билинейной : для констант

и

и  и случайных величин

и случайных величин  ,

,

- симметричный:

- положительный полуопределенный :

для всех случайных величин

для всех случайных величин  и

и  означает, что

означает, что  - это константа nt почти наверняка.

- это константа nt почти наверняка.

На самом деле эти свойства подразумевают, что ковариация определяет внутренний продукт по векторному пространству, полученному путем взятия подпространства случайных величин с конечным вторым моментом и идентификации любых двух, которые отличаются на константу. (Это отождествление превращает положительную полуопределенность, приведенную выше, в положительную определенность.) Это фактор-векторное пространство изоморфно подпространству случайных величин с конечным вторым моментом и средним нулем; в этом подпространстве ковариация - это в точности внутреннее произведение L функций с действительными значениями в пространстве выборки.

В результате для случайных величин с конечной дисперсией неравенство

выполняется с помощью неравенства Коши – Шварца.

Доказательство: Если  , то тривиально. В противном случае пусть случайная величина

, то тривиально. В противном случае пусть случайная величина

Тогда мы имеем

![{\displaystyle {\begin{aligned}0\leq \sigma ^{2}(Z)=\operatorname {cov} \left(X-{\frac {\operatorname {cov} (X,Y)} {\sigma ^{2}(Y)}}Y,\;X-{\frac {\operatorname {cov} (X,Y)}{\sigma ^{2}(Y)}}Y\right)\\[12pt]=\sigma ^{2}(X)-{\frac {(\operatorname {cov} (X,Y))^{2}}{\sigma ^{2}(Y)}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fc8741ab12cb5943efe9d8dbfeb455517bc63347)

Вычисление выборочной ковариации

Выборочные ковариации среди  переменных на основе

переменных на основе  наблюдений за каждым из них, взятых из ненаблюдаемой популяции, даются с помощью

наблюдений за каждым из них, взятых из ненаблюдаемой популяции, даются с помощью  матрицы

матрицы ![{\ displaystyle \ textstyle {\ overline {\ mathbf {q}}} = \ left [q_ {jk} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cb28ac928a2a379d039d27fb99d56dd21c1c027c) с записями

с записями

который это оценка ковариации между переменной  и переменная

и переменная  .

.

Выборочное среднее и выборочная ковариационная матрица - это несмещенные оценки для среднего и ковариационная матрица случайного вектора  , вектора, j-й элемент которого

, вектора, j-й элемент которого  - одна из случайных величин. Причина, по которой образец ковариационной матрицы имеет в знаменателе

- одна из случайных величин. Причина, по которой образец ковариационной матрицы имеет в знаменателе  , а не

, а не  по сути, среднее значение генеральной совокупности

по сути, среднее значение генеральной совокупности  неизвестно и заменяется выборочным средним

неизвестно и заменяется выборочным средним  . Если известно среднее значение генеральной совокупности

. Если известно среднее значение генеральной совокупности  , аналогичная несмещенная оценка дается как

, аналогичная несмещенная оценка дается как

.

.

Обобщения

Матрица автоковариации вещественных случайных векторов

Для вектора  из

из  совместно распределенных случайных величин с конечными секундами, его матрица автоковариации (также известная как матрица дисперсии-ковариации или просто ковариационная матрица )

совместно распределенных случайных величин с конечными секундами, его матрица автоковариации (также известная как матрица дисперсии-ковариации или просто ковариационная матрица )  (также обозначается

(также обозначается  ) определяется как

) определяется как

![{\displaystyle {\begin{aligned}\operatorname {K} _{\mathbf {XX} }=\operatorname {cov} (\mathbf {X},\mathbf {X})=\operatorname {E} \left[(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\mathrm {T} }\right]\\=\operatorname {E} \left[\mathbf {XX} ^{\mathrm {T} }\right]-\operatorname {E} [\mathbf {X} ]\operatorname {E} [\mathbf {X} ]^{\mathrm {T} }.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/15725714f72a46ffb0686bafdb209260b842ac39)

Пусть  будет случайным вектор с ковариационной матрицей Σ, и пусть A будет матрицей, которая может воздействовать на

будет случайным вектор с ковариационной матрицей Σ, и пусть A будет матрицей, которая может воздействовать на  слева. Ковариационная матрица произведения матрица-вектор A X имеет вид:

слева. Ковариационная матрица произведения матрица-вектор A X имеет вид:

![{\displaystyle \Sigma (\mathbf {AX})=\operatorname {E} \left[\mathbf {AXX} ^{\mathrm {T} }\mathbf {A} ^{\mathrm {T} }\right]-\operatorname {E} [\mathbf {AX} ]\operatorname {E} \left[\mathbf {X} ^{\mathrm {T} }\mathbf {A} ^{\mathrm {T} }\right]=\mathbf {A} \Sigma \mathbf {A} ^{\mathrm {T} }.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/881ed5c46a0ac079ec7d93d1510b7a8f12b63b26)

Это прямой результат линейности математического ожидания и полезен при применении линейное преобразование, такое как преобразование отбеливания, в вектор.

Матрица кросс-ковариации вещественных случайных векторов

Для реальных случайных векторов  и

и  ,

,  матрица кросс-ковариаций равна

матрица кросс-ковариаций равна

![{\ displaystyle {\ begin {align} \ operatorname {K} _ {\ mathbf {X} \mathbf {Y} }=\operatorname {cov} (\mathbf {X},\mathbf {Y})=\operatorname {E} \left[(\mathbf {X} -\operatorname {E } [ \mathbf {X} ])(\mathbf {Y} -\operatorname {E} [\mathbf {Y} ])^{\mathrm {T} }\right]\\=\operatorname {E} \left[\mathbf {X} \mathbf {Y} ^{\mathrm {T} }\right]-\operatorname {E} [\mathbf {X} ]\operatorname {E} [\mathbf {Y} ]^{\mathrm {T} }\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/99e6f5ef675f7bb826d04f206bd212d14632ab8c) | | (Eq.2) |

где  - транспонировать из t вектор (или матрица)

- транспонировать из t вектор (или матрица)  .

.

The  -й элемент эта матрица равна ковариации

-й элемент эта матрица равна ковариации  между i-м скалярный компонент

между i-м скалярный компонент  и j-й скалярный компонент

и j-й скалярный компонент  . В частности,

. В частности,  - это транспонирование of

- это транспонирование of  .

.

Числовое вычисление

Когда ![\ operatorname {E} [XY] \ приблизительно \ operatorname {E} [X] \ operatorname {E} [Y ]](https://wikimedia.org/api/rest_v1/media/math/render/svg/5cc8091d0da21aa8f5a114797ba5113ddf534f69) , уравнение

, уравнение ![{\displaystyle \operatorname {cov} (X,Y)=\operatorname {E} \left[XY\right]-\operatorname {E} \left[X\right]\operatorname {E} \left[Y\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bdf56a30f7ff1be354713f144bfd02ba949a77f4) подвержен катастрофической отмене, когда вычисляется с помощью арифметики с плавающей запятой, поэтому этого следует избегать в компьютерных программах, когда данные не были центрированы ранее. В этом случае следует отдавать предпочтение численно стабильным алгоритмам. Комментарии

подвержен катастрофической отмене, когда вычисляется с помощью арифметики с плавающей запятой, поэтому этого следует избегать в компьютерных программах, когда данные не были центрированы ранее. В этом случае следует отдавать предпочтение численно стабильным алгоритмам. Комментарии

Ковариацию иногда называют мерой «линейной зависимости» между двумя параметрами. ndom переменные. Это не означает то же самое, что и в контексте линейной алгебры (см. линейная зависимость ). Когда ковариация нормализована, получается коэффициент корреляции Пирсона, который дает степень согласия для наилучшей возможной линейной функции, описывающей связь между переменными. В этом смысле ковариация - это линейная мера зависимости.

Приложения

В генетике и молекулярной биологии

Ковариация - важный показатель в биологии. Определенные последовательности ДНК более консервативны среди видов, чем другие, поэтому для изучения вторичных и третичных структур белков или структур РНК последовательности сравнивают в близкородственные виды. Если изменения последовательности обнаружены или не обнаружены вообще никаких изменений в некодирующей РНК (такой как микроРНК ), обнаруживается, что последовательности необходимы для общих структурных мотивов, таких как петля РНК. В генетике ковариация служит основой для вычисления матрицы генетических родств (GRM) (также известной как матрица родства), позволяя делать выводы о структуре популяции на основе выборки без известных близких родственников, а также делать выводы об оценке наследуемости сложных признаков.

В теории эволюции и естественного отбора уравнение Прайса описывает, как генетический признак частота меняется со временем. В уравнении используется ковариация между признаком и пригодностью, чтобы дать математическое описание эволюции и естественного отбора. Это дает возможность понять влияние передачи генов и естественного отбора на долю генов в каждом новом поколении популяции. Уравнение Прайса было выведено Джорджем Р. Прайсом, чтобы заново вывести W.D. Работа Гамильтона над родственной селекцией. Примеры уравнения Прайса были построены для различных эволюционных случаев.

В финансовой экономике

Ковариации играют ключевую роль в финансовой экономике, особенно в современной теории портфелей и в ценообразовании основных средств. модель. Ковариации между доходностью различных активов используются для определения, при определенных допущениях, относительных сумм различных активов, которые инвесторы должны (в нормативном анализе ) или которые прогнозируются (в положительном анализе ) выберите сохранение в контексте диверсификации.

при ассимиляции метеорологических и океанографических данных

Ковариационная матрица важна для оценки начальных условий, необходимых для запуска моделей прогноза погоды, процедуры, известной как усвоение данных. «Ковариационная матрица ошибок прогноза» обычно строится между возмущениями вокруг среднего состояния (климатологического или ансамблевого). «Ковариационная матрица ошибок наблюдения» построена для представления величины объединенных ошибок наблюдений (по диагонали) и коррелированных ошибок между измерениями (по диагонали). Это пример его широко распространенного применения для фильтрации Калмана и более общего оценки состояния для изменяющихся во времени систем.

В микрометеорологии

Метод ковариации завихрений - это ключевой метод измерения атмосферных воздействий, при котором определяется ковариация между мгновенным отклонением вертикальной скорости ветра от среднего значения и мгновенным отклонением концентрации газа. является основой для расчета вертикальных турбулентных потоков.

При извлечении признаков

Ковариационная матрица используется для определения спектральной изменчивости сигнала.

В машинном обучении

Ковариационная матрица используется в анализ главных компонентов для уменьшения размерности функций при предварительной обработке данных.

См. Также

Ссылки

Знак ковариации двух случайных величин X и Y

Знак ковариации двух случайных величин X и Y

![{\ displaystyle \ operatorname {cov} ( X, Y) = \ operatorname {E} {{\ big [} (X- \ operatorname {E} [X]) (Y- \ operatorname {E} [Y]) {\ big]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f98a8bf924edb41a8025b5ffaa1b255b4a6f48b9)

![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{\ displaystyle {\ begin {выровнено } \ operatorname {cov} (X, Y) = \ operatorname {E} \ left [\ left (X- \ operatorname {E} \ left [X \ right] \ right) \ left (Y- \ operatorname {E } \ left [Y \ right] \ right) \ right] \\ = \ operatorname {E} \ left [XY-X \ operatorname {E} \ left [Y \ right] - \ operatorname {E} \ left [ X \ right] Y + \ OperatorName {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] \ right] \\ = \ operatorname {E} \ left [XY \ right] - \ имя оператора {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] - \ operatorname {E} \ left [X \ right] \ OperatorName {E} \ left [Y \ right] + \ имя оператора {E} \ left [X \ right] \ OperatorName {E} \ left [Y \ right] \\ = \ operatorname {E} \ left [XY \ right] - \ operatorn ame {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right], \ end {align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b82a8c24b0063ffd95d8624f460acaaacb2a99b3)

![{\displaystyle \operatorname {cov} (Z,W)=\operatorname {E} \left[(Z-\operatorname {E} [Z]){\overline {(W-\operatorname {E} [W])}}\right]=\operatorname {E} \left[Z{\overline {W}}\right]-\operatorname {E} [Z]\operatorname {E} \left[{\overline {W}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc823fe25634365b1859a3ee206ca894203a9ee2)

![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{\displaystyle \operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/639e8577c6faffc0471c7e123ead30970034e6d5)

Геометрическая интерпретация примера ковариации. Каждый детеныш oid - это ограничивающая рамка его точки (x, y, f (x, y)), а значения X и Y (пурпурная точка). Ковариация - это сумма объемов красных кубоидов минус синие кубоиды.

Геометрическая интерпретация примера ковариации. Каждый детеныш oid - это ограничивающая рамка его точки (x, y, f (x, y)), а значения X и Y (пурпурная точка). Ковариация - это сумма объемов красных кубоидов минус синие кубоиды.

![{\displaystyle {\begin{aligned}\operatorname {co v} (X,Y)={}\sigma _{XY}=\sum _{(x,y)\in S}f(x,y)\left(x-\mu _{X}\right)\left(y-\mu _{Y}\right)\\[4pt]={}(0)(5-6)(8-8.5)+(0.4)(6-6)(8-8.5)+(0.1)(7-6)(8-8.5)+{}\\[4pt](0.3)(5-6)(9-8.5)+(0)(6-6)(9-8.5)+(0.2)(7-6)(9-8.5)\\[4pt]={}{-0.1}\;.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8a80fa4db641ca7ddd6f7a3fee8620eed15321a7)

![{\displaystyle \operatorname {E} [XY]=\operatorname {E} [X]\cdot \operatorname {E} [Y].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c0c2870ec57051083bd6262aa4069a2500dfda44)

![[-1,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)

![{\ displaystyle {\ begin {выровнено} \ operatorname {cov} (X, Y) = \ operatorname {cov} \ left (X, X ^ {2} \ right) \\ = \ operatorname {E} \ left [X \ cdot X ^ {2} \ right] - \ operatorname {E} [X] \ cdot \ operatorname {E} \ left [X ^ {2} \ right] \\ = \ operatorname {E} \ left [X ^ {3} \ right] - \ operatorname {E} [X] \ operatorname {E} \ left [X ^ {2} \ right] \\ = 0-0 \ cdot \ operatorname {E} [X ^ {2}] \ \ = 0. \ конец {выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/19b6f2d636d5ef9ba85b6350e49222109a28d665)

и

и  и случайных величин

и случайных величин  ,

,

для всех случайных величин

для всех случайных величин  и

и  означает, что

означает, что  - это константа nt почти наверняка.

- это константа nt почти наверняка.

![{\displaystyle {\begin{aligned}0\leq \sigma ^{2}(Z)=\operatorname {cov} \left(X-{\frac {\operatorname {cov} (X,Y)} {\sigma ^{2}(Y)}}Y,\;X-{\frac {\operatorname {cov} (X,Y)}{\sigma ^{2}(Y)}}Y\right)\\[12pt]=\sigma ^{2}(X)-{\frac {(\operatorname {cov} (X,Y))^{2}}{\sigma ^{2}(Y)}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fc8741ab12cb5943efe9d8dbfeb455517bc63347)

![{\ displaystyle \ textstyle {\ overline {\ mathbf {q}}} = \ left [q_ {jk} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cb28ac928a2a379d039d27fb99d56dd21c1c027c)

.

.

![{\displaystyle {\begin{aligned}\operatorname {K} _{\mathbf {XX} }=\operatorname {cov} (\mathbf {X},\mathbf {X})=\operatorname {E} \left[(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\mathrm {T} }\right]\\=\operatorname {E} \left[\mathbf {XX} ^{\mathrm {T} }\right]-\operatorname {E} [\mathbf {X} ]\operatorname {E} [\mathbf {X} ]^{\mathrm {T} }.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/15725714f72a46ffb0686bafdb209260b842ac39)

![{\displaystyle \Sigma (\mathbf {AX})=\operatorname {E} \left[\mathbf {AXX} ^{\mathrm {T} }\mathbf {A} ^{\mathrm {T} }\right]-\operatorname {E} [\mathbf {AX} ]\operatorname {E} \left[\mathbf {X} ^{\mathrm {T} }\mathbf {A} ^{\mathrm {T} }\right]=\mathbf {A} \Sigma \mathbf {A} ^{\mathrm {T} }.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/881ed5c46a0ac079ec7d93d1510b7a8f12b63b26)

![{\ displaystyle {\ begin {align} \ operatorname {K} _ {\ mathbf {X} \mathbf {Y} }=\operatorname {cov} (\mathbf {X},\mathbf {Y})=\operatorname {E} \left[(\mathbf {X} -\operatorname {E } [ \mathbf {X} ])(\mathbf {Y} -\operatorname {E} [\mathbf {Y} ])^{\mathrm {T} }\right]\\=\operatorname {E} \left[\mathbf {X} \mathbf {Y} ^{\mathrm {T} }\right]-\operatorname {E} [\mathbf {X} ]\operatorname {E} [\mathbf {Y} ]^{\mathrm {T} }\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/99e6f5ef675f7bb826d04f206bd212d14632ab8c)

![\ operatorname {E} [XY] \ приблизительно \ operatorname {E} [X] \ operatorname {E} [Y ]](https://wikimedia.org/api/rest_v1/media/math/render/svg/5cc8091d0da21aa8f5a114797ba5113ddf534f69)

![{\displaystyle \operatorname {cov} (X,Y)=\operatorname {E} \left[XY\right]-\operatorname {E} \left[X\right]\operatorname {E} \left[Y\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bdf56a30f7ff1be354713f144bfd02ba949a77f4)